溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

這篇文章主要介紹在單機環境下Spark History Server如何配置,文中介紹的非常詳細,具有一定的參考價值,感興趣的小伙伴們一定要看完!

首先修改兩個配置文件

vim spark-env.sh

export SPARK_MASTER_IP=***.***.***.*** export SPARK_HISTORY_OPTS="-Dspark.history.ui.port=18080 -Dspark.history.retainedApplications=10 -Dspark.history.fs.logDirectory=file:///home/zzx/spark-1.1.0-bin-hadoop1/historylogs" export SPARK_CONF_DIR=/home/zzx/spark-1.1.0-bin-hadoop1/conf

vim spark-defaults.conf

spark.eventLog.enabled true spark.eventLog.dir file:///home/zzx/spark-1.1.0-bin-hadoop1/historylogs spark.history.fs.logDirectory file:///home/zzx/spark-1.1.0-bin-hadoop1/historylogs

配置完后記得source一下 這里文件路徑原本是HDFS路徑 但是在后面測試過程中無論運行多少次程序,History Server頁面一直是空白狀態,后面改成本地文本路徑就行了

然后啟動spark,以及Spark History Server

sbin/start-all.sh sbin/start-history-server.sh

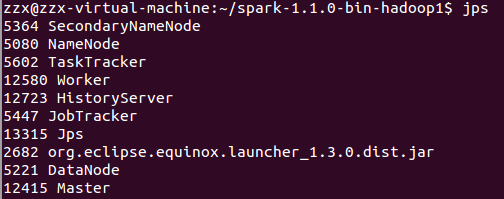

jps查看狀態

在CLI命令行界面測試運行spark自帶的例子SparkPi

bin/run-example SparkPi

運行多次程序后,根據SPARK_MASTER_IP加上端口號18080即可訪問頁面

在eclipse運行程序的時候,記得加上一段代碼,因為eclipse提交程序不像CLI會查看spark的conf文件,所以這里需要手動加入,注意程序最后記得關閉sc,如下:

val conf = new SparkConf().setAppName("SparkWordCount")

.setMaster("local")

.set("spark.eventLog.enabled","true")

.set("spark.eventLog.dir","/home/zzx/spark-1.1.0-bin-hadoop1/historylogs")

val sc = new SparkContext(conf) //設置sc

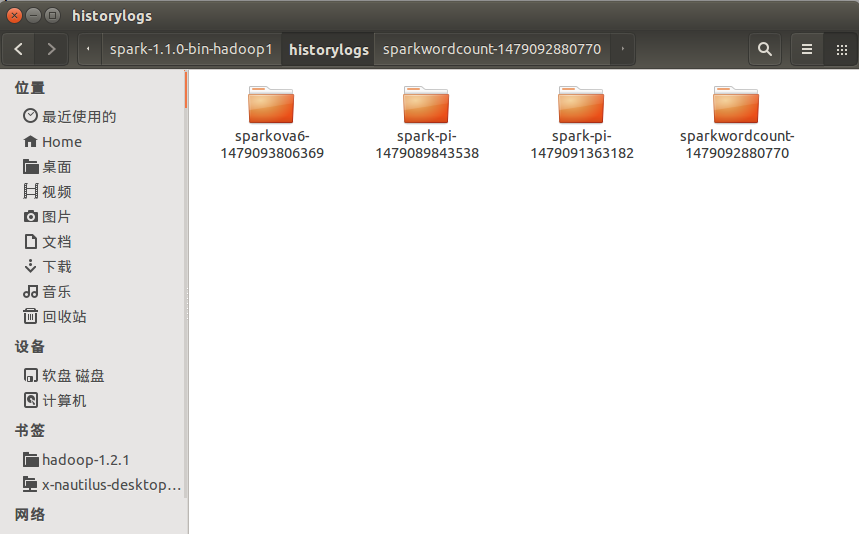

sc.stop //關閉sc在配置的文件路徑下也可以查看到歷史記錄信息:

以上是“在單機環境下Spark History Server如何配置”這篇文章的所有內容,感謝各位的閱讀!希望分享的內容對大家有幫助,更多相關知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。