您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關如何安裝spark依賴yarn執行,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

由于之前安裝hadoop版本是3.30 所以這里下載spark3

spark下載地址 包含了對應hadoop3的jar包 http://archive.apache.org/dist/spark/spark-3.0.1/spark-3.0.1-bin-hadoop3.2.tgz

完成之后解壓 tar -zxvf spark-3.0.1-bin-hadoop3.2.tgz mv spark-3.0.1-bin-hadoop3.2 spark-3

修改hadoop配置文件/opt/module/hadoop/etc/hadoop/yarn-site.xml, 并分發

修改hadoop配置文件/opt/module/hadoop/etc/hadoop/yarn-site.xml, 并分發 <!--是否啟動一個線程檢查每個任務正使用的物理內存量,如果任務超出分配值,則直接將其殺掉,默認是true --> <property> <name>yarn.nodemanager.pmem-check-enabled</name> <value>false</value> </property> <!--是否啟動一個線程檢查每個任務正使用的虛擬內存量,如果任務超出分配值,則直接將其殺掉,默認是true --> <property> <name>yarn.nodemanager.vmem-check-enabled</name> <value>false</value> </property>

修改配置文件 spark-env.sh

#jdk路徑 export JAVA_HOME=/bigdata/jdk1.8.0_161 #yarn路徑 YARN_CONF_DIR=/bigdata/hadoop-3.3.0/etc/hadoop #歷史服務配置 export SPARK_HISTORY_OPTS=" -Dspark.history.ui.port=18080 -Dspark.history.fs.logDirectory=hdfs://hadoop1:9000/directory -Dspark.history.retainedApplications=30"

修改 spark-defaults.conf

spark.eventLog.enabled true #hdfs地址 路徑是先建好的 hdfs dfs -mkdir /directory spark.eventLog.dir hdfs://hadoop1:9000/directory #歷史服務的web地址 spark.yarn.historyServer.address=hadoop1:18080 spark.history.ui.port=18080 #jar包托管在hdfs中的地址 spark.yarn.jars hdfs://hadoop1:9000/hadoop/spark_jars/*

將spark整合hadoop3的jar包傳到hdfs上

hdfs dfs -mkdir /hadoop hdfs dfs -mkdir /hadoop/spark_jars hdfs dfs -put /usr/local/spark-3/jars/* /hadoop/spark_jars

啟動歷史服務 sbin/start-history-server.sh

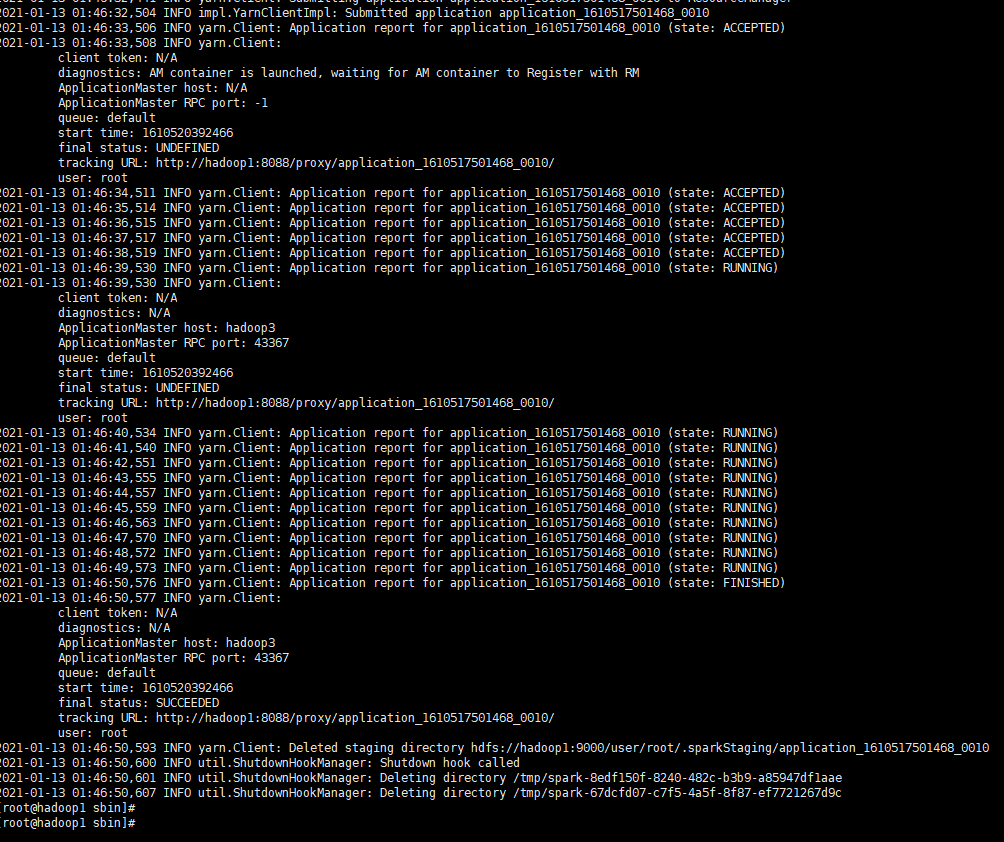

訪問ui沒有問題后創建一個測試任務

/bigdata/spark/bin/spark-submit --class mapTest --master yarn --driver-memory 512m --executor-memory 512m --deploy-mode cluster /spark-demo.jar

完成

關于“如何安裝spark依賴yarn執行”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。