您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

今天就跟大家聊聊有關如何部署Spark集群,可能很多人都不太了解,為了讓大家更加了解,小編給大家總結了以下內容,希望大家根據這篇文章可以有所收獲。

1. 安裝環境簡介

硬件環境:兩臺四核cpu、4G內存、500G硬盤的虛擬機。

軟件環境:64位Ubuntu12.04 LTS;主機名分別為spark1、spark2,IP地址分別為1**.1*.**.***/***。JDK版本為1.7。集群上已經成功部署了Hadoop2.2,詳細的部署過程可以參見另一篇文檔Yarn的安裝與部署。

2. 安裝Scala2.9.3

1)在/home/test/spark目錄下面運行wget http://www.scala-lang.org/downloads/distrib/files/scala-2.9.3.tgz命令,下載scala的二進制包。

2) 解壓下載后的文件,配置環境變量:編輯/etc/profile文件,添加如下內容:

export SCALA_HOME=/home/test/spark/scala/scala-2.9.3 export PATH=$SCALA_HOME/bin

3)運行source /etc/profile使環境變量的修改立即生效。在spark2上執行相同的操作,安裝scala。

3. 下載編譯好的spark文件,地址為:http://d3kbcqa49mib13.cloudfront.net/spark-0.8.1-incubating-bin-hadoop2.tgz。下載后解壓。

4.配置conf/spark-env.sh環境變量,添加如下內容:

export SCALA_HOME=/home/test/spark/scala/scala-2.9.3

5. 在/etc/profile中配置SPARK_EXAMPLES_JAR以及spark的環境變量:添加如下內容:

export SPRAK_EXAMPLES_JAR=/home/test/spark/spark-0.8.1-incubating-bin-hadoop2/examples/target/scala-2.9.3/spark-examples_2.9.3-assembly-0.8.1-incubating.jar export SPARK_HOME=/home/test/spark/spark-0.8.1-incubating-bin-hadoop2 export PATH=$SPARK_HOME/bin

6. 修改/conf/slaves文件,在文件中添加如下內容:

spark1 spark2

7.使用scp命令將上述文件拷貝到spark節點的相同路徑下面scp -rspark-0.8.1-incubating-bin-hadoop2 test@spark2:/home/test/spark:

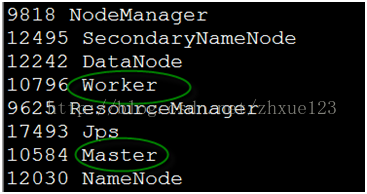

8. 在spark1上啟動spark集群,并檢查進程是否成功啟動。如下master和worker已經成功啟動。

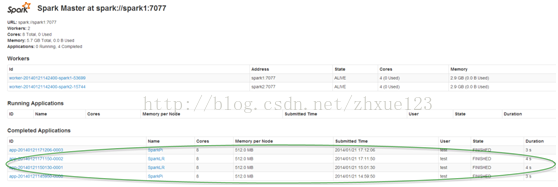

使用瀏覽器打開http://1**.**.*.***:8080/,其顯示如下所示:

可以看到集群中的兩個slave節點已經成功啟動。

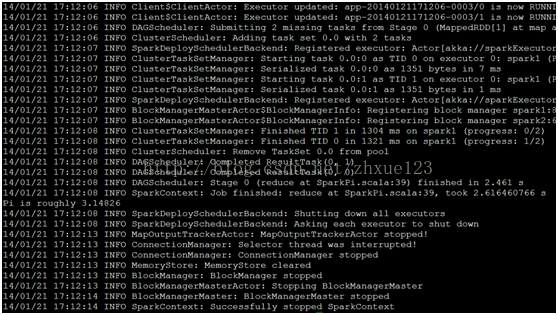

9. 運行spark自帶的例子:./run-exampleorg.apache.spark.examples.SparkPi spark://master:7077,其結果如下所示:

在web界面能看到剛才運行的job如下所示:

看完上述內容,你們對如何部署Spark集群有進一步的了解嗎?如果還想了解更多知識或者相關內容,請關注億速云行業資訊頻道,感謝大家的支持。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。