溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關使用python爬蟲怎么結合唧唧對Bilibili進行爬取,文章內容質量較高,因此小編分享給大家做個參考,希望大家閱讀完這篇文章后對相關知識有一定的了解。

1.依賴庫

requestsl

xml

2.代碼

相關講解已在注釋標注。

'''

author:Ericam

description: 用于爬取b站視頻鏈接

'''

import requests

import re

from lxml import etree

import time

'''

該函數用于解析爬取的網頁。

提取出網頁里視頻的url鏈接以及對應的視頻名。

'''

def getHref(url,page):

try:

req = requests.get(url,timeout=5,headers=headers)

html = req.text

data = etree.HTML(html)

'''

page-1://*[@id="all-list"]/div[1]/div[2]/ul[@class="video-list"]/li

other://*[@id="all-list"]/div[1]/ul[@class="video-list"]/li

'''

pattern = '//*[@id="all-list"]/div[1]/div[2]/ul[contains(@class,"video-list")]/li' if page == 1 else '//*[@id="all-list"]/div[1]/ul[contains(@class,"video-list")]/li'

vurlList = data.xpath(pattern)

for li in vurlList:

vurl = li.xpath(".//a/attribute::href")[0]

title = li.xpath(".//a/attribute::title")[0]

yield vurl,title

except:

print('第%d頁爬取失敗' % page)

print('Unfortunitely -- An Unknow Error Happened, Please wait 3 seconds')

time.sleep(3)

'''

該函數用于正則提取,將url內的BV號提取出來

'''

def getBv(href):

pattern = re.compile('(BV.*?)\?')

data = re.search(pattern,href)

if data == None:

return ''

return data.group(1)

if __name__ == "__main__":

#頭部偽裝

headers = {

'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36 QIHU 360SE'

}

hrefList = []

titleList = []

#需要爬取多少頁,自行進行修改,本代碼測試1~2頁

for i in range(1,3):

url = "https://search.bilibili.com/all?keyword=歪嘴戰神&page={0}".format(i) #修改keyword后的關鍵字即可

l = getHref(url,i)

for vurl,title in l:

hrefList.append(vurl)

titleList.append(title)

print("第{0}頁爬取結束".format(i))

time.sleep(2)

print("---------------------------開始截取BV號-----------------------------")

for i in range(len(hrefList)):

hrefList[i] = getBv(hrefList[i])

with open("bv.txt",'w',encoding='utf-8') as f:

for i in range(len(hrefList)):

f.write(hrefList[i]+"\t"+titleList[i]+"\n")

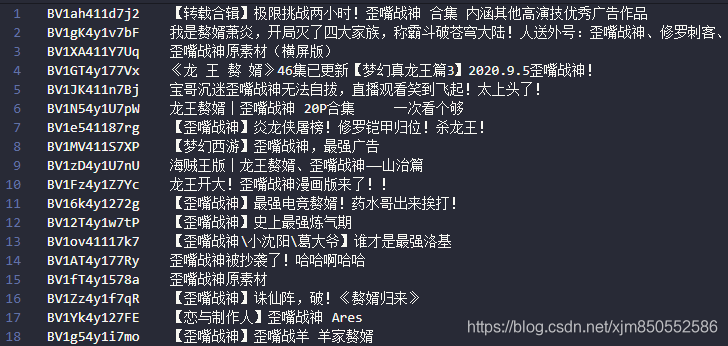

print("爬取結束")3.爬取結果

給出唧唧的鏈接,唧唧,很好用的小工具。

我們只需要將剛才爬取好的鏈接放在一邊,不斷復制BV號,然后唧唧進行下載即可。

唧唧下載好的視頻如下所示:

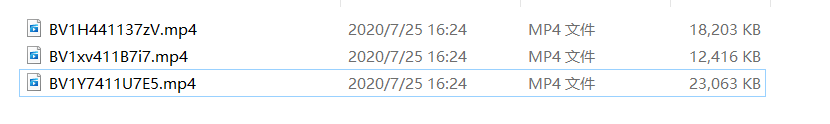

為什么需要將它們進行改名呢,因為如果當視頻數量越來越多時,比如幾千幾萬時,通過名字便會越來越難以管理,同時也難以進行去重,很大概率會不斷下載重復的視頻。

在B站,BV號便是每個視頻的“身份證”(主鍵),因此用其進行視頻命名可以方便日后管理,同時也方便進行去重。

代碼

'''

author:Ericam

description: 用于將下載下來的b站視頻重命名,命名格式為bv號

'''

import os

import difflib

if __name__ == '__main__':

bvpath = os.path.join("D:/","Coding","python","Python爬蟲")

os.chdir(bvpath)

d = {}

'''

bvdownload.txt里存放bv號與title名

若之前爬蟲爬取了幾千個,而唧唧只下載了幾百個,便可以將這些已下載的bv和title復制到

bvdownload.txt中,將已下載的視頻進行改名

'''

with open("bvdownload.txt",'r',encoding='utf-8')as f:

lines = f.readlines()

for val in lines:

val = val.strip("\n")

data = val.split("\t")

bv = data[0]

title = data[1]

d[title] = bv

#視頻存放位置

path = 'F:/bilibili視頻/'

os.chdir(path)

videoList = os.listdir()

#開始進行模糊匹配

for key in d:

video = difflib.get_close_matches(key,videoList,1, cutoff=0.3)

if len(video) == 0:

continue

video = video[0]

#檢查視頻是否已存在,若存在則刪除視頻

if os.path.isfile(d[key]+".mp4") and os.path.isfile(video):

os.remove(video)

else:

if os.path.isfile(video):

os.rename(video,d[key]+".mp4")

print("重命名完成!")結果演示

重命名完成的視頻列表如下:

關于使用python爬蟲怎么結合唧唧對Bilibili進行爬取就分享到這里了,希望以上內容可以對大家有一定的幫助,可以學到更多知識。如果覺得文章不錯,可以把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。