您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

多維分析(BI)系統后臺數據源通常有三種選擇。一、普通數據庫;二、專業數據倉庫;三、BI 系統自帶的數據源。

但是,這三種選擇都有各自的問題。普通數據庫一般都是行式存儲,很難獲得多維分析希望的高性能,只適用較小數據量。專業數據倉庫有不少是列式存儲的,性能問題不大,但是價格都比較昂貴,建設、擴展和維護成本也都非常高。BI 系統自帶的數據源都比較封閉,只能為自家的 BI 前端提供支持,無法為多個不同廠家的前端提供數據服務。

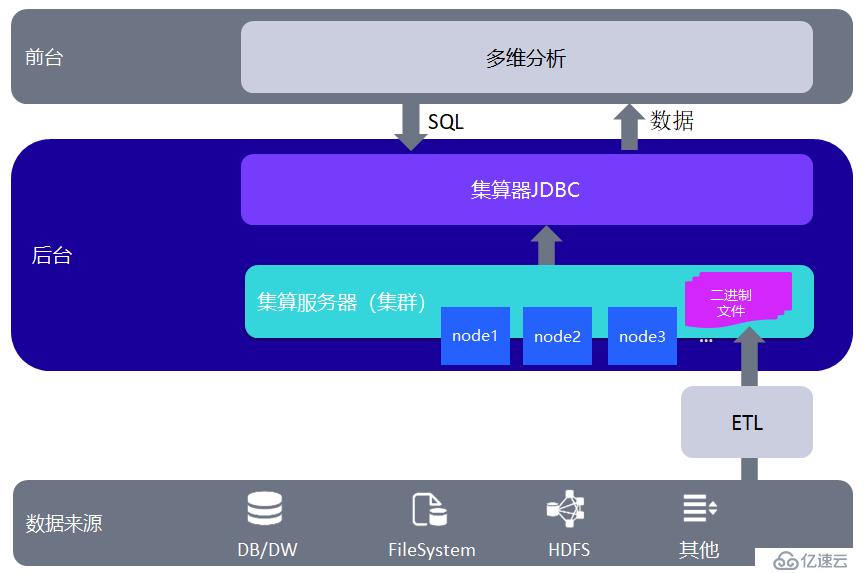

集算器可以獨立承擔輕量級多維分析后臺的作用,相當于中小型數據倉庫或者數據集市。結構圖如下:

集算器可以將多維分析的數據事先以列存形式存儲到二進制文件中,稱為組表。多維分析前端應用拖拽生成 SQL,通過集算器 JDBC 提交。集算器對組表執行 SQL 查詢,將結果返回給多維分析前端。組表文件也可由集算器從各種異構數據源采集數據并計算而來。

和普通數據庫方案相比,集算器列存的二進制文件能夠直接提升性能。而對于昂貴的專業數據庫和相對封閉的 BI 自帶數據源,集算器可以提供更加經濟、簡便的解決方案,并能夠從各種異構數據源采集數據。

集算器有三種部署方式:1、集成在前端應用中;2、獨立服務器;3、集群熱備。下面介紹具體方法。

在下面的案例中,多維分析系統要針對訂單數據做自助分析。為了簡化起見,多維分析系統前臺用 tomcat 服務器中的 jdbc.jsp 來模擬。Tomcat 安裝在 windows 操作系統的 C:\tomcat6。

集算器 JDBC 集成在多維分析應用中。jdbc.jsp 模仿多維分析應用系統,產生符合集算器規范的 SQL,通過集算器 JDBC 提交給集算器 SPL 腳本處理。

多維分析系統的數據來自于生產數據庫 demo 中的 ORDERS 表,生產庫是 ORACLE 數據庫。多維分析系統不能直接連 demo 數據庫實現分析,以免給生產數據庫帶來過多的壓力。ORDERS 訂單表是全量數據,集算器 ETL 每天將當天的最新數據同步到組表文件中。日期以訂購日期 ORDERDATE 為準,假設當前的日期是 2015-07-18。

用下面的 ordersAll.sql 文件在 ORACLE 數據庫中完成 ORDERS 表的建表和數據初始化。

ordersAll

數據截止到 2017 年 7 月 17 日。

多維分析系統后臺上線初始化的時候,要將 ORDERS 表中的歷史數據同步到集算器的二進制文件中。這是上線前一次性執行的準備工作,上線運行后就不需要執行了。

在集算器中,新建一個數據源 orcl,連接 ORACLE 數據庫。用 SPL 語言腳本 etlAll.dfx 將全部數據讀取到集算器組表文件 orders.ctx 中。SPL 腳本如下:

| A | B | |

|---|---|---|

| 1 | =connect(“orcl”) | =A1.cursor@d(“select ORDERDATE,CUSTOMERID,EMPLOYEEID,ORDERID,AMOUNT from ORDERS order by ORDERDATE,CUSTOMERID,EMPLOYEEID,ORDERID”) |

| 2 | =file(“C:/tomcat6/webapps/DW/WEB-INF/data/orders.ctx”) | |

| 3 | =A2.create(#ORDERDATE,#CUSTOMERID,#EMPLOYEEID,#ORDERID,AMOUNT) | |

| 4 | =A3.append(B1) | >A1.close() |

Orders.ctx 是組表文件,默認是采用列式存儲的,支持任意分段的并行計算,可以有效提升查詢速度。生成組表的時候,要注意數據預先排序和合理定義維字段。本例中,按照經常過濾、分組的字段,將維字段確定為:ORDERDATE,CUSTOMERID,EMPLOYEEID, ORDERID。

從 ORACLE 中取得數據的時候,要按照維字段排序。因為 ORDERDATE,CUSTOMERID,EMPLOYEEID 對應的重復數據多,所以放在前面排序;ORDERID 對應的重復數據少,所以放在后面排序。

B1 單元格中數據庫游標的 @d 選項,表示從 ORACLE 數據庫中取數的時候將 numeric 型數據轉換成 double 型,精度對于金額這樣的常見數值完全足夠了。如果沒有這個選項就會默認轉換成 big decimal 型數據,計算性能會受到較大影響。

多維分析系統上線之后,要每天晚上定時同步當天最新的數據。我們假設當天日期是 2015-07-18。用下面的 ordersUpdate.sql 文件在 ORACLE 數據庫給 ORDERS 表增加當天的數據,模擬數據的增量。

ordersUpdate

用 SPL 語言腳本 etlUpdate1.dfx 將當天數據增量補充到集算器組表文件 orders.ctx 中。SPL 腳本如下:

| A | B | C | |

|---|---|---|---|

| 1 | =connect(“orcl”) | ||

| 2 | =A1.cursor@d(“select ORDERDATE,CUSTOMERID,EMPLOYEEID,ORDERID,AMOUNT from ORDERS where ORDERDATE=? order by ORDERDATE,CUSTOMERID,EMPLOYEEID,ORDERID”,etlDate) | ||

| 3 | =file(“C:/tomcat6/webapps/DW/WEB-INF/data/orders.ctx”) | ||

| 4 | =A3.create() | =A4.append(A2) | =A3.rollback() |

| 5 | >A1.close() |

etlUpdate.dfx 的輸入參數是 etlDate,也就是需要新增的當天日期。

B4 單元格直接將新數據追加到組表文件中。因為第一個排序字段是 orderdate,所以追加新數據不會影響排序。如果第一個排序字段不是 orderdate,就要重新排序。

C4 中的 rollback 是回滾函數,若 B4 執行 append 過程中,出現錯誤,那么將執行回滾操作,恢復到 append 操作之前的組表狀態。正常執行完畢,則不會回滾。

etlUpdate1.dfx 腳本可以用 windows 或者 linux 命令行的方式執行,結合定時任務,可以定時執行。也可以用 ETL 工具來定時調用。

windows 命令行的調用方式是:

C:\\Program Files\\raqsoft\\esProc\\bin>esprocx.exe C: \\etlUpdate1.dfx

linux 命令是:

/raqsoft/esProc/bin/esprocx.sh /esproc/ etlUpdate1.dfx

集算器 JDBC 集成在多維分析的應用中,接收到 SQL 后查本地文件 orders.ctx 返回結果。

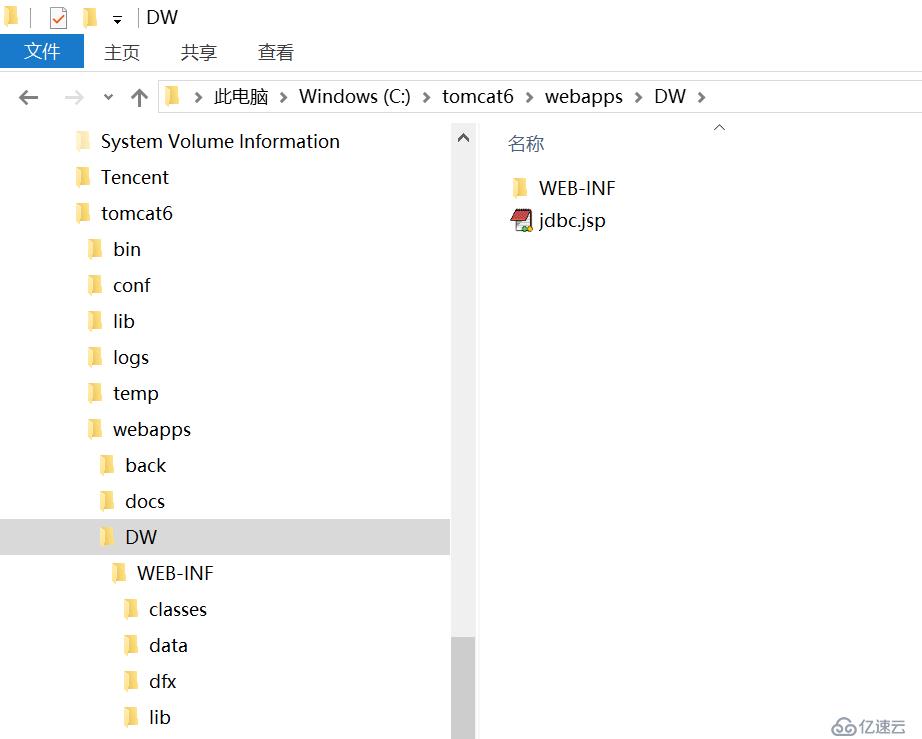

1、下面壓縮文件中的 DW 目錄復制到 tomcat 的應用目錄。

DW

目錄結構如下圖:

配置文件在 classes 中,在官網上獲取的授權文件也要放在 classes 目錄中。集算器的 Jar 包要放在 lib 目錄中(需要哪些 jar 請參照集算器教程)。

修改 raqsoftConfig.xml 中的主目錄配置:

<mainPath>C:\\tomcat6\\webapps\\DW\\WEB-INF\\data</mainPath>

配置好主目錄后,orders.ctx 就可以不寫全路徑名,直接寫 from orders.ctx 即可。

2、編輯 DW 目錄中的 jdbc.jsp,模擬前臺界面提交 sql 展現結果。

<%@ page language=”java” import=”java.util.*” pageEncoding=”utf-8″%>

<%@ page import=”java.sql.*” %>

<body>

<%

String driver = “com.esproc.jdbc.InternalDriver”;

String url = “jdbc:esproc:local://”;

try {

Class.forName(driver);

Connection conn = DriverManager.getConnection(url);

Statement statement = conn.createStatement();

String sql =”select top 10 ORDERID,CUSTOMERID,EMPLOYEEID,ORDERDATE,AMOUNT from ORDERS.ctx where ORDERDATE=date(‘2015-07-18’) and AMOUNT>100″;

out.println(“Test page v1<br><br><br><pre>”);

out.println(“訂單ID”+”\\t”+”客戶ID”+”\\t”+”雇員ID”+”\\t”+”訂購日期”+”\\t”+”訂單金額”+”<br>”);

ResultSet rs = statement.executeQuery(sql);

int f1,f6;

String f2,f3,f4;

float f5;

while (rs.next()) {

f1 = rs.getInt(“ORDERID”);

f2 = rs.getString(“CUSTOMERID”);

f3 = rs.getString(“EMPLOYEEID”);

f4 = rs.getString(“ORDERDATE”);

f5 = rs.getFloat(“AMOUNT”);

out.println(f1+”\\t”+f2+”\\t”+f3+”\\t”+f4+”\\t”+f5+”\\t”+”<br>”);

}

out.println(“</pre>”);

rs.close();

conn.close();

} catch (ClassNotFoundException e) {

System.out.println(“Sorry,can`t find the Driver!”);

e.printStackTrace();

} catch (SQLException e) {

e.printStackTrace();

} catch (Exception e) {

e.printStackTrace();

}

%>

</body><%@ page language=”java” import=”java.util.*” pageEncoding=”utf-8″%><%@ page import=”java.sql.*” %><body><%String driver = “com.e

sproc.jdbc.InternalDriver”;String url = “jdbc:esproc:local://”;try {Class.forName(driver);Connection conn = DriverManager.getConnection(url);S

tatement statement = conn.createStatement();String sql =”select top 10 ORDERID,CUSTOMERID,EMPLOYEEID,ORDERDATE,AMOUNT from ORDERS.ctx where ORD

ERDATE=date(‘2015-07-18’) and AMOUNT>100″;

out.println(“Test page v1<br><br><br><pre>”);

out.println(“訂單ID”+”\\t”+”客戶ID”+”\\t”+”雇員ID”+”\\t”+”訂購日期”+”\\t”+”訂單金額”+”<br>”);

ResultSet rs = statement.executeQuery(sql);

int f1,f6;

String f2,f3,f4;

float f5;

while (rs.next()) {

f1 = rs.getInt(“ORDERID”);

f2 = rs.getString(“CUSTOMERID”);

f3 = rs.getString(“EMPLOYEEID”);

f4 = rs.getString(“ORDERDATE”);

f5 = rs.getFloat(“AMOUNT”);

out.println(f1+”\\t”+f2+”\\t”+f3+”\\t”+f4+”\\t”+f5+”\\t”+”<br>”);

}

out.println(“</pre>”);

rs.close();

conn.close();

} catch (ClassNotFoundException e) {

System.out.println(“Sorry,can`t find the Driver!”);

e.printStackTrace();

} catch (SQLException e) {

e.printStackTrace();

} catch (Exception e) {

e.printStackTrace();

}

%></body>可以看到,jsp 中先連接集算器的 JDBC,然后提交執行 SQL。步驟和一般的數據庫完全一樣,具有很高的兼容性和通用性。對于多維分析工具來說,雖然是界面操作來連接 JDBC 和提交 SQL,但是基本原理和 jsp 完全一樣。

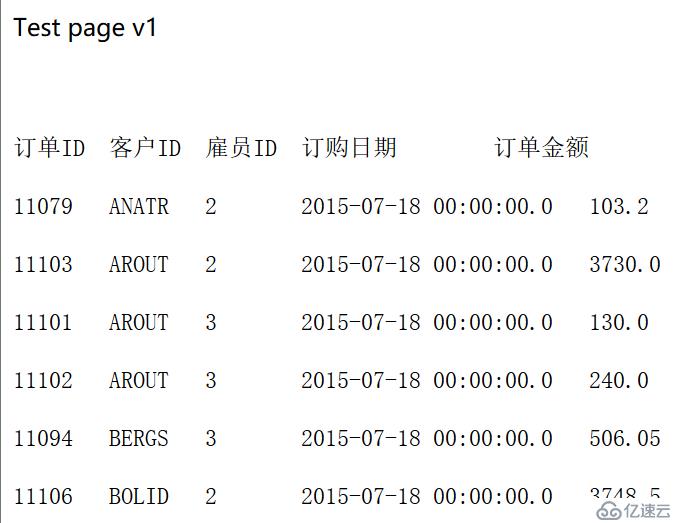

3、啟動 tomcat,在瀏覽器中訪問 http://localhost:8080/DW/jdbc.jsp,查看結果。

還可以繼續測試如下情況:

1、分組匯總

sql ="select CUSTOMERID,EMPLOYEEID,sum(AMOUNT) 訂單總額,count(1) 訂單數量 from ORDERS.ctx where ORDERDATE=date(‘2015-07-18’) group by CUSTOMERID,EMPLOYEEID";

2、并行查詢

sql="select /*+ parallel (4) */ top 10 ORDERID,CUSTOMERID,EMPLOYEEID,ORDERDATE,AMOUNT from ORDERS.ctx where ORDERDATE=date(‘2015-07-18’) and AMOUNT>100"sql="select /*+ parall el (4) */top 10 ORDERID,CUSTOMERID,EMPLOYEEID,ORDERDATE,AMOUNT from ORDERS.ctx where ORDERDATE=date(‘2015-07-18’) and AMOUNT>100"

和 ORACLE 類似,集算器簡單 SQL 也支持 /*+ parallel (4) */ 這樣的并行查詢。

第一種解決辦法是利用應用服務器的資源。在并發量很大,或者數據量很大的情況下,應用服務器會出現較大壓力。這種情況下,推薦用獨立的節點服務器進行數據計算。

集算器 JDBC 接收到 SQL 后,轉給 DW.dfx 程序處理。DW.dfx 調用節點服務器上的 DWServer.dfx 進行計算。DWServer.dfx 把表名換成文件名,查本地文件 orders.ctx 返回結果。

下面的 DWServer 目錄復制到需要的目錄。集算器的節點服務器具備跨平臺的特性,可以運行在任何支持 Java 的操作系統上,部署方法參見集算器教程。這里假設放到 windows 操作系統的 C 盤根目錄。

DWServer

1、系統上線之前執行初始化 dfx,將 orders.ctx 文件放到 C:/DWServer/data 目錄中。測試的時候可以直接將已經生成好的 orders.ctx 復制過去。

2、修改前面的 dfx,將 A1 改為 =file(“C:/DWServer/data/orders.ctx”),另存為 etlUpdate2.dfx。修改好的 etlUpdate2.dfx 在 c:\DWServer 目錄。

3、打開應用服務器中的 C:\\tomcat6\\webapps\\DW\\WEB-INF\\dfx\\DW.dfx,觀察理解 SPL 代碼。參數 sql 是傳入的 SQL 語句。

| A | B | |

|---|---|---|

| 1 | =callx(“DWServer.dfx”,[sql];[“127.0.0.1:8281”]) | |

| 2 | return A1.ifn() |

A1:調用節點機上的 DWServer.dfx。參數是 [sql],中括號表示序列,此時是只有一個成員的序列。[“127.0.0.1:8281”] 是節點機的序列,采用 IP: 端口號的方式。

A2:返回 A1 調用的結果。因為調用結果是序列,所以要用 ifn 函數找到序列中第一個不為空的成員,就是 SQL 對應的返回結果。

修改 C:\\tomcat6\\webapps\\DW\\WEB-INF\\classes\\raqsoftConfig.xml 中的如下配置:

<mainPath>C:\\tomcat6\\webapps\\DW\\WEB-INF\\dfx</mainPath> <JDBC> <load>Runtime,Server</load> <gateway>DW.dfx</gateway> </JDBC><mainPath>C:\\tomcat6\\webapps\\DW\\WEB-INF\\dfx</mainPath><JDBC><load>Runtime,Server</load><gateway>DW.dfx</gateway></JDBC>

這里標簽的內容就是 JDBC 網關 dfx 文件。在 BI 系統中調用集算器 JDBC 時,所執行的 SQL 都將交由網關文件處理。如果不配置這個標簽,JDBC 提交的語句會被集算器當作腳本直接解析運算。

4、啟動節點服務器。

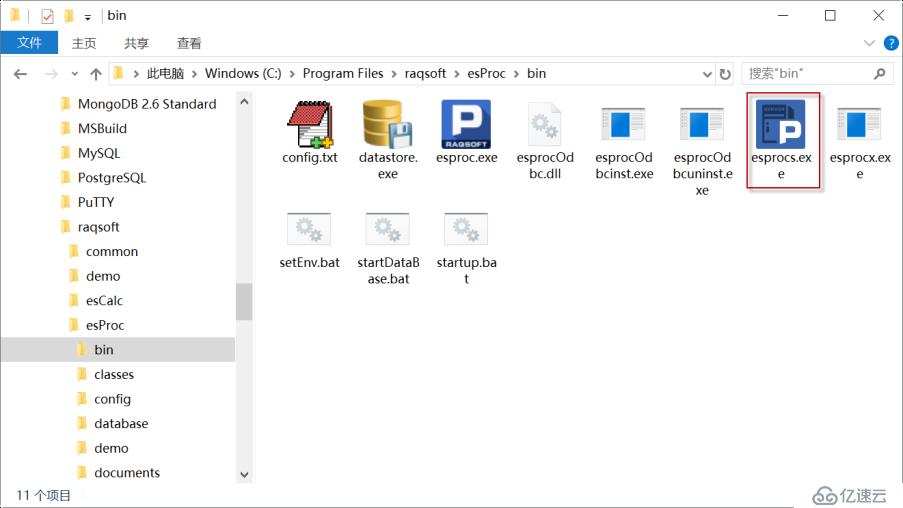

運行 esprocs.exe, 如下圖:

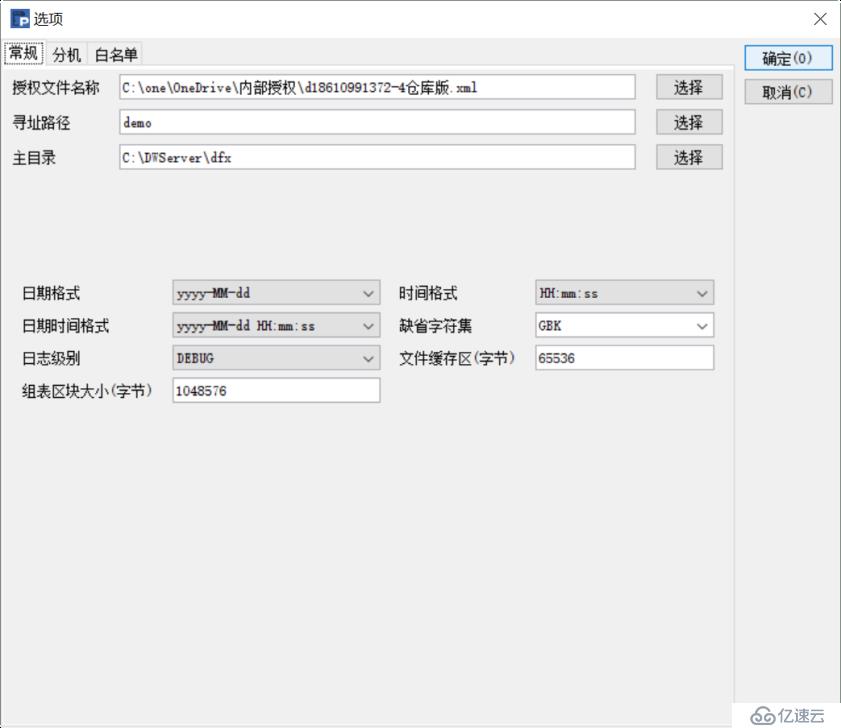

點擊配置按鈕,配置相關參數:

點擊確定后,返回主界面,點擊啟動按鈕。

5、打開 C:\DWServer\dfx\DWServer.dfx,觀察理解 SPL 代碼。

| A | B | C | |

|---|---|---|---|

| 1 | =filename=”C:/DWServer/data/orders.ctx” | ||

| 2 | =sql=replace(sql,”from ORDERS.ctx”,”from “+filename) | ||

| 3 | =connect() | =A3.cursor@x(A2) | return B3 |

A1:定義集算器集文件的絕對路徑。

A2:將文件名替換為絕對路徑。

A3-C3:連接文件系統。執行 SQL 得到游標并返回。

服務器方式也可以和“應用結構一”中一樣配置主目錄,A2 就不用寫絕對路徑了。路徑寫在這里的 SPL 中,好處是同一個服務器可以給多套數據表(文件)提供服務。如果很多文件都在主目錄下,會不方便管理。

6、重啟 tomcat,在瀏覽器中訪問 http://localhost:8080/DW/jdbc.jsp,查看結果。

在并發量不斷增大,或者數據量不斷增加的情況下,節點服務器可以進行橫向擴展,應對大并發或大數據量計算的壓力。

1、在另一臺 window 的機器上再部署一套集算器節點,部署方法和解決方法二略有不同,需要配置一下數據分區。兩臺服務器的 IP 地址是 168.0.122 和 192.168.0.176。方法二中的 c:\\DWServer 目錄也要復制到另一臺服務器上。

圖中數據分區名稱配置為 0,路徑是 c:/DWServer/data。注意,兩個服務器都要配置。

2、改寫 168.0.122 上的 c:/DWServer/dfx/etlUpdate2.dfx,另存為 etlUpdate3.dfx。

| A | B | C | |

|---|---|---|---|

| 1 | =connect(“orcl”) | ||

| 2 | =A1.cursor@d(“select ORDERDATE,CUSTOMERID,EMPLOYEEID,ORDERID,AMOUNT from ORDERS where ORDERDATE=? order by ORDERDATE,CUSTOMERID,EMPLOYEEID,ORDERID”,etlDate) | ||

| 3 | =file(“C:/ DWServer/data/orders.ctx”) | ||

| 4 | =A3.create() | =A4.append(A2) | =A3.rollback() |

| 5 | >A1.close() | ||

| 6 | =sync([“192.168.0.176:8281″]:”192.168.0.122:8281”;0) |

A6 單元格是將更新之后的 orders.ctx 同步到 192.168.0.176 的 0 分區,也就是 C:/ DWServer/data 目錄。[“192.168.0.176:8281”] 是指需要同步的節點機列表,如果有更多的節點機需要同步,可以寫作:[“IP1:PORT1″,”IP2:PORT2″,”IP3:PORT3”]。

因為這里有同步的代碼,所以只需要在 192.168.0.122 上執行定時任務 etlUpdate3.dfx 就可以了。

3、打開應用服務器中的 C:\tomcat6\webapps\DW\WEB-INF\dfx\DW.dfx,修改如下:

| A | B | |

|---|---|---|

| 1 | =callx(“DWServer.dfx”,[sql];[“192.168.0.122:8281″,”192.168.0.176:8281”]) | |

| 2 | return A1.ifn() |

A1:調用節點機上的 DWServer.dfx。參數是 [sql],中括號表示序列,此時是只有一個成員的序列。因為節點機是集群,所以有兩個 IP 地址。在多并發時 callx 會隨機訪問兩個節點。

4、重啟 tomcat,在瀏覽器中訪問 http://localhost:8080/DW/jdbc.jsp,查看結果。

集算器是專業的數據計算中間件(DCM),具備獨立計算的能力,可以脫離數據庫、數據倉庫為多維分析系統前端提供數據源服務。

集算器采用列存數據,具備專業數據倉庫的查詢性能,千萬級別的數據量,可以達到秒級的明細查詢速度。普通數據庫一般都是行存,無法達到多維分析的性能要求。同時,和專業數據倉庫不同,集算器價格都較低,建設、擴展和維護成本都比較小。

集算器是開放的,對多維分析系統前端提供標準的 JDBC 服務。可以形成平臺式的后臺數據源,為多個不同廠家的前端同時提供數據服務。

先進的數據存儲方式,是數據計算中間件(DCM)成功實施的重要保障。

集算器組表采用列存方式存儲數據,對于字段特別多的寬表查詢,性能提升特別明顯。組表采用的列存機制和常規列存是不同的。常規列存(比如 parquet 格式),只能分塊之后,再在塊內列存,在做并行計算的時候是受限的。組表的可并行壓縮列存機制,采用倍增分段技術,允許任意分段的并行計算,可以利用多 CPU 核的計算能力把硬盤的 IO 發揮到極致。

組表生成的時候,要指定維字段,數據本身是按照維字段有序存放的,常用的條件過濾計算不依賴索引也能保證高性能。文件采用壓縮存儲,減小在硬盤上占用的空間,讀取更快。由于采用了合適的壓縮比,解壓縮占用的 CPU 時間可以忽略不計。

組表也可以采取行存和全內存存儲數據,支持內存數據庫方式運行。

敏捷的集群能力可以保證數據計算中間件(DCM)的高性能和高可用性。

集算器節點服務器是獨立進程,可以接受集算器 JDBC 的計算請求并返回結果。對于并發訪問的情況,可以發給多個服務器同時計算,提高并發容量。對于單個大計算任務的情況,可以分成多個小任務,發給多個服務器同時計算,起到大數據并行計算的作用。

集算器集群計算方案,具備敏捷的橫向擴展能力,并發量或者數據量大時可以通過快速增加節點來解決。集算器集群也具備容錯能力,即有個別節點失效時還能確保整個集群能工作,計算任務能繼續執行完畢,起到多機熱備和保證高可用性的作用。

作為數據計算中間件(DCM),集算器提供的后臺數據源可以支持各種前端應用,不僅僅限于前端是多維分析的情況。例如:大屏展示、管理駕駛艙、實時報表、大數據量清單報表、報表批量訂閱等等。

集算器形成的后臺數據源也可以和數據庫、數據倉庫配合使用。集算器實現的數據計算網關和路由,可以在集算器緩存數據和數據倉庫之間智能切換,解決數據倉庫無法滿足性能要求的問題。例如:冷熱數據分開計算的場景。具體做法參見《集算器實現計算路由優化 BI 后臺性能》。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。