您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章主要介紹scrapy怎么在python分布式爬蟲中構建?,文中介紹的非常詳細,具有一定的參考價值,感興趣的小伙伴們一定要看完!

Scrapy

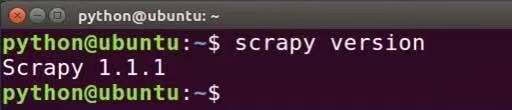

在Ubuntu安裝Scrapy的步驟為:打開終端 >> 在終端輸入命令:pip install scrapy >> 在終端輸入命令:scrapy version >> 成功輸出 Scrapy版本號則證明成功安裝。

各模塊作用

1. items

爬蟲抓取數據的工作實際上是從非結構化數據(網頁)中提取出結構化數據。雖然Scrapy框架爬蟲可以將提取到的數據以Python字典 的形式返回,但是由于Python字典缺少結構,所以很容易發生返回數據不一致亦或者名稱拼寫的錯誤,若是Scrapy爬蟲項目中包含復 數以上的爬蟲則發生錯誤的機率將更大。因此,Scrapy框架提供了一個items模塊來定義公共的輸出格式,其中的Item對象是一個用于 收集Scrapy爬取的數據的簡單容器。

2. Downloader Middleware

Downloader Middleware是一個Scrapy能全局處理Response和Request的、微型的系統。Downloader Middleware中定義的Downloader Middleware設有優先級順序,優先級數字越低,則優先級越高,越先執行。在本次分布式爬蟲中,我們定義了兩個Downloader Middleware,一個用于隨機選擇爬蟲程序執行時的User-Agent,一個用于隨機選擇爬蟲程序執行時的IP地址。

3. settings

settings模塊用于用戶自定義Scrapy框架中Pipeline、Middleware、Spider等所有組件的所有動作,且可自定義變量或者日志動作。

以上是“scrapy怎么在python分布式爬蟲中構建?”這篇文章的所有內容,感謝各位的閱讀!希望分享的內容對大家有幫助,更多相關知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。