您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

環境準備:4臺機器

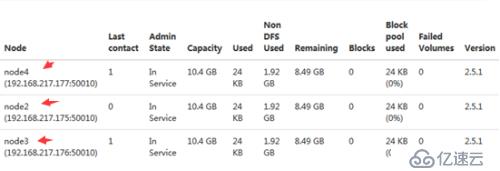

192.168.217.174 node1 -----namenode

192.168.217.175 node2 -----secondary namenode

192.168.217.176 node3 -----datanode

192.168.217.177 node4 -----datanode

1. 4臺機器免密碼登錄

1.1-先在node1機器上做免密碼

在每天機器vim /etc/hosts中互相添加對方的ip和機器名

192.168.217.174 node1

192.168.217.175 node2

192.168.217.176 node3

192.168.217.177 node4

#ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa 1. 注:生成密鑰

#cat ~/.ssh/id_dsa.pub >>~/.ssh/authorized_keys 2.注:密鑰寫入認證機制

1.2-其他3臺機器做免密碼

把在node1機器生成的公鑰拷貝到其他3臺機器,最后在放入每天機器的認證機制

#scp ./id_dsa.pub root@node(2,3,4):/opt/ #在node1上操作

#ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa #3臺機器都執行這條命令

#cat/opt/id_dsa.pub >> ~/.ssh/authorized_keys #3臺機器都執行這條命令

拷貝遇到問題:

bash: scp:command not found #yum install openssh-clients 4臺都裝

2.開始安裝

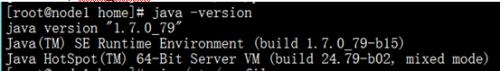

2.1-安裝JDK:------------4臺都安裝

#上傳jdk-7u79-linux-x64.rpm到/home目錄

#rpm –ivh jdk-7u79-linux-x64.rpm

#cd /home/hadoop-2.5.1

# vim~/.bash_profile 添加環境變量

export PATH

export JAVA_HOME=/usr/java/jdk1.7.0_79

exportPATH=$PATH:$JAVA_HOME/bin

exportHADOOP_HOME=/home/hadoop-2.5.1

exportPATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

# source ~/.bash_profile

2.2-安裝hadoop

#上傳hadoop-2.5.1_x64.tar.gz到/home目錄 【在node1操作】

#tar zxvfhadoop-2.5.1_x64.tar.gz

#vim /home/hadoop-2.5.1/etc/hadoop/hadoop-env.sh #namenode主機名

exportJAVA_HOME=/usr/java/jdk1.7.0_79/ (添加)

#vim /home/hadoop-2.5.1/etc/hadoop/core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://node1:9000</value> # namenode數據上傳的主機及端口

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop-2.5</value> # 保存的路徑

</property>

</configuration>

#vim /home/hadoop-2.5.1/etc/hadoop/hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>node2:50090</value> #secondary namenode

</property>

<property>

<name>dfs.namenode.secondary.https-address</name>

<value>node2:50091</value>

</property>

</configuration>

#vim /home/hadoop-2.5.1/etc/hadoop/slaves # 配置datanode主機名

node2

node3

node4

#vim masters # 創建配置secondary namenode主機名

node2

#rm -rf hadoop-2.5.1/share/doc/ 刪除這個目錄方便拷貝給其他機器

2.3-拷貝給其他機器

在/home目錄下

#scp -r hadoop-2.5.1 root@node(234):/home/

在/home/hadoop-2.5.1

# scp~/.bash_profile root@node(234):/root/

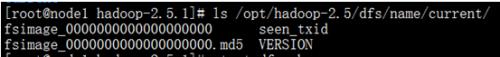

啟動之前先格式化hdfs文件系統

# hdfs namenode-format 只能在指定的namenode(node1)機器上用

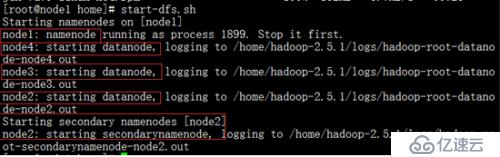

#start-dfs.sh 在任何目錄下都可以啟動

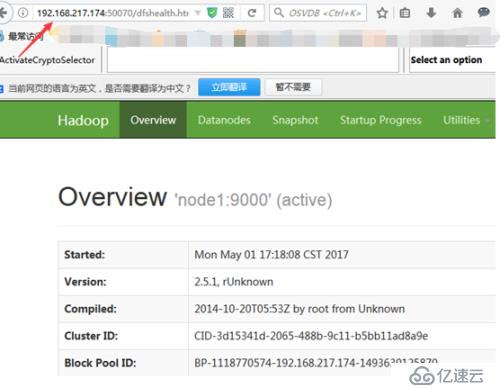

瀏覽器訪問:192.168.217.174:50070

(如果不能打開,就關閉防火墻# serviceiptables stop)

到此,hadoop集群安裝完畢

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。