您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章將為大家詳細講解有關OpenCV相機標定的示例分析,小編覺得挺實用的,因此分享給大家做個參考,希望大家閱讀完這篇文章后可以有所收獲。

相機標定:簡單的說,就是獲得相機參數的過程。參數如:相機內參數矩陣,投影矩陣,旋轉矩陣和平移矩陣等

什么叫相機參數?

簡單的說,將現實世界中的人、物,拍成一張圖像(二維)。人或物在世界中的三維坐標,和圖像上對應的二維坐標間的關系。表達兩種不同維度坐標間的關系用啥表示?用相機參數。

相機的成像原理

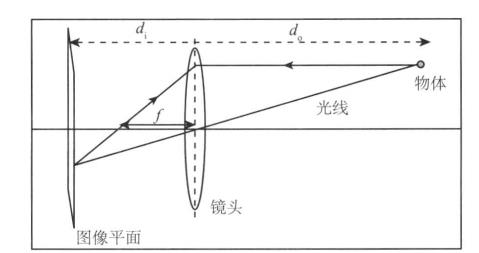

先來看一下,相機的成像原理:

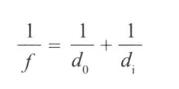

如圖所示,這是一個相機模型。將物體簡化看成一個點。來自物體的光,通過鏡頭,擊中圖像平面(圖像傳感器),以此成像。d0是物體到鏡頭的距離,di時鏡頭到圖像平面的距離,f是鏡頭的焦距。三者滿足以下關系。

現在,簡化上面的相機模型。

將相機孔徑看成無窮小,只考慮中心位置的射線,這樣就忽視了透鏡的影響。然后由于d0遠遠大于di,將圖像平面放在焦距處,這樣物體在圖像平面上成像為倒立的影像(沒有透鏡的影響,只考慮從中心的孔徑進入的光線)。這個簡化的模型就是針孔攝像機模型。然后,我們在鏡頭前,將圖像平面放在焦距距離的位置,就可以簡單獲得一個筆直的圖像(不倒立)。當然,這只是理論上的,你不可能將圖像傳感器從相機里拿出來,放在鏡頭前面。實際應用中,針孔攝像機應該是將成像后的圖像倒過來,以獲得正立的圖像。

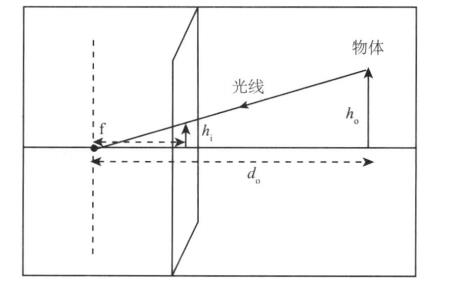

到此,我們獲得了一個簡化的模型,如下圖:

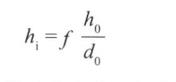

h0是物體的高,hi是圖像上物體的高,f是焦距(距離),d0是圖像到鏡頭的距離。四者滿足如下關系:

(1)

(1)

物體在圖像中的高度hi,和d0成反比。也就是說,離鏡頭越遠,物體在圖像中越小,離得越近越大(好吧,這句話是廢話)。

但通過這個式子,我們便能夠預測三維中的物體,在圖像(二維)中的位置。那么怎么預測?

相機標定

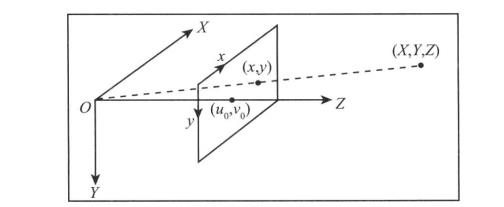

如下圖所示,根據上面簡化的模型,考慮三維世界中的一個點,和其在圖像(二維)中的坐標關系。

(X,Y,Z)為點的三維坐標,(x,y)為其通過相機成像后在圖像(二維)上的坐標。u0和v0是相機的中心點(主點),該點位于圖像平面中心(理論上是這樣。但實際的相機會有幾個像素的偏差)

現在只考慮y方向上,由于需要將三維世界中的坐標,轉換為圖像上的像素(圖像上的坐標,實際上是像素的位置),需要求y方向上焦距等于多少個像素(用像素值表示焦距),Py表示像素的高,焦距f(米或毫米)。垂直像素表示的焦距為

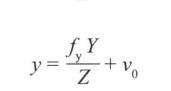

根據式子(1),只考慮y方向。我們三維世界中得點,在圖像(二維)中y的坐標。

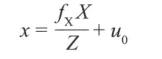

同理,得到x的坐標。

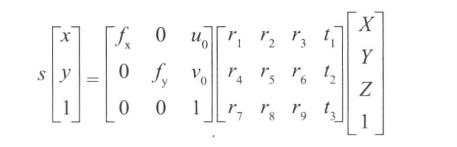

現在,將上圖中的坐標系的原點O,移動到圖像的左上角。由于(x,y)是關于(u0,v0)的偏移,上面表示圖像(二維)中點的坐標的式子不變。將式子以矩陣的形式重寫,得。

其中,等式左邊的第一個矩陣,叫做“相機內參數矩陣”,第二個矩陣叫(投影矩陣)。

更為一般的情況,開始時的參考坐標系不位于主點(中心點),需要額外兩個參數“旋轉向量”和“平移向量”來表示這個式子,這兩個參數在不同視角中是不一樣的。整合后,上述式子重寫為。

校正畸變

通過相機標定,獲得了相機參數后,可以計算兩個映射函數(x坐標和y坐標),它們分別給出了沒有畸變的圖像坐標。將畸變的圖像重新映射成為沒有畸變的圖像。

代碼:

做相機標定時,一般用標定板(棋盤)拍攝一組圖像,利用這些圖像提取角點,通過角點在圖像中得坐標和三維世界中的坐標(通常自定義3維坐標),計算相機參數。

std::vector<cv::Point2f>imageConers; //提取標定圖像角點,保存角點坐標(二維) cv::findChessboardCorners(image, boardSize, //角點數目如(6,4)六行,四列 imageConers);

函數calibrateCamera完成相機標定工作。

cv::calibrateCamera(objectPoints,//三維坐標 imagePoints, //二維坐標 imageSize,//圖像大小 camerMatirx,//相機內參數矩陣 disCoeffs,//投影矩陣 rvecs, //旋轉 tvecs,//平移 flag //標記opencv提供幾種參數,可以參看在線的opencv document );

計算畸變參數,去畸變

//計算畸變參數 cv::initUndistortRectifyMap(camerMatirx, disCoeffs, cv::Mat(), cv::Mat(), image.size(), CV_32FC1, map1, //x映射函數 map2 //y映射函數 ); //應用映射函數 cv::remap(image, //畸變圖像 undistorted, //去畸變圖像 map1, map2, cv::INTER_LINEAR);

現在整合代碼。

示例:

標頭.h

#include<opencv2\core\core.hpp>

#include<opencv2\highgui\highgui.hpp>

#include<opencv2\imgproc\imgproc.hpp>

#include<opencv2\calib3d\calib3d.hpp>

#include <opencv2/features2d/features2d.hpp>

#include<string>

#include<vector>

class CameraCalibrator

{

private:

//世界坐標

std::vector < std::vector<cv::Point3f >> objectPoints;

//圖像坐標

std::vector <std::vector<cv::Point2f>> imagePoints;

//輸出矩陣

cv::Mat camerMatirx;

cv::Mat disCoeffs;

//標記

int flag;

//去畸變參數

cv::Mat map1, map2;

//是否去畸變

bool mustInitUndistort;

///保存點數據

void addPoints(const std::vector<cv::Point2f>&imageConers, const std::vector<cv::Point3f>&objectConers)

{

imagePoints.push_back(imageConers);

objectPoints.push_back(objectConers);

}

public:

CameraCalibrator() :flag(0), mustInitUndistort(true){}

//打開棋盤圖片,提取角點

int addChessboardPoints(const std::vector<std::string>&filelist,cv::Size &boardSize)

{

std::vector<cv::Point2f>imageConers;

std::vector<cv::Point3f>objectConers;

//輸入角點的世界坐標

for (int i = 0; i < boardSize.height; i++)

{

for (int j = 0; j < boardSize.width; j++)

{

objectConers.push_back(cv::Point3f(i, j, 0.0f));

}

}

//計算角點在圖像中的坐標

cv::Mat image;

int success = 0;

for (int i = 0; i < filelist.size(); i++)

{

image = cv::imread(filelist[i],0);

//找到角點坐標

bool found = cv::findChessboardCorners(image, boardSize, imageConers);

cv::cornerSubPix(image,

imageConers,

cv::Size(5, 5),

cv::Size(-1, -1),

cv::TermCriteria(cv::TermCriteria::MAX_ITER + cv::TermCriteria::EPS,

30, 0.1));

if (imageConers.size() == boardSize.area())

{

addPoints(imageConers, objectConers);

success++;

}

//畫出角點

cv::drawChessboardCorners(image, boardSize, imageConers, found);

cv::imshow("Corners on Chessboard", image);

cv::waitKey(100);

}

return success;

}

//相機標定

double calibrate(cv::Size&imageSize)

{

mustInitUndistort = true;

std::vector<cv::Mat>rvecs, tvecs;

//相機標定

return cv::calibrateCamera(objectPoints, imagePoints, imageSize,

camerMatirx, disCoeffs, rvecs, tvecs, flag);

}

///去畸變

cv::Mat remap(const cv::Mat &image)

{

cv::Mat undistorted;

if (mustInitUndistort)

{

//計算畸變參數

cv::initUndistortRectifyMap(camerMatirx, disCoeffs,

cv::Mat(), cv::Mat(), image.size(), CV_32FC1, map1, map2);

mustInitUndistort = false;

}

//應用映射函數

cv::remap(image, undistorted, map1, map2, cv::INTER_LINEAR);

return undistorted;

}

//常成員函數,獲得相機內參數矩陣、投影矩陣數據

cv::Mat getCameraMatrix() const { return camerMatirx; }

cv::Mat getDistCoeffs() const { return disCoeffs; }

};源.cpp

#include"標頭.h"

#include<iomanip>

#include<iostream>

int main()

{

CameraCalibrator Cc;

cv::Mat image;

std::vector<std::string> filelist;

cv::namedWindow("Image");

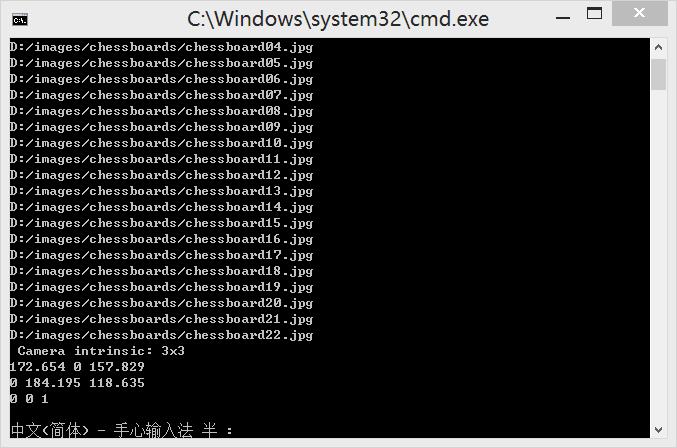

for (int i = 1; i <= 22; i++)

{

///讀取圖片

std::stringstream s;

s << "D:/images/chessboards/chessboard" << std::setw(2) << std::setfill('0') << i << ".jpg";

std::cout << s.str() << std::endl;

filelist.push_back(s.str());

image = cv::imread(s.str(),0);

cv::imshow("Image", image);

cv::waitKey(100);

}

//相機標定

cv::Size boardSize(6, 4);

Cc.addChessboardPoints(filelist, boardSize);

Cc.calibrate(image.size());

//去畸變

image = cv::imread(filelist[1]);

cv::Mat uImage=Cc.remap(image);

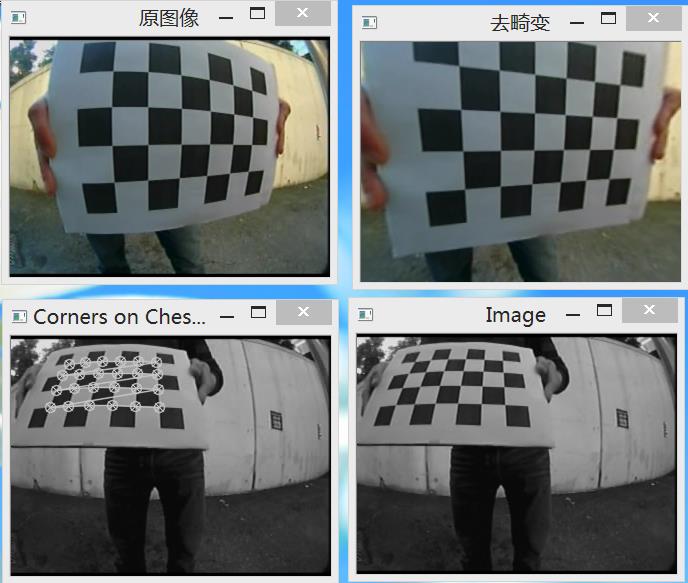

cv::imshow("原圖像", image);

cv::imshow("去畸變", uImage);

//顯示相機內參數矩陣

cv::Mat cameraMatrix = Cc.getCameraMatrix();

std::cout << " Camera intrinsic: " << cameraMatrix.rows << "x" << cameraMatrix.cols << std::endl;

std::cout << cameraMatrix.at<double>(0, 0) << " " << cameraMatrix.at<double>(0, 1) << " " << cameraMatrix.at<double>(0, 2) << std::endl;

std::cout << cameraMatrix.at<double>(1, 0) << " " << cameraMatrix.at<double>(1, 1) << " " << cameraMatrix.at<double>(1, 2) << std::endl;

std::cout << cameraMatrix.at<double>(2, 0) << " " << cameraMatrix.at<double>(2, 1) << " " << cameraMatrix.at<double>(2, 2) << std::endl;

cv::waitKey(0);

}實驗結果:

看以看到,相機內參數矩陣為

172.654 、0、157.829

0、184.195、118.635

0 、0 、1

關于“OpenCV相機標定的示例分析”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,使各位可以學到更多知識,如果覺得文章不錯,請把它分享出去讓更多的人看到。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。