您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

1.簡單介紹

在機器學習和認知科學領域,人工神經網絡(artificial neural network,縮寫ANN),簡稱神經網絡(neural network,縮寫NN)或類神經網絡,是一種模仿生物神經網絡(動物的中樞神經系統,特別是大腦)的結構和功能的數學模型或計算模型,用于對函數進行估計或近似。神經網絡由大量的人工神經元聯結進行計算。大多數情況下人工神經網絡能在外界信息的基礎上改變內部結構,是一種自適應系統。現代神經網絡是一種非線性統計性數據建模工具。典型的神經網絡具有以下三個部分:

結構 (Architecture) 結構指定了網絡中的變量和它們的拓撲關系。例如,神經網絡中的變量可以是神經元連接的權重(weights)和神經元的激勵值(activities of the neurons)。

激勵函數(Activity Rule) 大部分神經網絡模型具有一個短時間尺度的動力學規則,來定義神經元如何根據其他神經元的活動來改變自己的激勵值。一般激勵函數依賴于網絡中的權重(即該網絡的參數)。

學習規則(Learning Rule)學習規則指定了網絡中的權重如何隨著時間推進而調整。這一般被看做是一種長時間尺度的動力學規則。一般情況下,學習規則依賴于神經元的激勵值。它也可能依賴于監督者提供的目標值和當前權重的值。

2.初識神經網絡

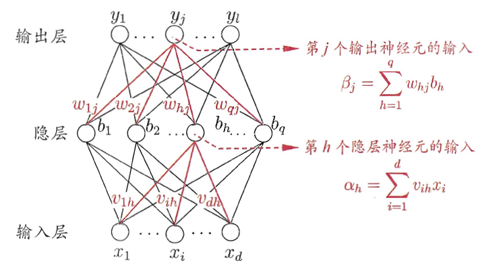

如上文所說,神經網絡主要包括三個部分:結構、激勵函數、學習規則。圖1是一個三層的神經網絡,輸入層有d個節點,隱層有q個節點,輸出層有l個節點。除了輸入層,每一層的節點都包含一個非線性變換。

圖1

那么為什么要進行非線性變換呢?

(1)如果只進行線性變換,那么即使是多層的神經網絡,依然只有一層的效果。類似于0.6*(0.2x1+0.3x2)=0.12x1+0.18x2。

(2)進行非線性變化,可以使得神經網絡可以擬合任意一個函數,圖2是一個四層網絡的圖。

圖2

下面使用數學公式描述每一個神經元工作的方式

(1)輸出x

(2)計算z=w*x

(3)輸出new_x = f(z),這里的f是一個函數,可以是sigmoid、tanh、relu等,f就是上文所說到的激勵函數。

3.反向傳播(bp)算法

有了上面的網絡結構和激勵函數之后,這個網絡是如何學習參數(學習規則)的呢?

首先我們先定義下本文使用的激活函數、目標函數

(1)激活函數(sigmoid):

def sigmoid(z): return 1.0/(1.0+np.exp(-z))

sigmoid函數有一個十分重要的性質: ,即計算導數十分方便。

,即計算導數十分方便。

def sigmoid_prime(z): return sigmoid(z)*(1-sigmoid(z))

下面給出一個簡單的證明:

(2)目標函數(差的平方和) ,公式中的1/2是為了計算導數方便。

,公式中的1/2是為了計算導數方便。

然后,這個網絡是如何運作的

(1)數據從輸入層到輸出層,經過各種非線性變換的過程即前向傳播。

def feedforward(self, a):

for b, w in zip(self.biases, self.weights):

a = sigmoid(np.dot(w, a)+b)

return a

其中,初始的權重(w)和偏置(b)是隨機賦值的

biases = [np.random.randn(y, 1) for y in sizes[1:]] weights = [np.random.randn(y, x) for x, y in zip(sizes[:-1], sizes[1:])]

(2)參數更新,即反向傳播

在寫代碼之前,先進行推導,即利用梯度下降更新參數,以上面的網絡結構(圖1)為例

(1)輸出層與隱層之間的參數更新

(2)隱層與輸入層之間的參數更新

有兩點需要強調下:

(2)中的結果比(1)中的結果多了一個求和公式,這是因為計算隱層與輸入層之間的參數時,輸出層與隱層的每一個節點都有影響。

(2)中參數更新的結果可以復用(1)中的參數更新結果,從某種程度上,與反向傳播這個算法名稱不謀而合,不得不驚嘆。

def backprop(self, x, y):

"""返回一個元組(nabla_b, nabla_w)代表目標函數的梯度."""

nabla_b = [np.zeros(b.shape) for b in self.biases]

nabla_w = [np.zeros(w.shape) for w in self.weights]

# feedforward

activation = x

activations = [x] # list to store all the activations, layer by layer

zs = [] # list to store all the z vectors, layer by layer

for b, w in zip(self.biases, self.weights):

z = np.dot(w, activation)+b

zs.append(z)

activation = sigmoid(z)

activations.append(activation)

# backward pass

delta = self.cost_derivative(activations[-1], y) * \

sigmoid_prime(zs[-1])

nabla_b[-1] = delta

nabla_w[-1] = np.dot(delta, activations[-2].transpose())

"""l = 1 表示最后一層神經元,l = 2 是倒數第二層神經元, 依此類推."""

for l in xrange(2, self.num_layers):

z = zs[-l]

sp = sigmoid_prime(z)

delta = np.dot(self.weights[-l+1].transpose(), delta) * sp

nabla_b[-l] = delta

nabla_w[-l] = np.dot(delta, activations[-l-1].transpose())

return (nabla_b, nabla_w)

4.完整代碼實現

# -*- coding: utf-8 -*-

import random

import numpy as np

class Network(object):

def __init__(self, sizes):

"""參數sizes表示每一層神經元的個數,如[2,3,1],表示第一層有2個神經元,第二層有3個神經元,第三層有1個神經元."""

self.num_layers = len(sizes)

self.sizes = sizes

self.biases = [np.random.randn(y, 1) for y in sizes[1:]]

self.weights = [np.random.randn(y, x)

for x, y in zip(sizes[:-1], sizes[1:])]

def feedforward(self, a):

"""前向傳播"""

for b, w in zip(self.biases, self.weights):

a = sigmoid(np.dot(w, a)+b)

return a

def SGD(self, training_data, epochs, mini_batch_size, eta,

test_data=None):

"""隨機梯度下降"""

if test_data:

n_test = len(test_data)

n = len(training_data)

for j in xrange(epochs):

random.shuffle(training_data)

mini_batches = [

training_data[k:k+mini_batch_size]

for k in xrange(0, n, mini_batch_size)]

for mini_batch in mini_batches:

self.update_mini_batch(mini_batch, eta)

if test_data:

print "Epoch {0}: {1} / {2}".format(j, self.evaluate(test_data), n_test)

else:

print "Epoch {0} complete".format(j)

def update_mini_batch(self, mini_batch, eta):

"""使用后向傳播算法進行參數更新.mini_batch是一個元組(x, y)的列表、eta是學習速率"""

nabla_b = [np.zeros(b.shape) for b in self.biases]

nabla_w = [np.zeros(w.shape) for w in self.weights]

for x, y in mini_batch:

delta_nabla_b, delta_nabla_w = self.backprop(x, y)

nabla_b = [nb+dnb for nb, dnb in zip(nabla_b, delta_nabla_b)]

nabla_w = [nw+dnw for nw, dnw in zip(nabla_w, delta_nabla_w)]

self.weights = [w-(eta/len(mini_batch))*nw

for w, nw in zip(self.weights, nabla_w)]

self.biases = [b-(eta/len(mini_batch))*nb

for b, nb in zip(self.biases, nabla_b)]

def backprop(self, x, y):

"""返回一個元組(nabla_b, nabla_w)代表目標函數的梯度."""

nabla_b = [np.zeros(b.shape) for b in self.biases]

nabla_w = [np.zeros(w.shape) for w in self.weights]

# 前向傳播

activation = x

activations = [x] # list to store all the activations, layer by layer

zs = [] # list to store all the z vectors, layer by layer

for b, w in zip(self.biases, self.weights):

z = np.dot(w, activation)+b

zs.append(z)

activation = sigmoid(z)

activations.append(activation)

# backward pass

delta = self.cost_derivative(activations[-1], y) * sigmoid_prime(zs[-1])

nabla_b[-1] = delta

nabla_w[-1] = np.dot(delta, activations[-2].transpose())

"""l = 1 表示最后一層神經元,l = 2 是倒數第二層神經元, 依此類推."""

for l in xrange(2, self.num_layers):

z = zs[-l]

sp = sigmoid_prime(z)

delta = np.dot(self.weights[-l+1].transpose(), delta) * sp

nabla_b[-l] = delta

nabla_w[-l] = np.dot(delta, activations[-l-1].transpose())

return (nabla_b, nabla_w)

def evaluate(self, test_data):

"""返回分類正確的個數"""

test_results = [(np.argmax(self.feedforward(x)), y) for (x, y) in test_data]

return sum(int(x == y) for (x, y) in test_results)

def cost_derivative(self, output_activations, y):

return (output_activations-y)

def sigmoid(z):

return 1.0/(1.0+np.exp(-z))

def sigmoid_prime(z):

"""sigmoid函數的導數"""

return sigmoid(z)*(1-sigmoid(z))

5.簡單應用

# -*- coding: utf-8 -*-

from network import *

def vectorized_result(j,nclass):

"""離散數據進行one-hot"""

e = np.zeros((nclass, 1))

e[j] = 1.0

return e

def get_format_data(X,y,isTest):

ndim = X.shape[1]

nclass = len(np.unique(y))

inputs = [np.reshape(x, (ndim, 1)) for x in X]

if not isTest:

results = [vectorized_result(y,nclass) for y in y]

else:

results = y

data = zip(inputs, results)

return data

#隨機生成數據

from sklearn.datasets import *

np.random.seed(0)

X, y = make_moons(200, noise=0.20)

ndim = X.shape[1]

nclass = len(np.unique(y))

#劃分訓練、測試集

from sklearn.cross_validation import train_test_split

train_x,test_x,train_y,test_y = train_test_split(X,y,test_size=0.2,random_state=0)

training_data = get_format_data(train_x,train_y,False)

test_data = get_format_data(test_x,test_y,True)

net = Network(sizes=[ndim,10,nclass])

net.SGD(training_data=training_data,epochs=5,mini_batch_size=10,eta=0.1,test_data=test_data)

參考文獻

(1)周志華《機器學習》

(2)https://github.com/mnielsen/neural-networks-and-deep-learning

(3)https://zhuanlan.zhihu.com/p/21525237

以上就是本文的全部內容,希望對大家的學習有所幫助,也希望大家多多支持億速云。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。