溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

本文小編為大家詳細介紹“pytorch如何使用nn.Moudle實現邏輯回歸”,內容詳細,步驟清晰,細節處理妥當,希望這篇“pytorch如何使用nn.Moudle實現邏輯回歸”文章能幫助大家解決疑惑,下面跟著小編的思路慢慢深入,一起來學習新知識吧。

loss下降不明顯

#源代碼 out的數據接收方式 if torch.cuda.is_available(): x_data=Variable(x).cuda() y_data=Variable(y).cuda() else: x_data=Variable(x) y_data=Variable(y) out=logistic_model(x_data) #根據邏輯回歸模型擬合出的y值 loss=criterion(out.squeeze(),y_data) #計算損失函數

#源代碼 out的數據有拼裝數據直接輸入 # if torch.cuda.is_available(): # x_data=Variable(x).cuda() # y_data=Variable(y).cuda() # else: # x_data=Variable(x) # y_data=Variable(y) out=logistic_model(x_data) #根據邏輯回歸模型擬合出的y值 loss=criterion(out.squeeze(),y_data) #計算損失函數 print_loss=loss.data.item() #得出損失函數值

import torch

from torch import nn

from torch.autograd import Variable

import matplotlib.pyplot as plt

import numpy as np

#生成數據

sample_nums = 100

mean_value = 1.7

bias = 1

n_data = torch.ones(sample_nums, 2)

x0 = torch.normal(mean_value * n_data, 1) + bias # 類別0 數據 shape=(100, 2)

y0 = torch.zeros(sample_nums) # 類別0 標簽 shape=(100, 1)

x1 = torch.normal(-mean_value * n_data, 1) + bias # 類別1 數據 shape=(100, 2)

y1 = torch.ones(sample_nums) # 類別1 標簽 shape=(100, 1)

x_data = torch.cat((x0, x1), 0) #按維數0行拼接

y_data = torch.cat((y0, y1), 0)

#畫圖

plt.scatter(x.data.numpy()[:, 0], x.data.numpy()[:, 1], c=y.data.numpy(), s=100, lw=0, cmap='RdYlGn')

plt.show()

# 利用torch.nn實現邏輯回歸

class LogisticRegression(nn.Module):

def __init__(self):

super(LogisticRegression, self).__init__()

self.lr = nn.Linear(2, 1)

self.sm = nn.Sigmoid()

def forward(self, x):

x = self.lr(x)

x = self.sm(x)

return x

logistic_model = LogisticRegression()

# if torch.cuda.is_available():

# logistic_model.cuda()

#loss函數和優化

criterion = nn.BCELoss()

optimizer = torch.optim.SGD(logistic_model.parameters(), lr=0.01, momentum=0.9)

#開始訓練

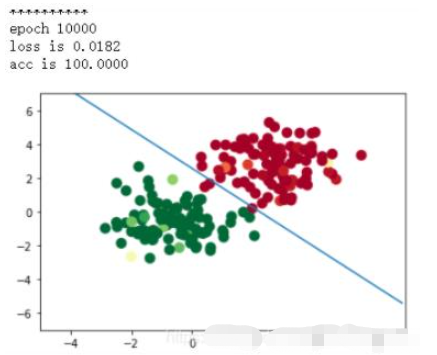

#訓練10000次

for epoch in range(10000):

# if torch.cuda.is_available():

# x_data=Variable(x).cuda()

# y_data=Variable(y).cuda()

# else:

# x_data=Variable(x)

# y_data=Variable(y)

out=logistic_model(x_data) #根據邏輯回歸模型擬合出的y值

loss=criterion(out.squeeze(),y_data) #計算損失函數

print_loss=loss.data.item() #得出損失函數值

#反向傳播

loss.backward()

optimizer.step()

optimizer.zero_grad()

mask=out.ge(0.5).float() #以0.5為閾值進行分類

correct=(mask==y_data).sum().squeeze() #計算正確預測的樣本個數

acc=correct.item()/x_data.size(0) #計算精度

#每隔20輪打印一下當前的誤差和精度

if (epoch+1)%100==0:

print('*'*10)

print('epoch {}'.format(epoch+1)) #誤差

print('loss is {:.4f}'.format(print_loss))

print('acc is {:.4f}'.format(acc)) #精度

w0, w1 = logistic_model.lr.weight[0]

w0 = float(w0.item())

w1 = float(w1.item())

b = float(logistic_model.lr.bias.item())

plot_x = np.arange(-7, 7, 0.1)

plot_y = (-w0 * plot_x - b) / w1

plt.xlim(-5, 7)

plt.ylim(-7, 7)

plt.scatter(x.data.numpy()[:, 0], x.data.numpy()[:, 1], c=logistic_model(x_data)[:,0].cpu().data.numpy(), s=100, lw=0, cmap='RdYlGn')

plt.plot(plot_x, plot_y)

plt.show()

讀到這里,這篇“pytorch如何使用nn.Moudle實現邏輯回歸”文章已經介紹完畢,想要掌握這篇文章的知識點還需要大家自己動手實踐使用過才能領會,如果想了解更多相關內容的文章,歡迎關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。