溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

這篇文章主要介紹“怎么用python爬取貓眼電影的前100部影片”,在日常操作中,相信很多人在怎么用python爬取貓眼電影的前100部影片問題上存在疑惑,小編查閱了各式資料,整理出簡單好用的操作方法,希望對大家解答”怎么用python爬取貓眼電影的前100部影片”的疑惑有所幫助!接下來,請跟著小編一起來學習吧!

import requestsimport refrom bs4 import BeautifulSoupfrom lxml import etreeimport tracebackimport csv#定義一個函數獲取豆瓣電影第一頁def get_one_page(url,code = 'utf-8'):headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/75.0.3770.90 Safari/537.36'}try:r = requests.get(url,headers = headers)if r.status_code == 200:r.encoding = codereturn r.textelse:print("相應失敗")return Noneexcept:traceback.print_exc()def process(raw):right = raw.split("@")return right[0]def area(a):if a[-1] == ")":return a[16:]else:return Nonedef parse_one_page(slst,html):#正則表達式# rank = re.findall('<dd>.*?<i class="board-index.*?>(\d+)</i>',html,re.S)# img = re.findall('data-src="(.*?)".*?</a>',html,re.S)# name = re.findall('<p class="name".*?><a.*?>(.*?)</a>',html,re.S)# star = re.findall('<p class="star">(.*?)</p>',html,re.S)# time = re.findall('<p class="releasetime">(.*?)</p>',html,re.S)# print(time)#正則表達式別忘了加上r,防止轉義,否則會報錯# 把上面的正則表達式合在一起pattern = re.compile(r'<dd>.*?<i class="board-index.*?>(\d+)</i>.*?data-src="(.*?)".*?</a>.*?<p class="name".*?><a.*?>(.*?)</a>.*?<p class="star">(.*?)</p>.*?<p class="releasetime">(.*?)</p>.*?<p class="score"><.*?>(.*?)</i><i class="fraction">(.*?)</i></p>',re.S)items = re.findall(pattern,html)#print(items)for item in items:#yield就相當于return的功能,但也有所不同,yield語句把程序編程迭代器yield {'rank':item[0],'img':process(item[1]),'MovieName':item[2],"star":item[3].strip()[3:],"time":item[4].strip()[5:15],"area":area(item[4].strip()),"score":str(item[5]) + str(item[6])}# return ""def write_to_file(item):with open("貓眼top100.csv",'a',encoding = "utf_8_sig",newline="") as f:#a追加模式 newline區分換行符fieldnames = ['rank','img','MovieName','star','time','area','score']w = csv.DictWriter(f,fieldnames = fieldnames) #字典寫入到csv# w.writeheader()w.writerow(item)return ""def down_img(name,url,num):try:response = requests.get(url)with open('C:/Users/HUAWEI/Desktop/py/爬蟲/douban/'+name+'.jpg','wb') as f:f.write(response.content)print("第%s張圖片下載完畢"%str(num))print("="*20)except Exception as e:print(e.__class__.__name__) #打印錯誤類型名稱def main(i):num = 0url = 'https://maoyan.com/board/4?offset=' + str(i)html = get_one_page(url)#print(html)lst = [] #這個在這里沒啥用,但以后若要單獨存儲某類信息,可是這樣寫,后面再對應加上函數參數iterator = parse_one_page(lst,html)for a in iterator:#print(a)num += 1write_to_file(a)down_img(a['MovieName'],a['img'],num)# if __name__ == '__main__':# for i in range(10):# main(i)#多線程抓取from multiprocessing import Poolif __name__ == '__main__':pool = Pool()pool.map(main,[i * 10 for i in range(10)])

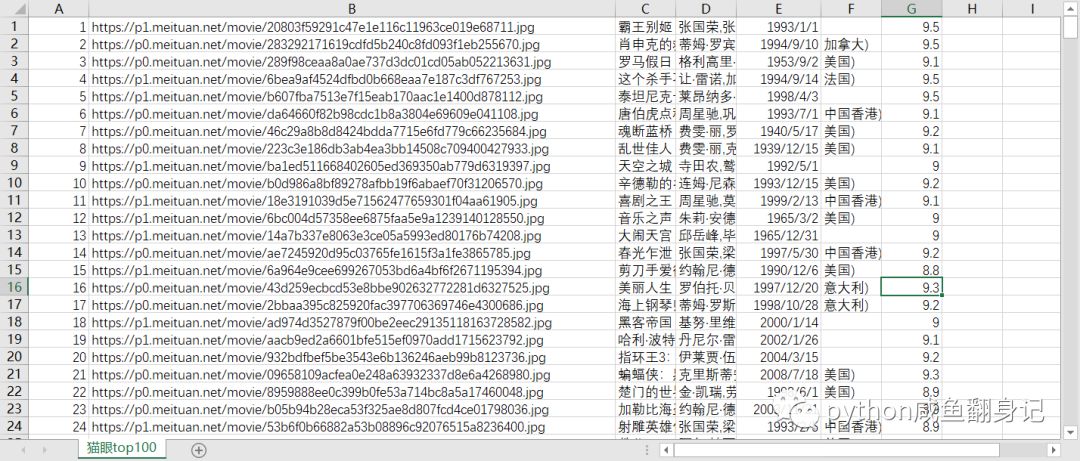

最終運行結果如下:

保存封面圖片

把爬到的信息儲存到csv文件中

到此,關于“怎么用python爬取貓眼電影的前100部影片”的學習就結束了,希望能夠解決大家的疑惑。理論與實踐的搭配能更好的幫助大家學習,快去試試吧!若想繼續學習更多相關知識,請繼續關注億速云網站,小編會繼續努力為大家帶來更多實用的文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。