溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

這篇文章主要介紹Hive外部分區表加載flume打到hdfs上文件讀不到.tmp文件怎么辦,文中介紹的非常詳細,具有一定的參考價值,感興趣的小伙伴們一定要看完!

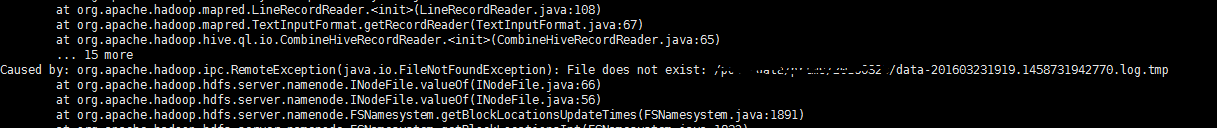

flume打到hdfs上時,按照文件大小生成文件,在達到指定大小之前數據都是以.tmp文件形式保存在hdfs上,hive外部表也會加載這些文件,但是當文件完成后.tmp會消失,這時候hive會報找不到文件的錯誤。解決方法是自己寫hive的pathfilter類,hive加載數據的時候把tmp文件過濾掉不加載即可。

錯誤信息如下:

自定義PathFilter類如下:

/**

*

* @Title: FileFilterExcludeTmpFiles.java

* @Description: hive加載分區表時會加載.tmp的文件,該類型文件在flume滾動數據之后就會消失,此時hive找不到該文件就會報錯

* 該類會將.tmp的文件過濾掉,不加載進hive的分區表中

* @version V0.1.0

* @see

*/

public class FileFilterExcludeTmpFiles implements PathFilter{

private static final Logger logger = LoggerFactory.getLogger(FileFilterExcludeTmpFiles.class);

public boolean accept(Path path) {

// TODO Auto-generated method stub

return !name.startsWith("_") && !name.startsWith(".") && !name.endsWith(".tmp");

}

}

編寫完后,打成jar包上傳服務器,再修改hive-site.xml文件,修改如下:

<property> <name>hive.aux.jars.path</name><value>file:///usr/lib/mylib/FilterTmpPath.jar</value> <description>The location of the plugin jars that contain implementations of user defined functions and serdes.</description> </property> <property> <name>mapred.input.pathFilter.class</name> <value>cn.utils.hive.FileFilterExcludeTmpFiles</value> </property>

以上是“Hive外部分區表加載flume打到hdfs上文件讀不到.tmp文件怎么辦”這篇文章的所有內容,感謝各位的閱讀!希望分享的內容對大家有幫助,更多相關知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。