溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

本篇文章給大家分享的是有關Spark API編程中如何在Spark 1.2版本實現對union、groupByKe的分析,小編覺得挺實用的,因此分享給大家學習,希望大家閱讀完這篇文章后可以有所收獲,話不多說,跟著小編一起來看看吧。

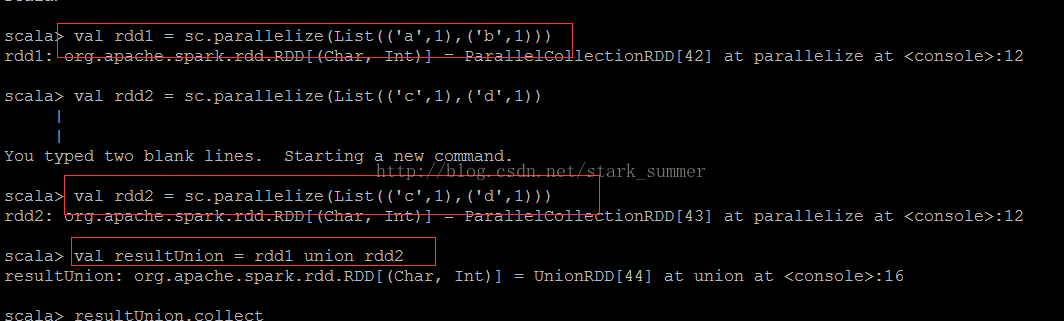

下面看下union的使用:

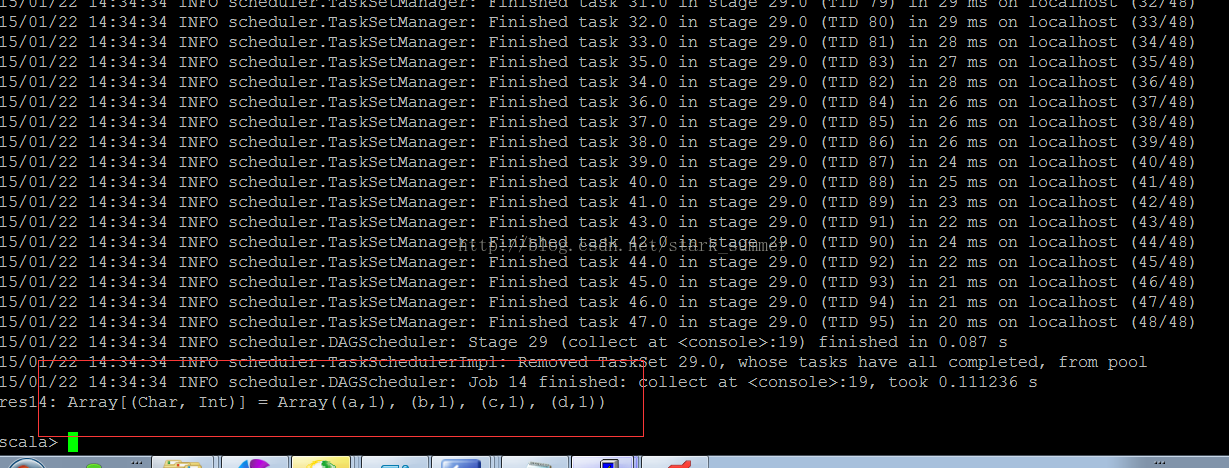

使用collect操作查看一下執行結果:

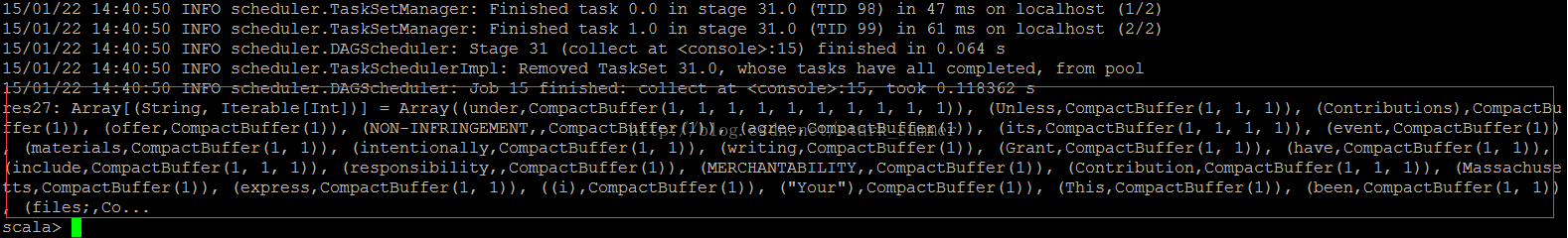

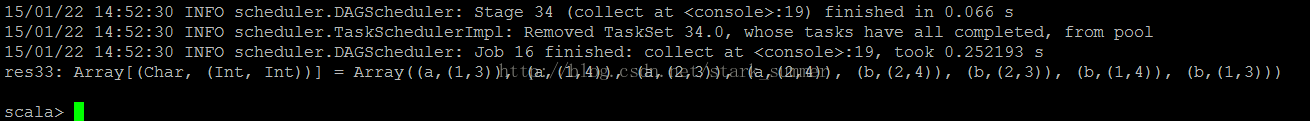

再看下groupByKey的使用:

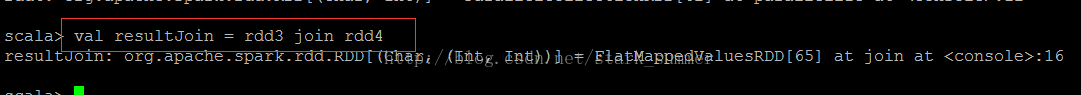

join操作就是一個笛卡爾積操作的過程,如下示例:

使用collect查看執行結果:

可以看出join操作完全就是一個笛卡爾積的操作;

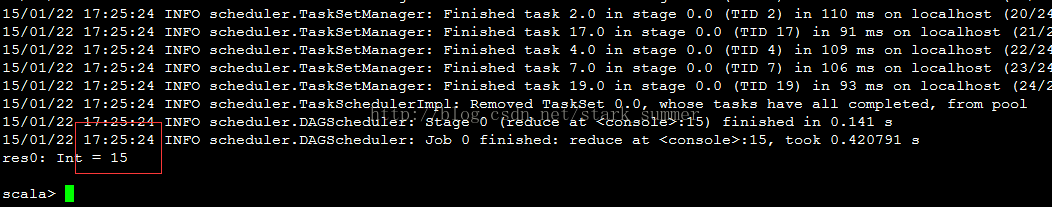

reduce本身在RDD操作中屬于一個action類型的操作,會導致job的提交和執行:

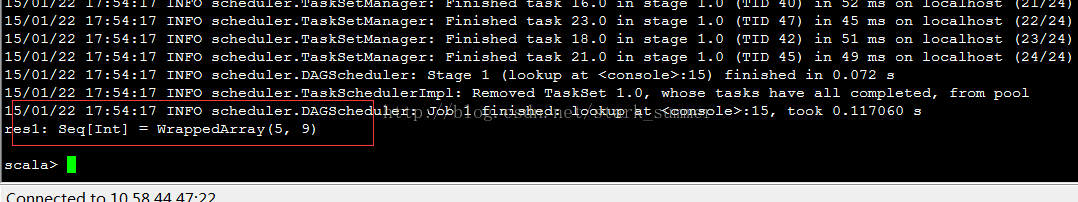

下面我們看下lookup的使用:

以上就是Spark API編程中如何在Spark 1.2版本實現對union、groupByKe的分析,小編相信有部分知識點可能是我們日常工作會見到或用到的。希望你能通過這篇文章學到更多知識。更多詳情敬請關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。