您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“spark內核核心術語如何解析”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

Application:

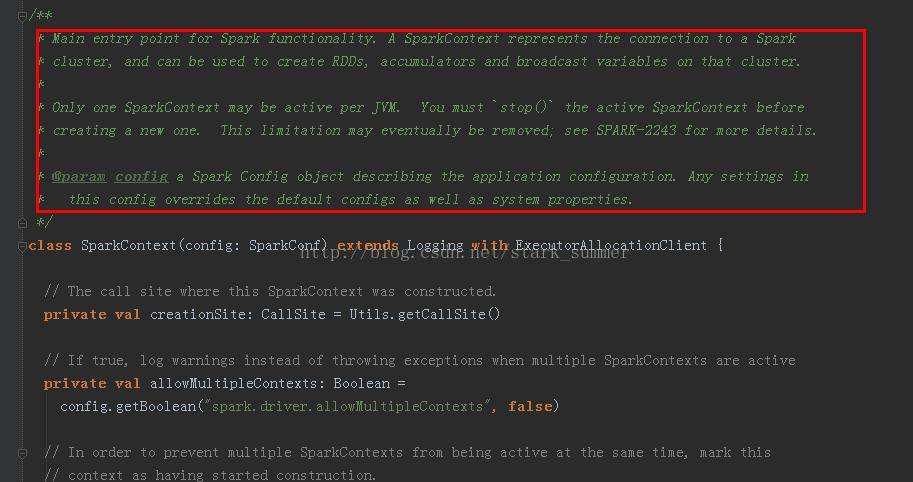

Application是創建了SparkContext實例對象的spark用戶,包含了Driver程序:

Spark-shell是一個應用程序,因為spark-shell在啟動的時候創建了一個SparkContext對象,其名稱為sc:

Job:

和Spark的action相對應,每一個action例如count、saveAsTextFile等都會對應一個job實例,該job實例包含多任務的并行計算。

Driver Program:

運行main函數并且創建SparkContext實例的程序

Cluster Manager:

集群資源的管理外部服務,在spark上現在有standalone、yarn、mesos等三種集群資源管理器,spark自帶的standalone模式能夠滿足大部分的spark計算環境對集群資源管理的需求,基本上只有在集群中運行多套計算框架的時候才考慮yarn和mesos

Worker Node:

集群中可以運行應用代碼的工作節點,相當于Hadoop的slave節點

Executor:

在一個Worker Node上為應用啟動的工作進程,在進程中賦值任務的運行,并且負責將數據存放在內存或磁盤上,必須注意的是,每個應用在一個Worker Node上只會有一個Executor,在Executor內部通過多線程的方式并發處理應用的任務。

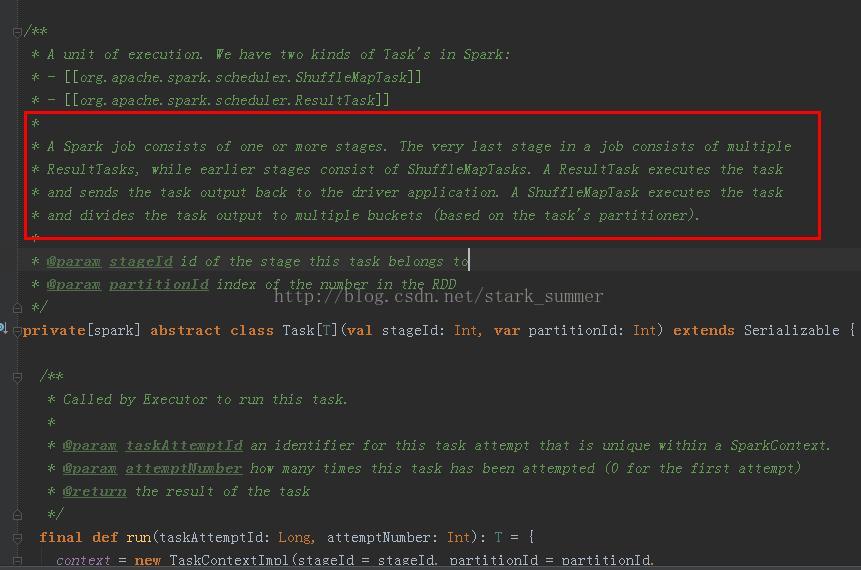

State:

一個job會被拆分成很多任務,每一組任務被稱為state,這個MapReduce的map和reduce任務很像,劃分state的依據在于:state開始一般是由于讀取外部數據或者shuffle數據、一個state的結束一般是由于發生shuffle(例如reduceByKey操作)或者整個job結束時,例如要把數據放到hdfs等存儲系統上

“spark內核核心術語如何解析”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。