溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

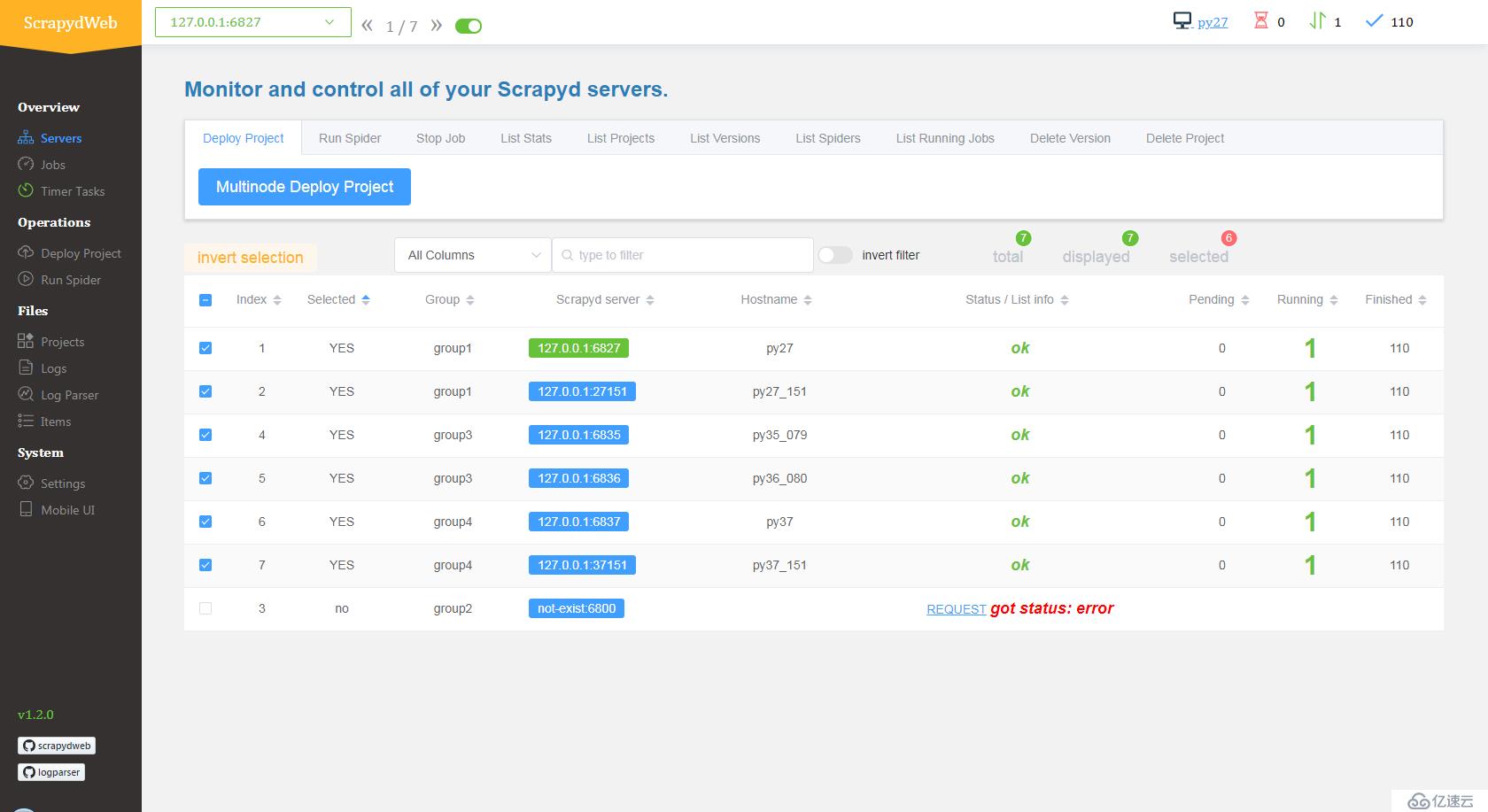

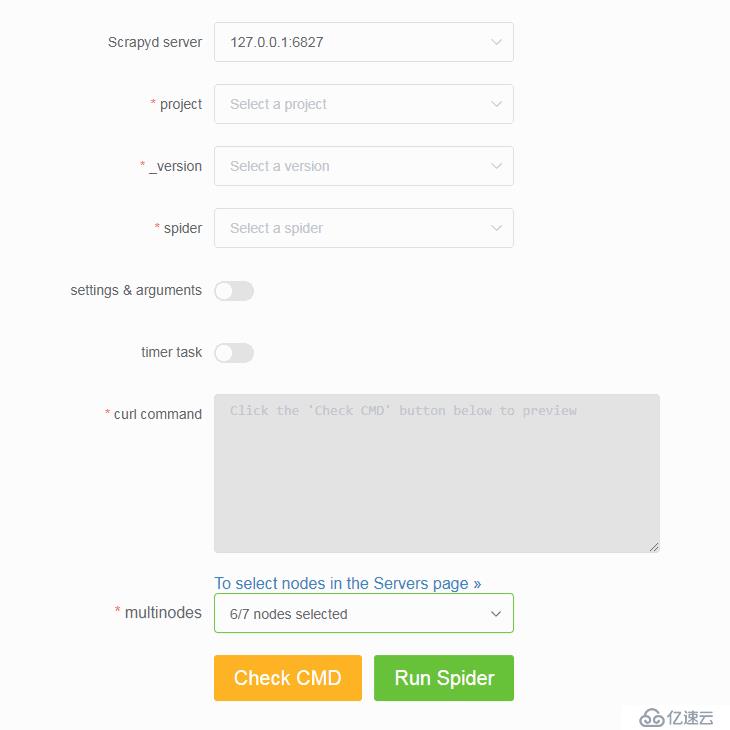

bind_address = 0.0.0.0,然后重啟 Scrapyd service。pip install scrapydwebscrapydweb 啟動 ScrapydWeb(首次啟動將自動在當前工作目錄生成配置文件)。ENABLE_AUTH = True

USERNAME = 'username'

PASSWORD = 'password'SCRAPYD_SERVERS = [

'127.0.0.1',

# 'username:password@localhost:6801#group',

('username', 'password', 'localhost', '6801', 'group'),

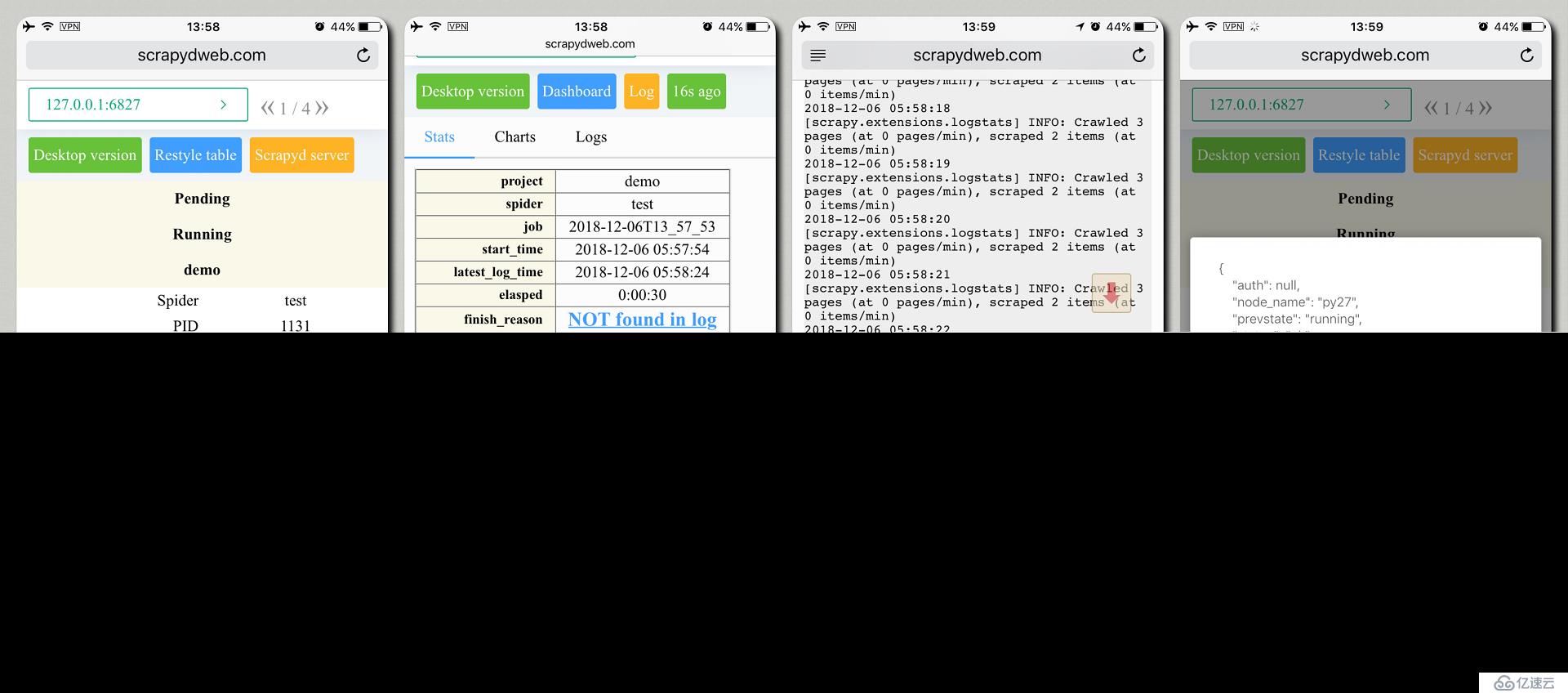

]scrapydweb 重啟 ScrapydWeb。通過瀏覽器訪問并登錄 http://127.0.0.1:5000。

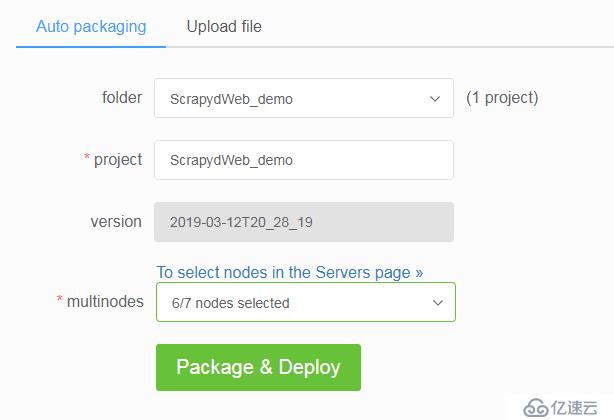

SCRAPY_PROJECTS_DIR 指定 Scrapy 項目開發目錄,ScrapydWeb 將自動列出該路徑下的所有項目,默認選定最新編輯的項目,選擇項目后即可自動打包和部署指定項目。

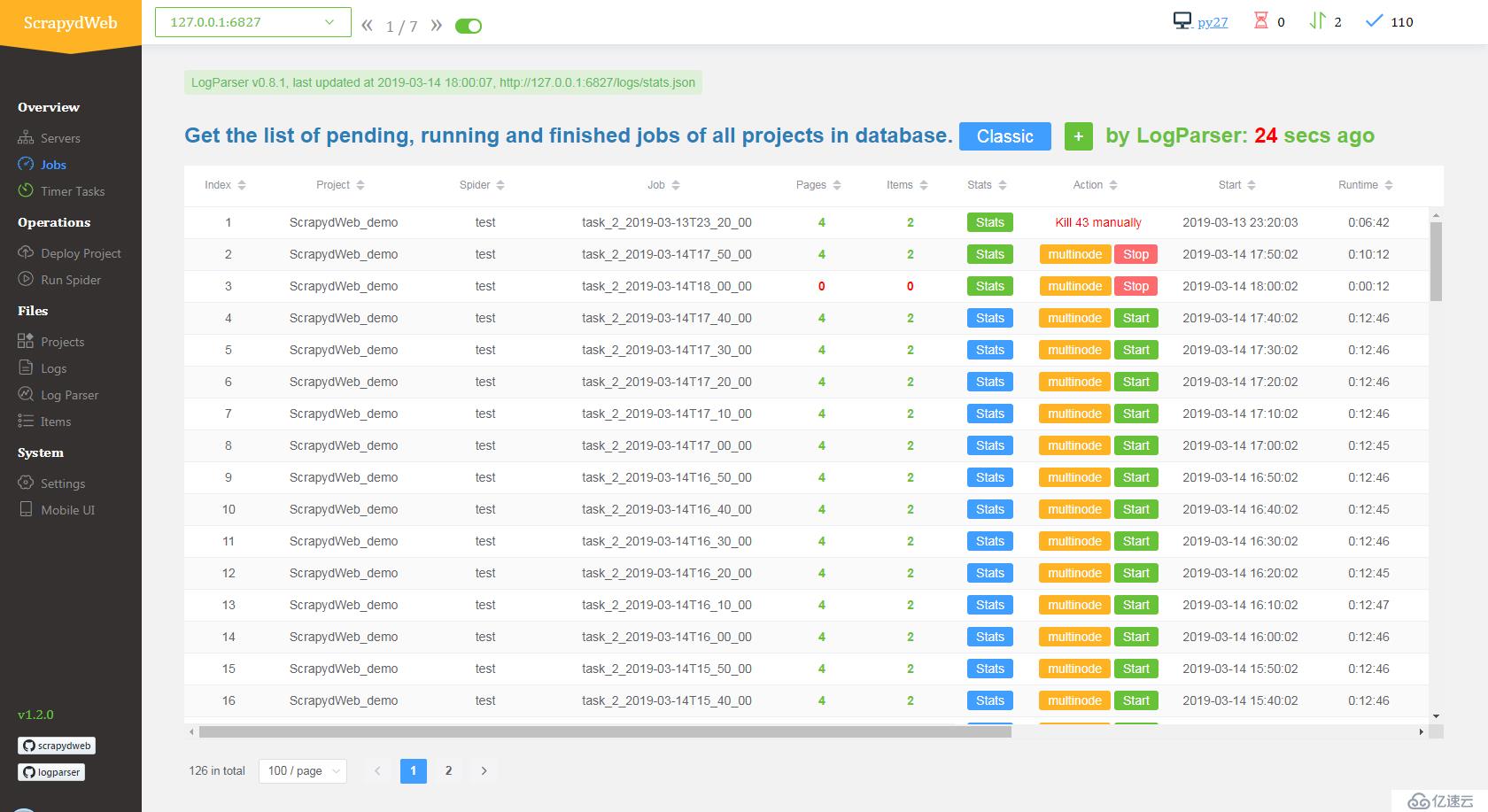

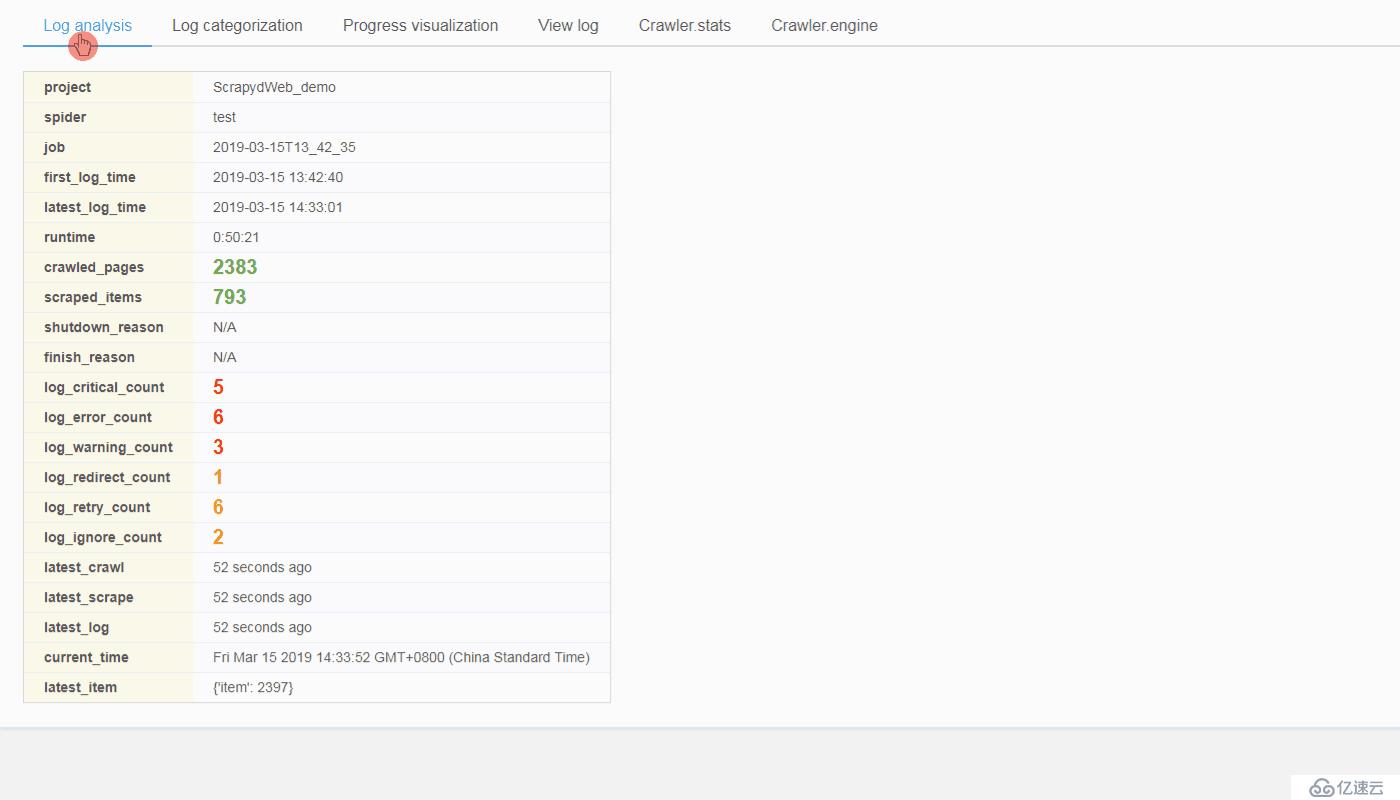

SCRAPYD_LOGS_DIR 和 ENABLE_LOGPARSER,則啟動 ScrapydWeb 時將自動運行 LogParser,該子進程通過定時增量式解析指定目錄下的 Scrapy 日志文件以加快 Stats 頁面的生成,避免因請求原始日志文件而占用大量內存和網絡資源。

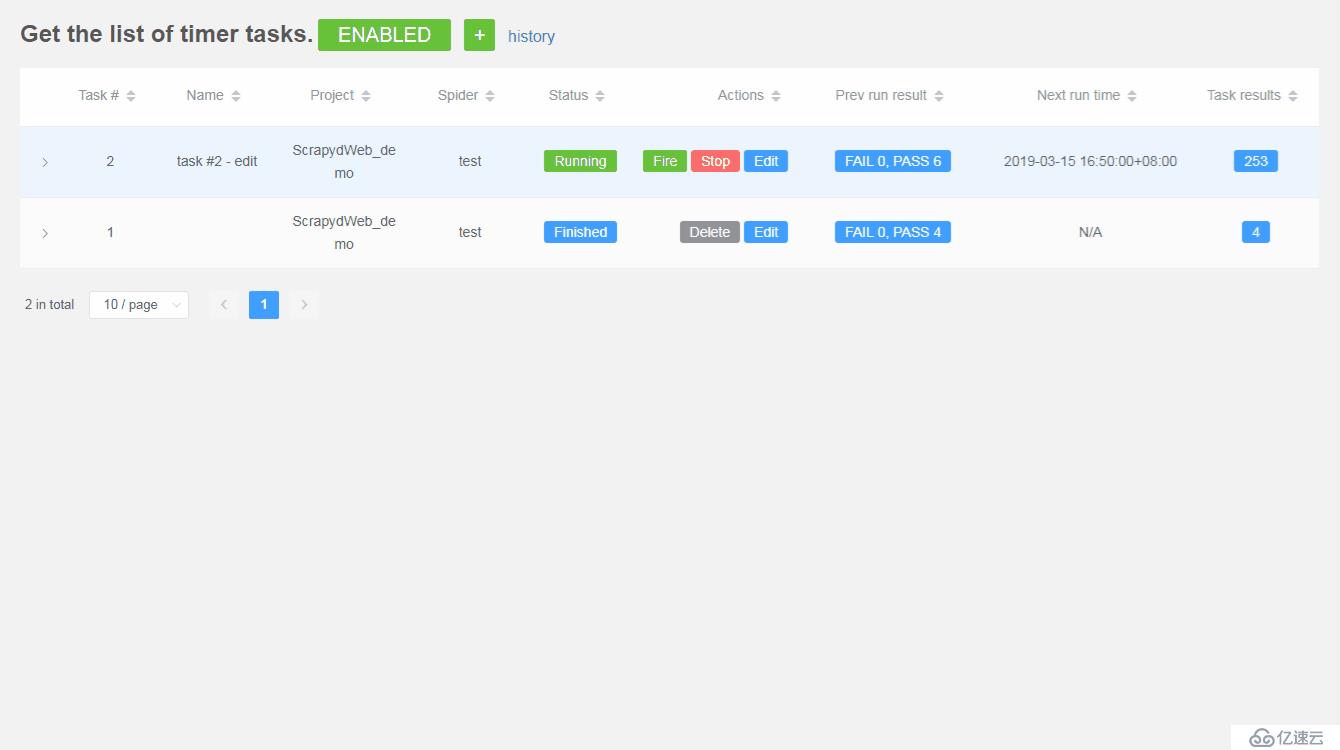

通過輪詢子進程在后臺定時模擬訪問 Stats 頁面,ScrapydWeb 將在滿足特定觸發器時根據設定自動停止爬蟲任務并發送通知郵件,郵件正文包含當前爬蟲任務的統計信息。

SMTP_SERVER = 'smtp.qq.com'

SMTP_PORT = 465

SMTP_OVER_SSL = True

SMTP_CONNECTION_TIMEOUT = 10EMAIL_USERNAME = '' # defaults to FROM_ADDR

EMAIL_PASSWORD = 'password'

FROM_ADDR = 'username@qq.com'

TO_ADDRS = [FROM_ADDR]

2. 設置郵件工作時間和基本觸發器,以下示例代表:每隔1小時或當某一任務完成時,并且當前時間是工作日的9點,12點和17點,*ScrapydWeb* 將會發送通知郵件。

```python

EMAIL_WORKING_DAYS = [1, 2, 3, 4, 5]

EMAIL_WORKING_HOURS = [9, 12, 17]

ON_JOB_RUNNING_INTERVAL = 3600

ON_JOB_FINISHED = TrueLOG_CRITICAL_THRESHOLD = 3

LOG_CRITICAL_TRIGGER_STOP = True

LOG_CRITICAL_TRIGGER_FORCESTOP = False

# ...

LOG_IGNORE_TRIGGER_FORCESTOP = False以上示例代表:當日志中出現3條或以上的 critical 級別的 log 時,ScrapydWeb 將自動停止當前任務,如果當前時間在郵件工作時間內,則同時發送通知郵件。

my8100/scrapydweb

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。