您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇文章為大家展示了Python爬蟲解析網頁的4種方式分別是什么,內容簡明扼要并且容易理解,絕對能使你眼前一亮,通過這篇文章的詳細介紹希望你能有所收獲。

用Python寫爬蟲工具在現在是一種司空見慣的事情,每個人都希望能夠寫一段程序去互聯網上扒一點資料下來,用于數據分析或者干點別的事情。

我們知道,爬蟲的原理無非是把目標網址的內容下載下來存儲到內存中,這個時候它的內容其實是一堆HTML,然后再對這些HTML內容進行解析,按照自己的想法提取出想要的數據,所以今天我們主要來講四種在Python中解析網頁HTML內容的方法,各有千秋,適合在不同的場合下使用。

首先我們隨意找到一個網址,這時我腦子里閃過了豆瓣這個網站。嗯,畢竟是用Python構建的網站,那就拿它來做示范吧。

我們找到了豆瓣的Python爬蟲小組主頁,看起來長成下面這樣。

讓我們用瀏覽器開發者工具看看HTML代碼,定位到想要的內容上,我們想要把討論組里的帖子標題和鏈接都給扒出來。

通過分析,我們發現實際上我們想要的內容在整個HTML代碼的 這個區域里,那我們只需要想辦法把這個區域內的內容拿出來就差不多了。

現在開始寫代碼。

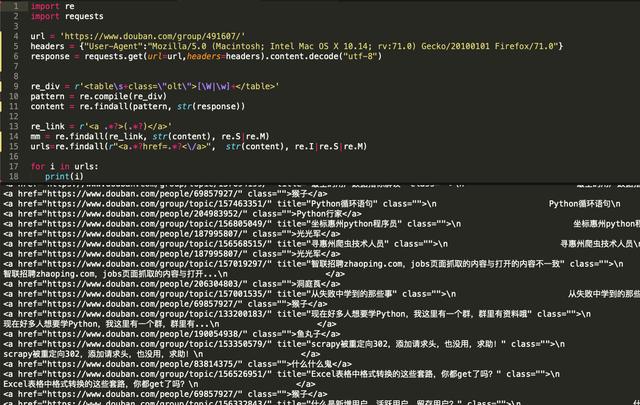

1: 正則表達式大法

正則表達式通常被用來檢索、替換那些符合某個模式的文本,所以我們可以利用這個原理來提取我們想要的信息。

參考以下代碼。

在代碼第6行和第7行,需要手動指定一下header的內容,裝作自己這個請求是瀏覽器請求,否則豆瓣會視為我們不是正常請求會返回HTTP 418錯誤。

在第7行我們直接用requests這個庫的get方法進行請求,獲取到內容后需要進行一下編碼格式轉換,同樣是因為豆瓣的頁面渲染機制的問題,正常情況下,直接獲取requests content的內容即可。

Python模擬瀏覽器發起請求并解析內容代碼:

url = 'https://www.douban.com/group/491607/'headers = {"User-Agent":"Mozilla/5.0 (Macintosh; Intel Mac OS X 10.14; rv:71.0) Gecko/20100101 Firefox/71.0"}response = requests.get(url=url,headers=headers).content.decode('utf-8')正則的好處是編寫麻煩,理解不容易,但是匹配效率很高,不過時至今日有太多現成的HTMl內容解析庫之后,我個人不太建議再手動用正則來對內容進行匹配了,費時費力。

主要解析代碼:

re_div = r'<table\s+class=\"olt\">[\W|\w]+</table>'pattern = re.compile(re_div)content = re.findall(pattern, str(response))re_link = r'<a .*?>(.*?)</a>'mm = re.findall(re_link, str(content), re.S|re.M)urls=re.findall(r"<a.*?href=.*?<\/a>", str(content), re.I|re.S|re.M)

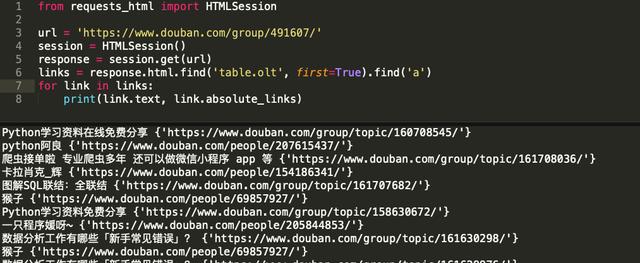

2: requests-html

這個庫其實是我個人最喜歡的庫,作則是編寫requests庫的網紅程序員 Kenneth Reitz,他在requests的基礎上加上了對html內容的解析,就變成了requests-html這個庫了。

下面我們來看看范例:

我喜歡用requests-html來解析內容的原因是因為作者依據幫我高度封裝過了,連請求返回內容的編碼格式轉換也自動做了,完全可以讓我的代碼邏輯簡單直接,更專注于解析工作本身。

主要解析代碼:

links = response.html.find('table.olt', first=True).find('a')安裝途徑: pip install requests-html

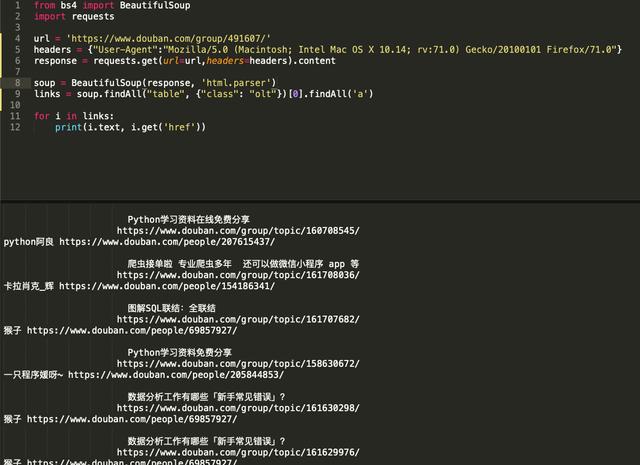

3: BeautifulSoup

大名鼎鼎的 BeautifulSoup庫,出來有些年頭了,在Pyhton的HTML解析庫里屬于重量級的庫,其實我評價它的重量是指比較臃腫,大而全。

還是來先看看代碼。

soup = BeautifulSoup(response, 'html.parser')links = soup.findAll("table", {"class": "olt"})[0].findAll('a')BeautifulSoup解析內容同樣需要將請求和解析分開,從代碼清晰程度來講還將就,不過在做復雜的解析時代碼略顯繁瑣,總體來講可以用,看個人喜好吧。

安裝途徑: pip install beautifulsoup4

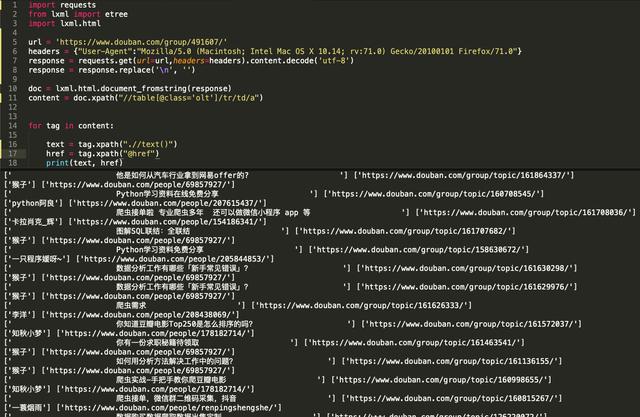

4: lxml的XPath

lxml這個庫同時 支持HTML和XML的解析,支持XPath解析方式,解析效率挺高,不過我們需要熟悉它的一些規則語法才能使用,例如下圖這些規則。

來看看如何用XPath解析內容。

主要解析代碼:

content = doc.xpath("//table[@class='olt']/tr/td/a")

如上圖,XPath的解析語法稍顯復雜,不過熟悉了語法的話也不失為一種優秀的解析手段,因為。

安裝途徑: pip install lxml

四種方式總結

正則表達式匹配不推薦,因為已經有很多現成的庫可以直接用,不需要我們去大量定義正則表達式,還沒法復用,在此僅作參考了解。

BeautifulSoup是基于DOM的方式,簡單的說就是會在解析時把整個網頁內容加載到DOM樹里,內存開銷和耗時都比較高,處理海量內容時不建議使用。不過BeautifulSoup不需要結構清晰的網頁內容,因為它可以直接find到我們想要的標簽,如果對于一些HTML結構不清晰的網頁,它比較適合。

XPath是基于SAX的機制來解析,不會像BeautifulSoup去加載整個內容到DOM里,而是基于事件驅動的方式來解析內容,更加輕巧。不過XPath要求網頁結構需要清晰,而且開發難度比DOM解析的方式高一點,推薦在需要解析效率時使用。

requests-html 是比較新的一個庫,高度封裝且源碼清晰,它直接整合了大量解析時繁瑣復雜的操作,同時支持DOM解析和XPath解析兩種方式,靈活方便,這是我目前用得較多的一個庫。

除了以上介紹到幾種網頁內容解析方式之外還有很多解析手段,在此不一一進行介紹了。

寫一個爬蟲,最重要的兩點就是如何抓取數據,如何解析數據,我們要活學活用,在不同的時候利用最有效的工具去完成我們的目的。

上述內容就是Python爬蟲解析網頁的4種方式分別是什么,你們學到知識或技能了嗎?如果還想學到更多技能或者豐富自己的知識儲備,歡迎關注億速云行業資訊頻道。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。