您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“Pandas輕松處理超大規模數據的方法是什么”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

處理大規模數據集時常是棘手的事情,尤其在內存無法完全加載數據的情況下。在資源受限的情況下,可以使用 Python Pandas 提供的一些功能,降低加載數據集的內存占用。可用技術包括壓縮、索引和數據分塊。

在上述過程中需要解決一些問題,其中之一就是數據量過大。如果數據量超出本機內存的容量,項目執行就會產生問題。

對此有哪些解決方案?

有多種解決數據量過大問題的方法。它們或是消耗時間,或是需要增加投資。

可能的解決方案

投資解決:新購有能力處理整個數據集,具有更強 CPU 和更大內存的計算機。或是去租用云服務或虛擬內存,創建處理工作負載的集群。

耗時解決:如果內存不足以處理整個數據集,而硬盤的容量要遠大于內存,此時可考慮使用硬盤存儲數據。但使用硬盤管理數據會大大降低處理性能,即便是 SSD 也要比內存慢很多。

只要資源允許,這兩種解決方法均可行。如果項目資金充裕,或是不惜任何時間代價,那么上述兩種方法是最簡單也是最直接的解決方案。

但如果情況并非如此呢?也許你的資金有限,或是數據集過大,從磁盤加載將增加 5~6 倍甚至更多的處理時間。是否有無需額外資金投入或時間開銷的大數據解決方案呢?

這個問題正中我的下懷。

有多種技術可用于大數據處理,它們無需額外付出投資,也不會耗費大量加載的時間。本文將介紹其中三種使用 Pandas 處理大規模數據集的技術。

壓 縮

第一種技術是數據壓縮。壓縮并非指將數據打包為 ZIP 文件,而是以壓縮格式在內存中存儲數據。

換句話說,數據壓縮就是一種使用更少內存表示數據的方法。數據壓縮有兩種類型,即無損壓縮和有損壓縮。這兩種類型只影響數據的加載,不會影響到處理代碼。

無損壓縮

無損壓縮不會對數據造成任何損失,即原始數據和壓縮后的數據在語義上保持不變。執行無損壓縮有三種方式。在下文中,將使用美國按州統計的新冠病毒病例數據集依次介紹。

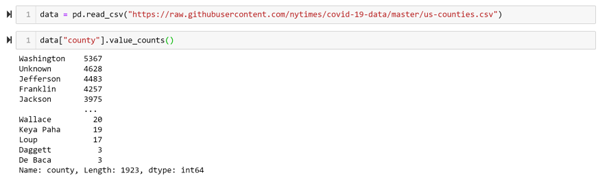

加載特定的數據列

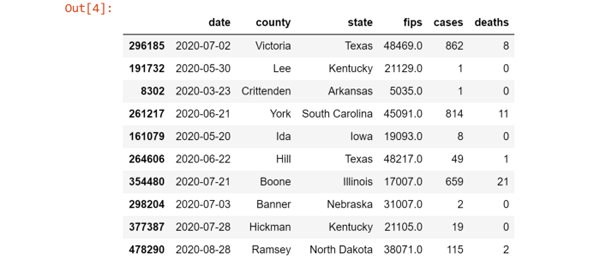

例子中所使用的數據集具有如下結構:

import pandas as pd data = pd.read_csv("https://raw.githubusercontent.com/nytimes/covid-19-data/master/us-counties.csv") data.sample(10)

加載整個數據集需要占用 111MB 內存!

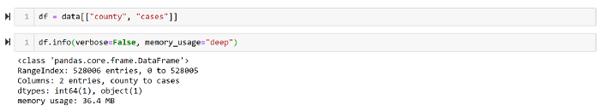

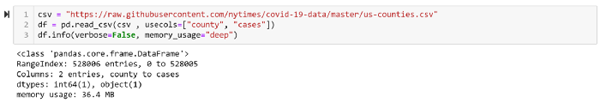

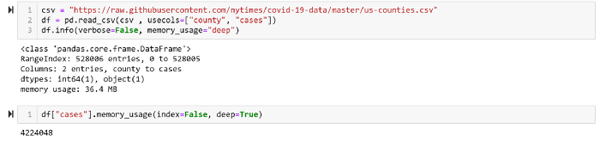

如果我們只需要數據集中的兩列,即州名和病例數,那么為什么要加載整個數據集呢?加載所需的兩列數據只需 36MB,可降低內存使用 32%。

使用 Pandas 加載所需數據列的代碼如下:

本節使用的代碼片段如下:

# 加載所需軟件庫 Import needed library import pandas as pd # 數據集 csv = "https://raw.githubusercontent.com/nytimes/covid-19-data/master/us-counties.csv" # 加載整個數據集 data = pd.read_csv(csv) data.info(verbose=False, memory_usage="deep") # 創建數據子集 df = data[["county", "cases"]] df.info(verbose=False, memory_usage="deep") # 加速所需的兩列數據 df_2col = pd.read_csv(csv , usecols=["county", "cases"]) df_2col.info(verbose=False, memory_usage="deep")

代碼地址:

https://gist.github.com/SaraM92/3ba6cac1801b20f6de1ef3cc4a18c843#file-column_selecting-py

操作數據類型

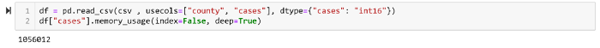

另一個降低數據內存使用量的方法是截取數值項。例如將 CSV 加載到 DataFrame,如果文件中包含數值,那么一個數值就需要 64 個字節存儲。但可通過使用 int 格式截取數值以節省內存。

int8 存儲值的范圍是 -128 到 127;

int16 存儲值的范圍是 -32768 到 32767;

int64 存儲值的范圍是 -9223372036854775808 到 9223372036854775807。

如果可預先確定數值不大于 32767,那么就可以使用 int16 或 int32 類型,該列的內存占用能降低 75%。

假定每個州的病例數不超過 32767(雖然現實中并非如此),那么就可截取該列為 int16 類型而非 int64。

稀疏列

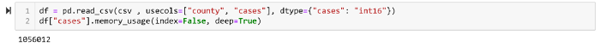

如果數據集的一或多個列中具有大量的 NaN 空值,那么可以使用 稀疏列表示 降低內存使用,以免空值耗費內存。

假定州名這一列存在一些空值,我們需要跳過所有包含空值的行。該需求可使用 pandas.sparse 輕松實現(譯者注:原文使用 Sparse Series,但在 Pandas 1.0.0 中已經移除了 SparseSeries)。

有損壓縮

如果無損壓縮并不滿足需求,還需要進一步壓縮,那么應該如何做?這時可使用有損壓縮,權衡內存占用而犧牲數據百分之百的準確性。

有損壓縮有兩種方式,即修改數值和抽樣。

修改數值:有時并不需要數值保留全部精度,這時可以將 int64 截取為 int32 甚至是 int16。

抽樣:如果需要確認某些州的新冠病例數要高于其它州,可以抽樣部分州的數據,查看哪些州具有更多的病例。這種做法是一種有損壓縮,因為其中并未考慮到所有的數據行。

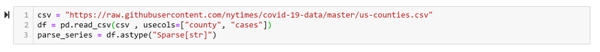

第二種技術:數據分塊(chunking)

另一個處理大規模數據集的方法是數據分塊。將大規模數據切分為多個小分塊,進而對各個分塊分別處理。在處理完所有分塊后,可以比較結果并給出最終結論。

本文使用的數據集中包含了 1923 行數據。

假定我們需要找出具有最多病例的州,那么可以將數據集切分為每塊 100 行數據,分別處理每個數據塊,從這各個小結果中獲取最大值。

本節代碼片段如下:

# 導入所需軟件庫 import pandas as pd # 數據集 csv = "https://raw.githubusercontent.com/nytimes/covid-19-data/master/us-counties.csv" # 循環處理每個數據塊,獲取每個數據塊中的最大值 result = {} for chunk in pd.read_csv(csv, chunksize=100): max_case = chunk["cases"].max() max_case_county = chunk.loc[chunk[ cases ] == max_case, county ].iloc[0] result[max_case_county] = max_case # 給出結果 print(max(result, key=result.get) , result[max(result, key=result.get)])代碼地址:

https://gist.github.com/SaraM92/808ed30694601e5eada5e283b2275ed7#file-chuncking-py

第三種方法:索引

數據分塊非常適用于數據集僅加載一次的情況。但如果需要多次加載數據集,那么可以使用索引技術。

索引可理解為一本書的目錄。無需讀完整本書就可以獲取所需得信息。

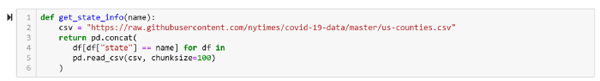

例如,分塊技術非常適用于獲取指定州的病例數。編寫如下的簡單函數,就能實現這一功能。

索引 vs 分塊

分塊需讀取所有數據,而索引只需讀取部分數據。

上面的函數加載了每個分塊中的所有行,但我們只關心其中的一個州,這導致大量的額外開銷。可使用 Pandas 的數據庫操作,例如簡單的做法是使用 SQLite 數據庫。

首先,需要將 DataFrame 加載到 SQLite 數據庫,代碼如下:

import sqlite3 csv = "https://raw.githubusercontent.com/nytimes/covid-19-data/master/us-counties.csv" # 創建新的數據庫文件 db = sqlite3.connect("cases.sqlite") # 按塊加載 CSV 文件 for c in pd.read_csv(csv, chunksize=100): # 將所有數據行加載到新的數據庫表中 c.to_sql("cases", db, if_exists="append") # 為“state”列添加索引 db.execute("CREATE INDEX state ON cases(state)") db.close()代碼地址:

https://gist.github.com/SaraM92/5b445d5b56be2d349cdfa988204ff5f3#file-load_into_db-py

為使用數據庫,下面需要重寫 get_state_info 函數。

這樣可降低內存占用 50%。

“Pandas輕松處理超大規模數據的方法是什么”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。