您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

這篇文章給大家分享的是有關Python爬蟲之批量下載喜馬拉雅音頻的方法的內容。小編覺得挺實用的,因此分享給大家做個參考,一起跟隨小編過來看看吧。

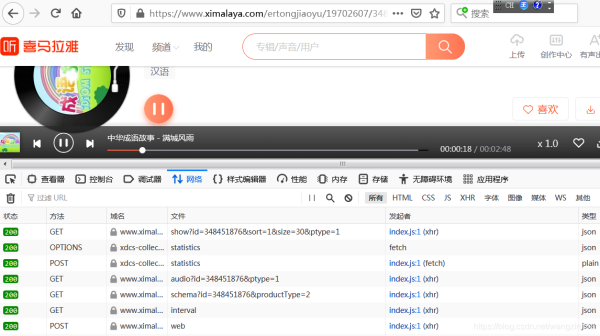

在喜馬拉雅網站上,隨便點開一個音頻,打開“開發者工具”,再點擊播放按鈕,可以看到出現了多個請求:

經過排查,發現可疑url:

查看它的響應信息,發現音頻地址就在里面:

接下來,解析這個返回音頻地址的url:

https://www.ximalaya.com/revision/play/v1/audio?id=348451879&ptype=1

發現url中的id參數就決定了返回的音頻地址,而id參數是音頻的id號。

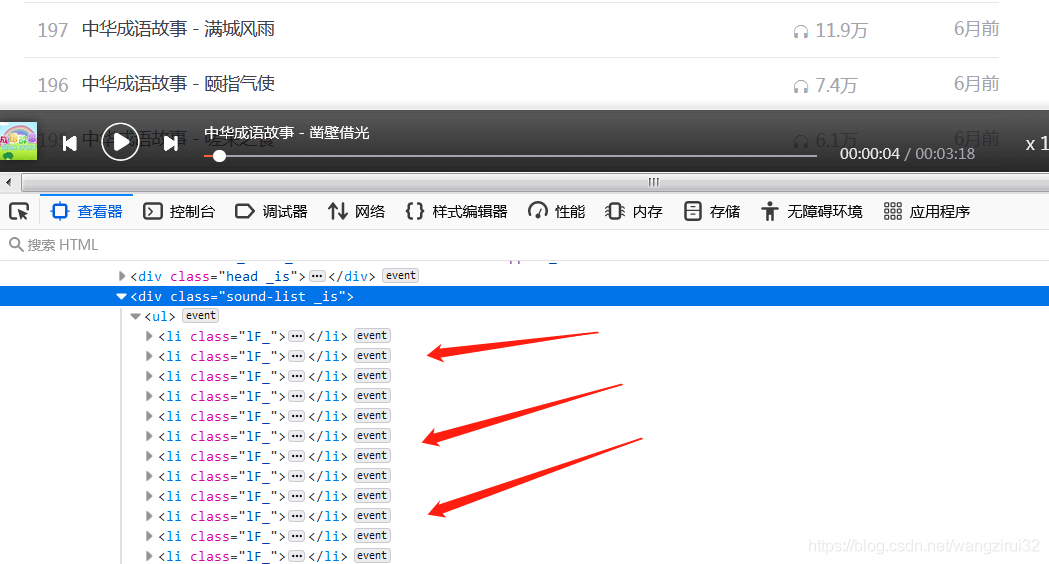

我們已經知道了獲取音頻url的網址,接下來要獲取一個專欄內的音頻id和名稱,打開一個專欄,發現:

所有的音頻存放在class為1F_的li標簽中,再來解析li標簽:

在li標簽中的第一個a標簽存儲著我們所有需要的數據,妙~啊!

思路:

1.獲取專欄內的li標簽

2.獲取li標簽里的第一個a標簽

3.讀取a標簽的title和href屬性

4.將href解析成音頻id

5.將id帶入url請求音頻源地址

6.提取音頻源地址

7.請求音頻源地址

8.保存音頻(文件名為a的title屬性)

思路整理完了,開始編寫代碼。

代碼奉上——

import requests

from fake_useragent import UserAgent as ua

from bs4 import BeautifulSoup as bs

# 專欄地址

music_list_url = 'https://www.ximalaya.com/ertongjiaoyu/19702607/'

# 獲取音頻地址的url

get_link_url = "https://www.ximalaya.com/revision/play/v1/audio"

# UA偽裝

headers = {

"User-Agent": ua().random

}

# 參數

params = {

"id": None, # id先設為None

"ptype": "1",

}

# 獲取專欄HTML源碼

music_list_r = requests.get(music_list_url, headers=headers)

# 解析 獲取所有li標簽

soup = bs(music_list_r.text, "lxml")

li = soup.find_all("li", {"class": "lF_"})

# for循序遍歷處理

for i in li:

a = i.find("a") # 找到a標簽

# 獲取href屬性

# split("/")將字符串以"/"作為分隔符 從右往左數第一項是id號

music_id = a.get("href").split("/")[-1]

# 獲取title屬性 和“.m4a”拼接成文件名

music_name = a.get("title") + ".m4a"

# 修改請求參數id

params['id'] = music_id

# 獲得音頻源地址

r = requests.get(get_link_url, headers=headers, params=params)

link = r.json()['data']['src']

# 獲取音頻文件并保存

music_file = requests.get(link).content

with open(music_name, "wb") as f:

f.write(music_file)

print("下載完畢!")運行代碼,等待億會(真的要等億會),可以看到當前目錄下已經出現了音頻文件,如圖:

感謝各位的閱讀!關于“Python爬蟲之批量下載喜馬拉雅音頻的方法”這篇文章就分享到這里了,希望以上內容可以對大家有一定的幫助,讓大家可以學到更多知識,如果覺得文章不錯,可以把它分享出去讓更多的人看到吧!

python的五大特點:1.簡單易學,開發程序時,專注的是解決問題,而不是搞明白語言本身。2.面向對象,與其他主要的語言如C++和Java相比, Python以一種非常強大又簡單的方式實現面向對象編程。3.可移植性,Python程序無需修改就可以在各種平臺上運行。4.解釋性,Python語言寫的程序不需要編譯成二進制代碼,可以直接從源代碼運行程序。5.開源,Python是 FLOSS(自由/開放源碼軟件)之一。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。