您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

首先這次學習的是利用寫Python腳本對網頁信息的獲取,并且把他保存到我們的數據庫里最后形成一個Excel表格

剛開始我們需要做一些準備:

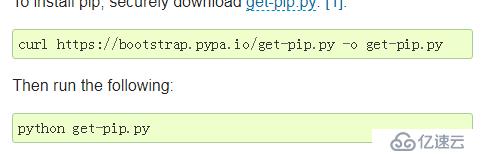

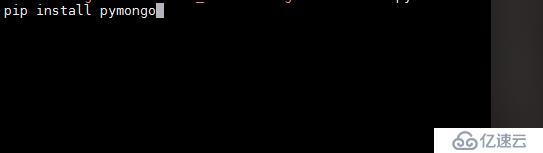

先安裝第三方模塊

https://fastdl.mongodb.org/linux/mongodb-linux-x86_64-rhel70-3.2.5.tgz

思路如下:

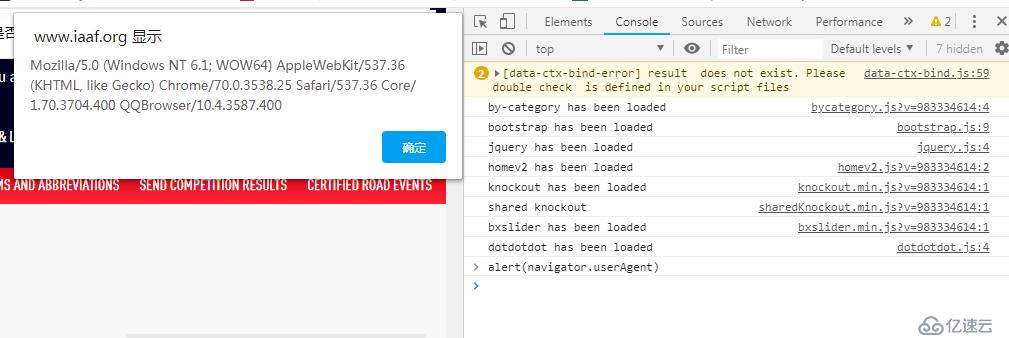

headers獲取:

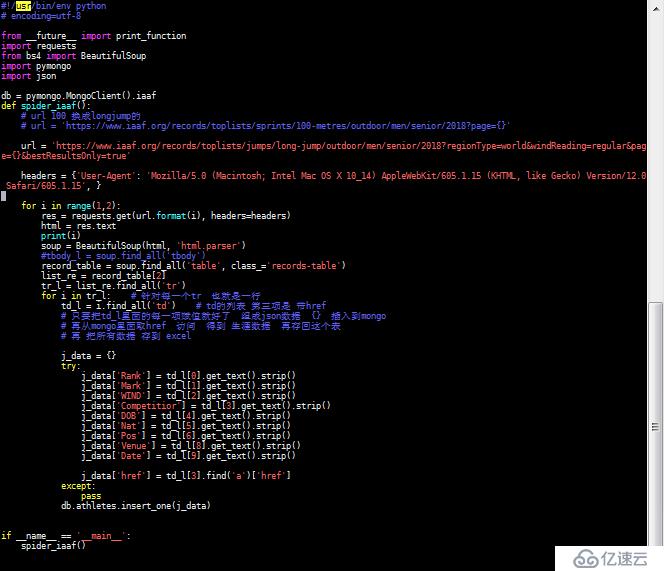

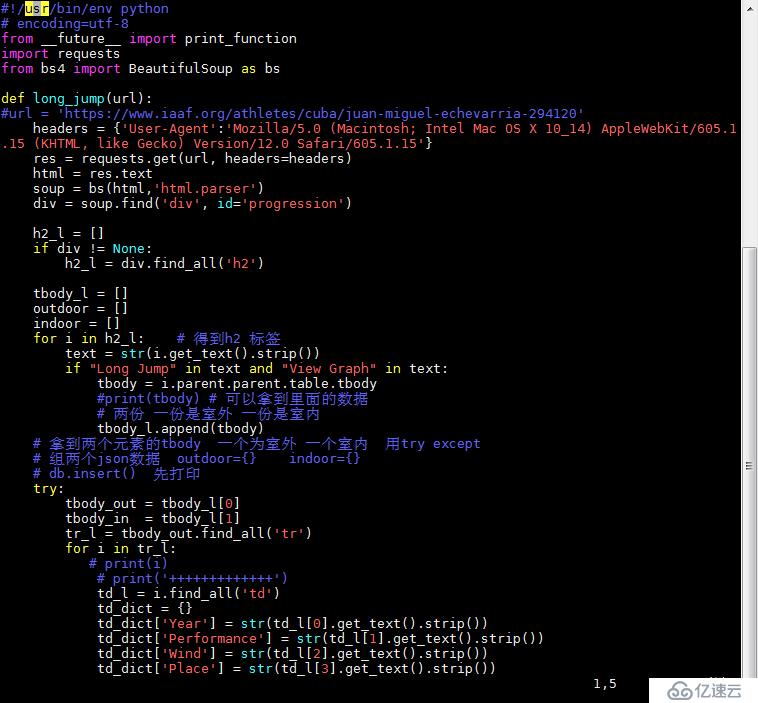

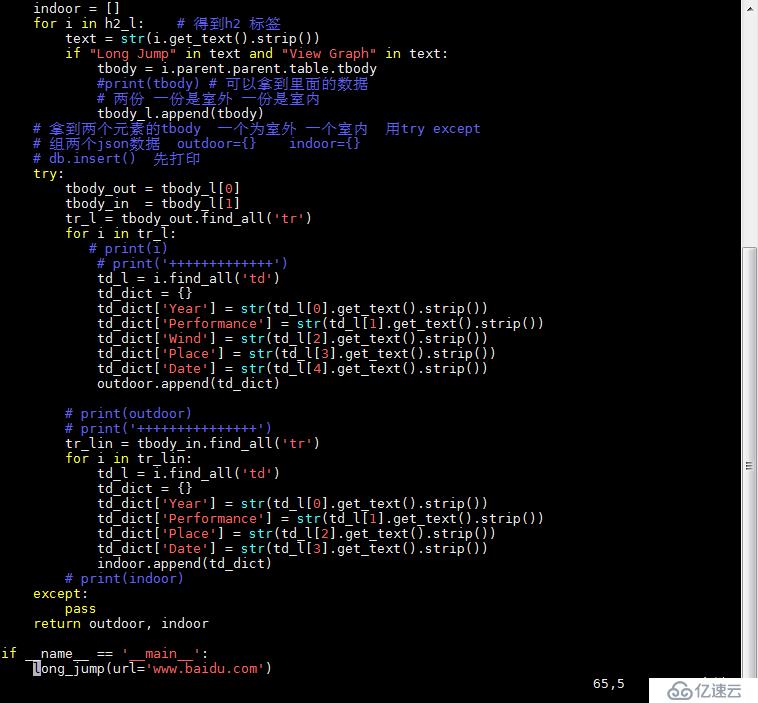

腳本1:

運行前打開mongod :

./mongod &

腳本2:

Long Jump 和 View Graph 是根據他們可以定位到我們想獲取的信息的標簽上

這個腳本寫完不需要運行,他的url是由第三個腳本導入的

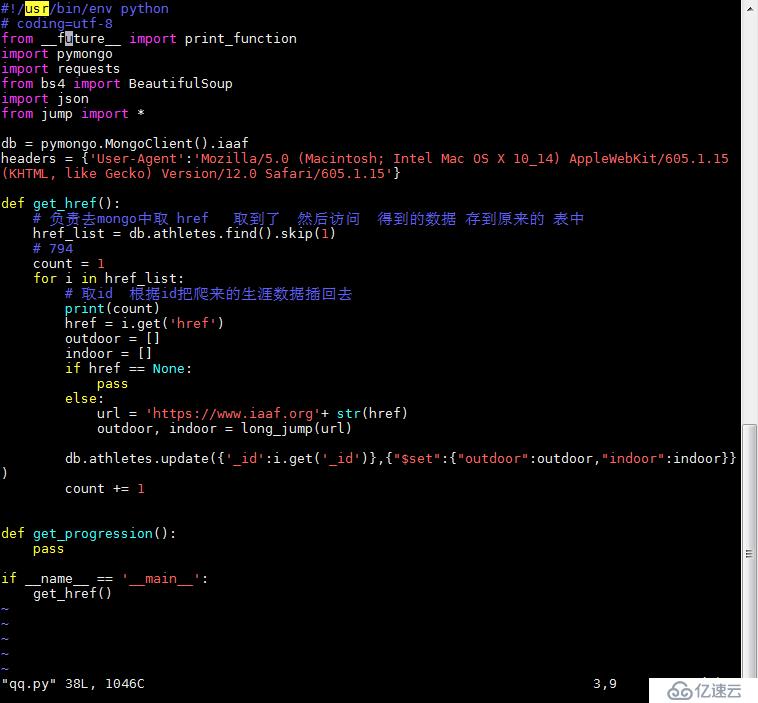

腳本3:

運行前都要檢查MongoD是否運行,運行后可進入數據庫去看我們存入的信息

在MongoDB的bin下

./mongo

use iaaf

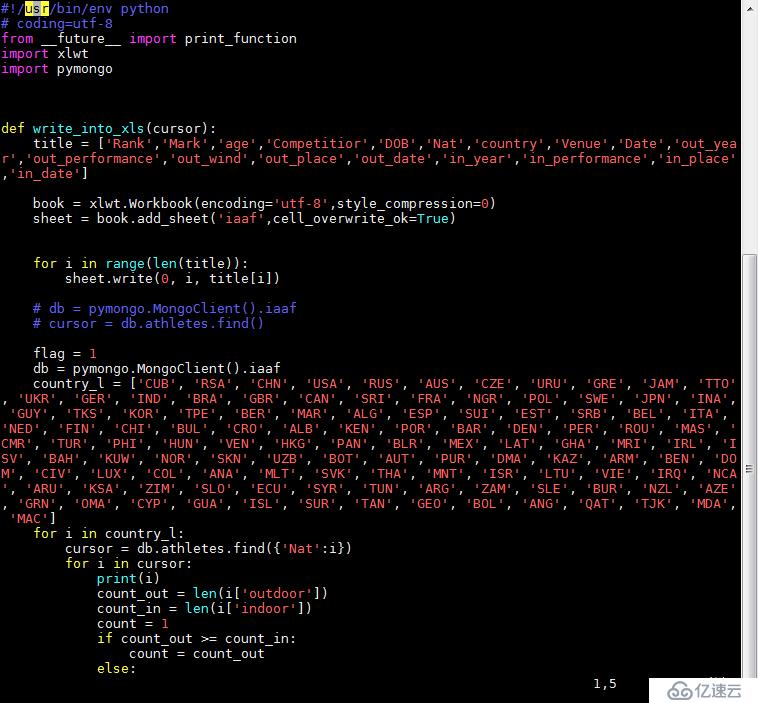

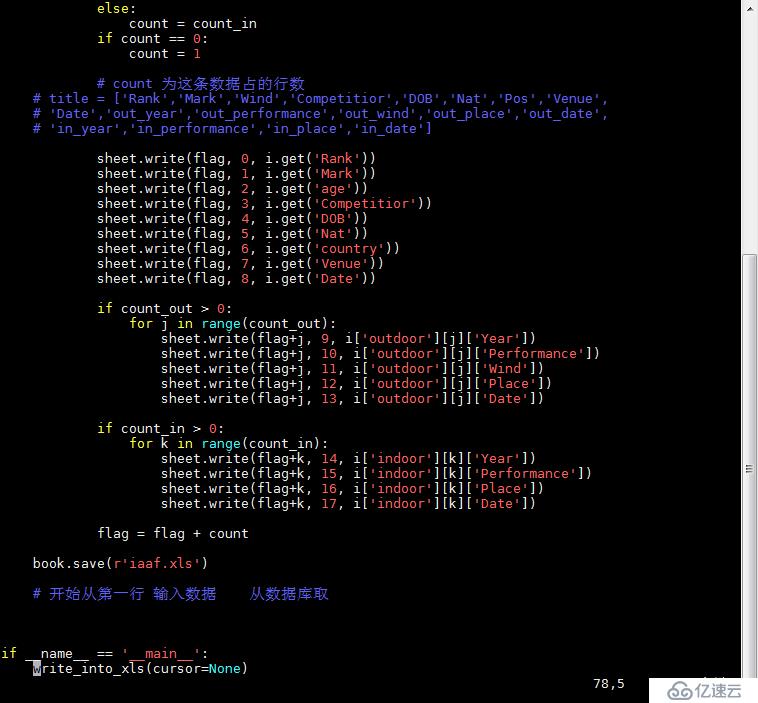

db.athletes.find()腳本4:

requests是一個很實用的Python HTTP客戶端庫,編寫爬蟲和測試服務器響應數據時經常會用到。可以說,Requests 完全滿足如今網絡的需求

1.作用:發送請求獲取響應為什么使用requesst?

1)requests底層實現的是urllib2)requests在python2和python3中通用,方法完全一樣

3)requests簡單易用(python特性)

4)requests能夠幫助我們解壓響應內容(自動解壓完善請求頭,自動獲取cookie)

pymongo是python操作 mongodb的工具包

bs4概念:

bs4庫是解析、遍歷、維護、"標簽樹"的功能庫

通俗一點說就是:bs4庫把HTML源代碼重新進行了格式化,

從而方便我們對其中的節點、標簽、屬性等進行操作

2.BS4的4中對象

①Tag對象:是html中的一個標簽,用BeautifulSoup就能解析出來Tag的具體內容,具體

的格式為‘soup.name‘,其中name是html下的標簽。

②BeautifulSoup對象:整個html文本對象,可當作Tag對象

③NavigableString對象:標簽內的文本對象

④Comment對象:是一個特殊的NavigableString對象,如果html標簽內存在注釋,那么它可以過濾掉注釋符號保留注釋文本

最常用的還是BeautifulSoup對象和Tag對象

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。