您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

小編給大家分享一下python怎么通過文本文件限制爬蟲,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

我們最近講過的一些限制爬蟲方法,都需要自己手動輸入代碼進行調試。根據我們學過的插件安裝,是不是在python爬蟲中也有類似簡便的辦法,能輕松地起到阻攔的作用呢?小編想說有一種文本文件的方法正好符合python初學者的安裝需求,接下來我們就robots.txt進行簡單介紹以及其限制爬蟲的方法。

robots.txt(統一小寫)是一種存放于網站根目錄下的ASCII編碼的文本文件,它通常告訴網絡搜索引擎的漫游器(又稱網絡蜘蛛),此網站中的哪些內容是不應被搜索引擎的漫游器獲取的,哪些是可以被漫游器獲取的。因為一些系統中的URL是大小寫敏感的,所以robots.txt的文件名應統一為小寫。robots.txt應放置于網站的根目錄下。如果想單獨定義搜索引擎的漫游器訪問子目錄時的行為,那么可以將自定的設置合并到根目錄下的robots.txt,或者使用robots元數據(Metadata,又稱元數據)。

robots.txt協議并不是一個規范,而只是約定俗成的,所以并不能保證網站的隱私。注意robots.txt是用字符串比較來確定是否獲取URL,所以目錄末尾有與沒有斜杠“/”表示的是不同的URL。robots.txt允許使用類似"Disallow: *.gif"這樣的通配符。

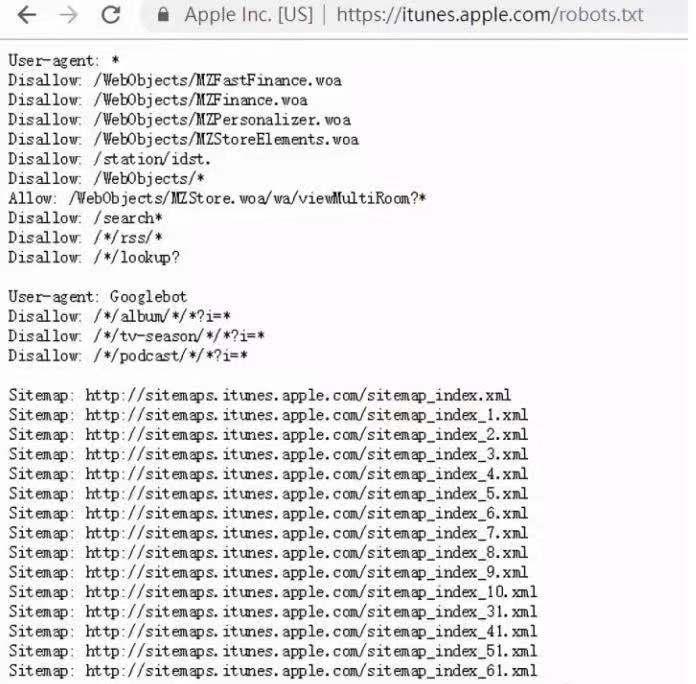

itunes的robots.txt

缺點:

只是一個君子協議,對于良好的爬蟲比如搜索引擎有效果,對于有目的性的爬蟲不起作用

以上是“python怎么通過文本文件限制爬蟲”這篇文章的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。