您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

摘要: elasticsearch是使用比較廣泛的分布式搜索引擎,es提供了一個的單字分詞工具,還有一個分詞插件ik使用比較廣泛,hanlp是一個自然語言處理包,能更好的根據上下文的語義,人名,地名,組織機構名等來切分詞

Elasticsearch

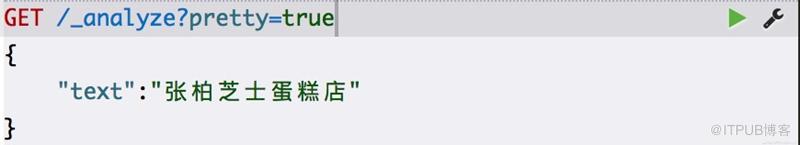

默認分詞

輸出:

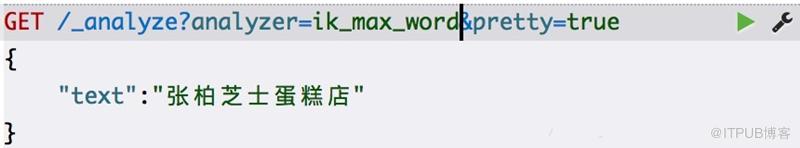

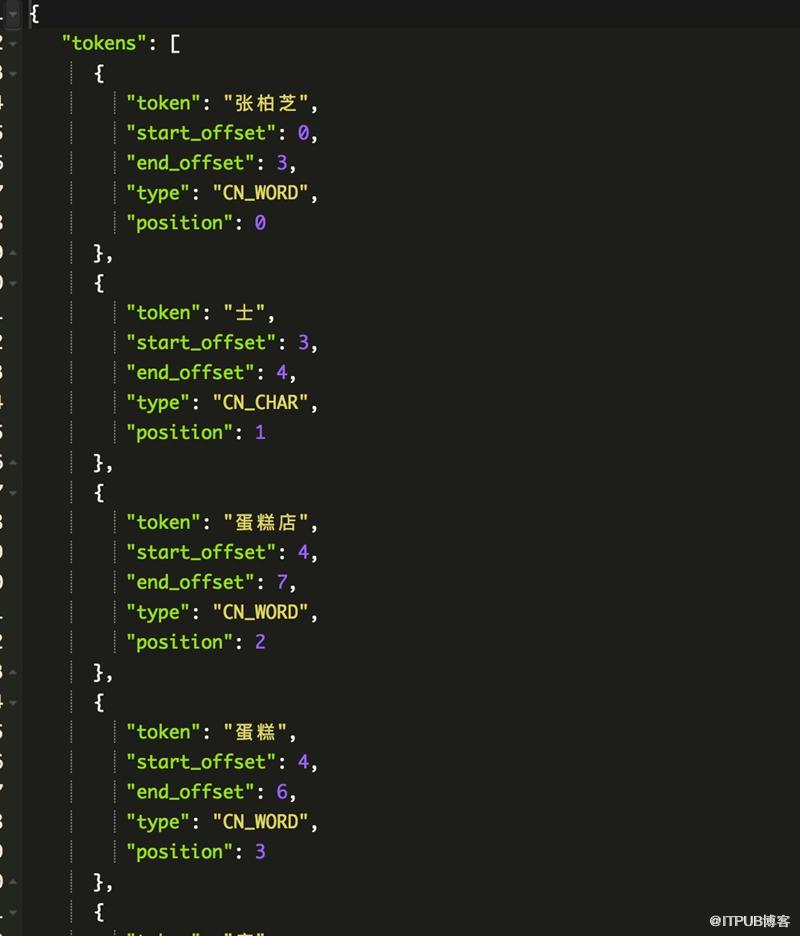

IK分詞

輸出:

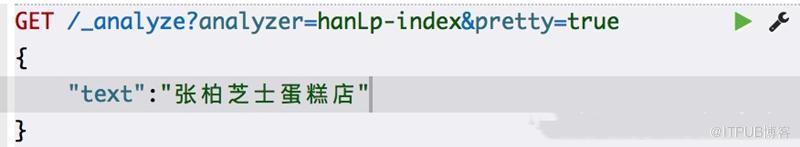

hanlp分詞

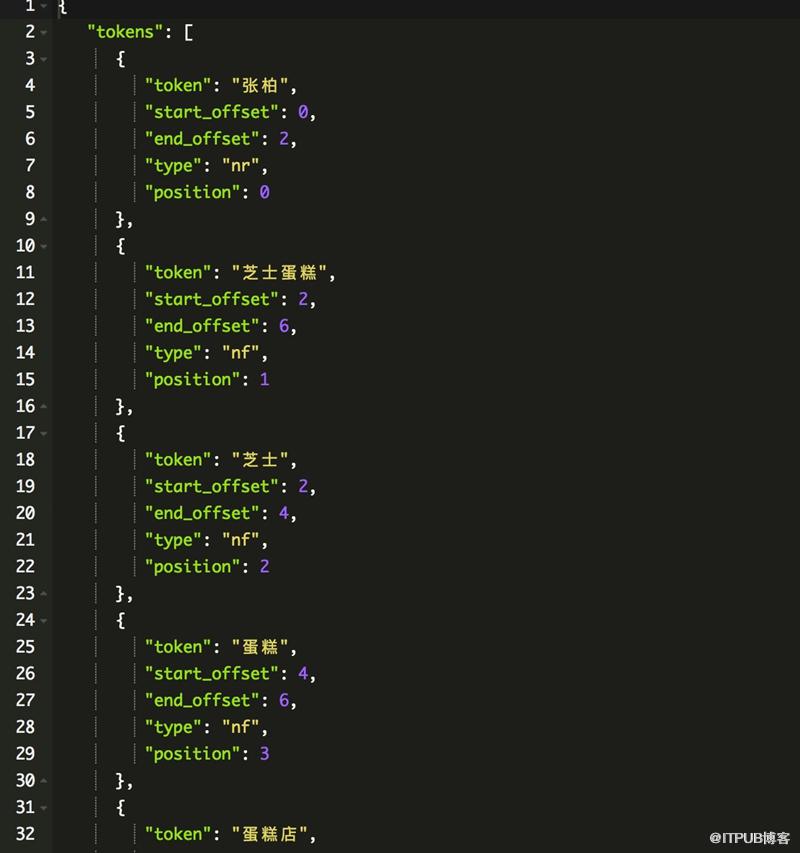

輸出:

ik分詞沒有根據句子的含義來分詞,hanlp能根據語義正確的切分出詞

安裝步驟:

1、進入https://github.com/pengcong90/elasticsearch-analysis-hanlp,下載插件并解壓到es的plugins目錄下,修改analysis-hanlp目錄下的hanlp.properties文件,修改root的屬性,值為analysis-hanlp下的data

目錄的地址

2、修改es config目錄下的jvm.options文件,最后一行添加

-Djava.security.policy=../plugins/analysis-hanlp/plugin-security.policy

重啟 es

GET /_analyze?analyzer=hanlp-index&pretty=true

{

“text”:”張柏芝士蛋糕店”

}

測試是否安裝成功

analyzer有hanlp-index(索引模式)和hanlp-smart(智能模式)

自定義詞典

修改 plugins/analysis-hanlp/data/dictionary/custom下的 我的詞典.txt文件

格式遵從 [單詞] [詞性A] [A的頻次]

修改完后刪除同目錄下的 CustomDictionary.txt.bin文件

重啟 es服務

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。