您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

AI算法的發展,真有那么迅猛嗎?

為了一探究竟,來自MIT的研究人員,便對 81種AI算法做了橫測,結果令人大跌眼鏡:

沒有明確證據表明,這些算法在10年內,對任務效果有明顯改善。

針對類似的問題,Science最近也發文表示:

人工智能在某些領域的進步引人注目,但這并不是真正的進步。

那么,這到底是怎么一回事?

MIT研究人員橫測的對象,是81種 剪枝算法。

這類算法簡單來說,就是對神經網絡的連接做“修修剪剪”,以此來提高效率。

然而,這種算法的發展現狀,正如Science發文作者Matthew Hutson所說:

很多科研工作者就在此之上,做了些許“微調”,然后就宣稱自己的算法具有優勢。

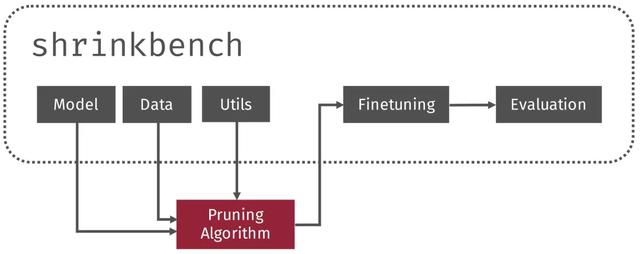

因此,MIT的研究人員便對這些算法做了 元分析,還提出了一種框架—— ShrinkBench,用來促進剪枝算法的標準化評估。

真正的好算法,需要經得起考驗,那么結果又如何呢?

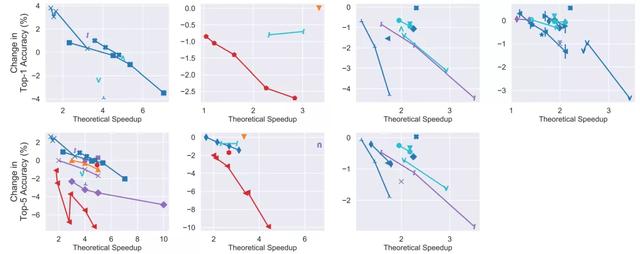

研究人員基于ImageNet,繪制了剪枝后模型的準確率和壓縮/加速水平,以及沒有做過剪枝、不同架構的相同指標,結果如下圖所示。

不難看出,一個給定架構經過剪枝后,可以改善其時間/空間與精度之間的權衡,有時候還可以提高精度。

但剪枝的效果,通常 不如換個架構效果來得好。

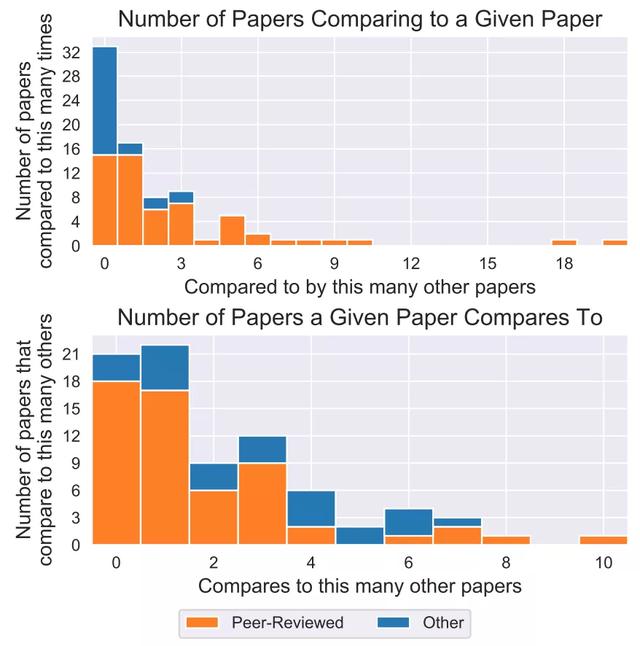

這一維度的考慮,是因為研究人員發現,許多工作都高舉“SOTA”旗幟,然而比較的對象卻不全。

很明顯的現象就是,缺少與2010年之前提出的算法的比較,甚至都沒有跟其它號稱SOTA的算法做對比,如下圖所示。

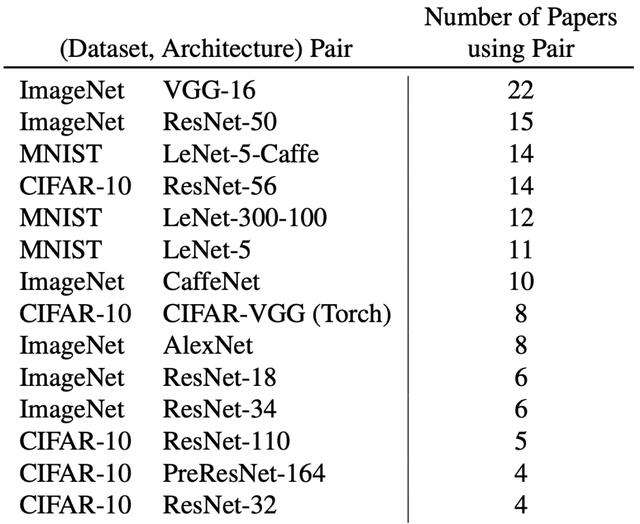

在81篇論文中,ImageNet和VGG-16的組合最為常見,并且,在前六種最常見的組合中,有三種涉及MNIST。

但MNIST與其它主流圖像分類數據集有很大的區別:它的圖像是灰度的,大部分是由0組成,用簡單的模型進行分類,準確率就可以達到99%以上。

還有五花八門的度量指標,啥也不說了,直接上圖。

當然,還有諸如數據預處理、調參策略等一系列問題,都會導致結果的不同。

研究一作Davis Blalock表示:

這些改進都是所謂的“微調”,而不是科研人員聲稱的“核心創新”,甚至有些改進方法可能根本就不存在。

于是乎,MIT的研究人員便開發了一套 方便開發、 標準化評價神經網絡的剪枝方法。

ShrinkBench提供了標準化和可擴展的功能,可以用于訓練、剪枝、微調、計算度量和繪圖,而且都是使用 標準化的預訓練模型和數據集。

正如另一位作者John Guttag所說:

如果你不能衡量某種東西,就很難讓它往好的方向發展。

好了,現在要是再想在剪枝算法上,稍微搞個小進展就水一篇論文,可能不再那么容易了。

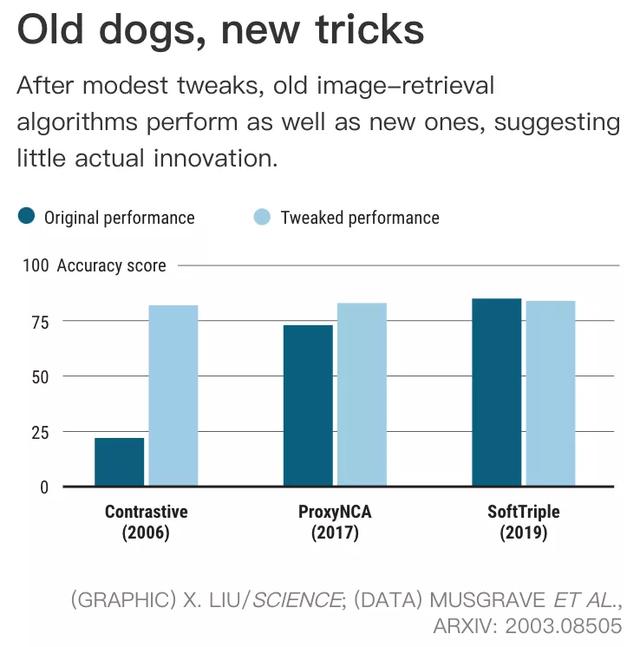

最近,Science也針對“水論文”一事發表文章,認為人工智能領域中的許多分支,其發展都是不穩定的:

正如Musgrave表示:

炒作浪潮一直存在。

反觀那些經久不衰的算法,像 LSTM,自1997年被提出后,在語言翻譯任務中取得了重大突破。

如果LSTM得到適當的訓練,它的性能就能和20年后(現在)的算法相當。

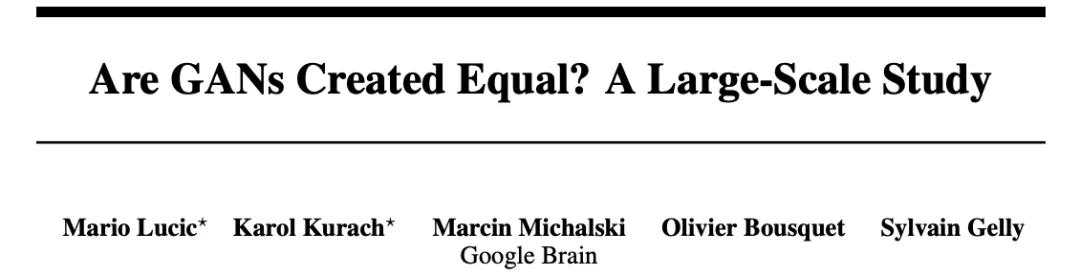

類似的還有像2014年提出的 GAN,大幅提高了生成圖像的能力。在2018年的一篇報告稱,只要有足夠的計算量,原有的GAN方法可以與后來的方法相媲美。

對此,Kolter認為,研究人員應當熱衷于開創全新的算法,讓這個新算法達到SOTA效果,而不是對現有算法做調整。

那么,如今這種論文灌水背后的原因,又是什么呢?

其中一個因素,便是MIT研究人員所指出的 評估標準問題——數據集不同、調整方法不同、性能指標和基線都不同,這種比較是不可行的。

而另外一個原因,便是 AI領域的爆炸性增長,論文數量遠超有經驗的審稿人數,評審人員應當堅持跟一個合理、科學的基準,做更好的比較。

以為學術亂象只有這些?

不,還有一股“造假風”。

5月20日,國外網友便曝出了一個學術造假大事件:

8篇文章,不同作者,不同醫院,不同癌癥種類,不同蛋白表達,愣是完全一樣的結果,發了8篇論文。

UAB醫學院糖尿病中心博士后研究員、營養學博士,微博網友“晨光us”對此表示:

如此喪心病狂的造假,簡直讓人看得窒息。

然而,更令人悲哀的是,論文作者全部來自中國……

而且從文章署名來看,從一線醫生到主任副主任醫師、醫院副院長,還有多篇是國家自然科學基金資助。

如此造假,簡直不簡單。

網友也表示:

突破了我對學術造假的所有認知。

無獨有偶,前不久在知乎中還曝出南京郵電大學教授,三年半發表300篇IEEE論文,一時成為熱議話題。

其弟子“黃同學”論文造假、冒充北大學生,也一并上了熱搜。

……

如此學術亂象,你怎么看?

傳送門:

ShrinkBench項目地址:

https://github.com/jjgo/shrinkbench

ShrinkBench論文地址:

https://arxiv.org/abs/2003.03033

參考鏈接:

https://www.sciencemag.org/news/2020/05/eye-catching-advances-some-ai-fields-are-not-real

https://weibo.com/roger1130?referflag=0000015010&from=feed&loc=nickname&is_hot=1#_rnd1591086111501

https://twitter.com/MicrobiomDigest/status/1266140721716719616

https://www.zhihu.com/question/397548354/answer/1248933002

https://www.toutiao.com/i6835125799020921355/

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。