您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

圖片來源@全景視覺

鈦媒體注:本文來源于微信公眾號硅兔賽跑(ID:sv_race),作者丨Molly Fosco,編譯丨Vivian,責編丨Lu,鈦媒體經授權發布。

在阿巴拉契亞山脈下田納西州長大的Alice Xiang,是在以白人為主的學校里為數不多的亞裔學生之一。

隨著她進入“高級班”,她發現同齡人越來越多地來自中上層家庭。她的許多小學同學,家庭背景不那么優越的,走上了前途機會較少的路。

這段經歷讓Xiang記憶猶新,因為她后來考上了哈佛、牛津、耶魯等精英大學。事實上,這也是她現在作為Partnership on AI(PAI)的研究科學家,專門研究算法公平性的主要原因之一。

她說,在田納西州長大的經歷,讓她認識到標簽和類別 "可能無法充分反映個體的復雜性和潛力"。

當Xiang開始職業生涯時,在第一次訓練機器學習算法的時候,她發現她個人認為相關的數據會很大程度上影響這個過程。而她的同事們亦是如此。

"這讓我很不舒服,圍繞這些算法做決定的人都住在大城市,上過研究生,而且不會與和他們身份背景有很大不同的人有什么來往,"她說。值得注意的是,她的同事中很少有女性或少數族裔。

從事技術工作的女性相當稀少是一個有據可查的話題,而且這個狀況幾乎沒有被改善。 與整個行業的其他技術角色相比,如網絡開發、用戶體驗設計或數據科學,女性在人工智能領域的比例尤其令人擔憂。

而來自谷歌、蘋果、Facebook等科技巨頭的專家,以及該領域的許多研究人員都表示,人工智能將徹底改變我們生活的方方面面。

人工智能描述了計算機將人類智慧融入其決策的能力。現代人工智能算法是在大型數據集上進行訓練,在模式識別的基礎上學習技能,然后預測下一步應該怎么做。機器學習作為人工智能的一個子集,正越來越多地被用于解決各行各業的問題。

在許多不斷交互的設備和服務中,人工智能已經無處不在:iPhone上的Face ID、亞馬遜上推薦購買產品、Spotify上推薦你可能喜歡的歌曲、信用卡的自動欺詐檢測,控制建筑物的供暖和制冷,安排飛機起飛和到達時間等等。

一些專家預測,技術奇點,即人工智能將與人類平起平坐,甚至比人類更聰明的那一刻,可能會出現在我們有生之年。有人認為可能最快#30年,也有人說可能需要幾個世紀。

如果這種 "通用人工智能 "成為現實,那么像法律助理、放射科醫生、招聘經理等工作都被預測會更加自動化。世界經濟論壇預測,到2022年,自動化將取代7500萬個工作崗位,并產生1.33億個新崗位。

盡管人工智能在經濟上大有可為,但如今,女性在全球人工智能專業人員中僅占22%。

根據LinkedIn和世界經濟論壇的分析,機器學習研究人員中只有12%是女性。 可能有一天會雇用我們,支配我們的醫療,并在審判中決定判決的技術,幾乎完全是從白人、受過良好教育的男性角度設計的。

這種人工智能領域的同一性已經對社會看待女性和少數族裔的方式、這些群體的待遇以及他們能夠參與行業的方式產生了微妙的影響。如果不做任何改變,我們就有可能繼續加固社會對女性和少數群體的固有偏見。

已經有證據表明,邊緣化群體在就業、獲得信貸和貸款,及獲得適當的醫療服務方面處于嚴重的不利地位,如果不加以制止,隨著行業的發展,這種情況只會越來越嚴重。

大多數批判人工智能的人是女性和少數群體,因為他們更有可能遭遇到算法上的不公正。

但越來越多從事人工智能和機器學習的人致力于確保上面描述的未來不會成為現實。研究人員開始呼吁關注人工智能倫理學,該領域涉及設計“負責任”的人工智能。而許多研究都是由女性,包括少數族裔女性完成的。

越來越多的人關注人工智能對社會的影響,迫使人工智能領域囊括除了計算機科學家以外,其他學科的研究人員,尤其是社會科學和人文學科的人員。

AI倫理學需要思考并優先考慮技術的社會學和心理學影響。隨著道德和公平對人工智能的未來越來越重要,這個未來可能會讓更多不同背景的人加入到這個領域,讓消費者享受到更大的包容性。

"Siri,今天的天氣怎么樣?""舊金山今天最高氣溫將達到55度,大部分時間是晴天。"

當你在腦海中讀出Siri剛才的回答時,很有可能是個女人的聲音。

"人們可以選擇將Siri的聲音改為男性,但基本不會有人改。"舊金山大學應用數據倫理中心主任Rachel Thomas說。Rachel Thomas是fast.ai的創始人,fast.ai是一個免費的在線程序,供編碼人員使用人工智能工具。

亞馬遜的Alexa和微軟的Cortana也是默認女性聲音和女性名字。"男性和女性都表現出對女性助手的偏好,我們對女性做助手感到安心。"Thomas說。

在人工智能語音助手之前,2008年印第安納大學的研究發現,與男性或電腦語音相比,男性和女性都表現出對女性聲音的偏好。亞馬遜和微軟公開表示,在對其語音助手產品的研究和測試中,女性聲音的測試效果更好。

影響已經很明顯了。2019年5月, 聯合國教科文組織發布的一項研究發現,語音助手性別為女性,強化了女性愿意為他人服務的刻板印象。

"這是人工智能帶來的風險的一個例子,"Thomas說。"我們在審視當下的社會,鎖定它,并且強化它。"

旨在提高人工智能多樣性的教育性非營利組織AI4ALL的CEO Tess Posner對此表示贊同。"人工智能展現了我們與生俱來的偏見,"她說。"助理工作被認為是一個女性角色,所以通過讓語音助手聽起來是女性,AI正在放大現有的偏見。"

這些產品的締造者并非完全沒有女性的身影,創建亞馬遜Alexa的二人組中,Toni Reid是女性。但人工智能語音助手設計者中,做決策的人,絕大部分是白人和男性。

截至2018年,亞馬遜全球僅有26.8%的管理者為女性,73.2%的管理者認定為男性。當年,彭博社還報道稱,在每周一次的亞馬遜AWS會議上,在200名亞馬遜員工介紹最新成果時,會議房間中幾乎不會有超過5名的女性。

Siri最初是由三個男性打造的。在全球范圍內,蘋果的技術員工中男性占77%。49%是白人,35%是亞裔,8%是西班牙裔,6%是黑人。

當蘋果第一次推出Siri時,如果告訴她你心臟病犯了,她會打電話給911,但對強#奸或家庭暴力,她沒有任何反應。如果告訴Siri你被強#奸了,她會回答:"我不知道你說的'我被強#奸了'是什么意思。"

而在2019年初,如果你說:"嘿,Siri,你是個bitch",她會回答:"如果可以,我會臉紅"。這些后來都在更新中被修改了,但這表明她最初設計的世界觀是有限的。

"我們還有很多事情要做,識別偏見,并確保我們正在解決這些事情,"Posner說。"這很好,但歸根結底,這關系到權力,以及誰在建立這些系統。"

不僅僅是Siri和Alexa,人工智能可以以無數種方式放大和強化我們現有的偏見。

2015年,華盛頓大學發布的一項研究發現, 在谷歌圖片上搜索 "CEO "時,結果幾乎全是男性。僅有11%的圖片是以女性為主角的,盡管在當時,女性在美國的CEO中占27%。

根據Pew Research Center的數據,截至2019年,美國女性CEO的數量增加到28%,而在谷歌 "CEO"的圖片結果中,以女性為主角的比例下降到10%。

當你在谷歌中輸入圖片的搜索查詢時,搜索算法會讀取網上數十億張圖片的相關元數據,找到最常見的圖片,并將其挑出來。各種工作的形象搜索結果反映了公司、組織和媒體選擇代表這些職業的形象。

"有人認為,這是因為現在很多CEO都是男性,"Thomas說,"但這也強化和放大了我們的固有觀念,即男性是CEO。"

研究證明了這一點。華盛頓大學2015年的同一項研究發現,搜索圖像結果中的性別刻板印象影響了人們對某一領域男性和女性工作人員比例的看法。

"它實際上改變了人們對自己想法的思考方式。"Socos實驗室的創始人Vivienne Ming博士說,該實驗室是一個專注于人工智能、神經科學和教育改革的智庫。"隨著這些系統的不斷循環,它們變成了這個閉環,強化了我們自己的偏見。"

然而,如何解決這個問題并沒有形成明確的共識。"如果所有的語音助手都是女性,那就有問題了,但什么是公平的地帶呢?"Xiang說。"同樣,對于CEO的圖像搜索結果,五五開就是最有意義的做法嗎? 應該展示我們實際看到的?還是應該介于兩者之間?"

如果算法是在有偏見的數據上訓練出來的,我們如何創造公平的算法呢?一個選擇是使用額外的數據集,提供模型的偏倚程度,然后相應地重新平衡數據集,Xiang說。

例如,《美國藥物和酒精濫用期刊》(American Journal of Drug and Alcohol Abuse)發表的數據顯示, 黑人和白人使用和銷售毒#品的比例相似,但黑人因與毒#品有關的犯罪而被捕的可能性大約是白人的2.6倍。前者的數據可以用來調整后者的數據集。

2017年,倫敦的AI研究員Josie Young開發了女性主義聊天機器人設計流程,以幫助組織建立符合道德或社會意識的聊天機器人和AI界面。她的指導方針成為一個名為F'xa的女權主義聊天機器人的中心思想,該聊天機器人由一個名為Feminist Internet的組織創建,旨在教育用戶將偏見嵌入人工智能系統的風險。

問題是,要想把 "公平 "建立在人工智能系統中,就必須對這個概念進行量化思考。而對于公平的含義,研究者也有不同的定義。

Vivienne Ming博士對此表示贊同。"當人們談論人工智能的公平性時,他們的意思有所不同,"她說,"有時候他們在談論透明度,即算法是如何運作的。有時候,他們在談論算法的結果,或者,是如何訓練的。公平是很難定義的。"

除了社會對女性及少數族裔的看法之外,人工智能還能對女性和其他邊緣化群體的待遇產生潛移默化的影響。

AT&T、希爾頓和Humana等公司已經在招聘過程中使用了人工智能,以確保申請人符合職位的基本標準。

2018年, 亞馬遜的機器學習專家發現,他們的招聘算法對包含 "女性 "一詞的技術職位的簡歷進行了降級,并“懲罰”了兩所全女性大學的畢業生。該算法是根據亞馬遜10年來的招聘數據進行的訓練,其中技術崗位的人員大多為男性。

"在招聘中,我們往往希望,如果把簡歷中的性別完全擦掉,人工智能就不會學習這些偏見。"Xiang說。但如果訓練數據中的候選人池中有更多的男性,那么 "人工智能就會面臨明顯的挑戰,即偏向男性而非女性"。

這樣的結果不僅僅發生在招聘中。

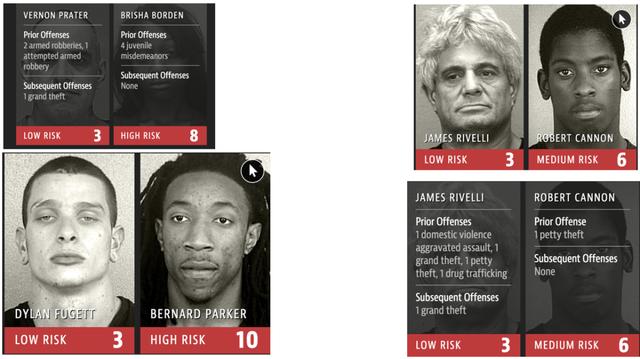

在刑事風險評估中,人工智能被用來確定某人再次犯罪的可能性,然后法官在判刑時將其考慮在內。和招聘算法一樣,犯罪風險評估工具通常是根據歷史數據進行訓練的, 根據司法統計局的一份報告,美國黑人比白人或西班牙裔更容易被警察攔截。

谷歌倫理人工智能團隊的研究科學家Timnit Gebru指出,大多數批評人工智能的人都是女性和少數族裔,因為他們更有可能遭遇算法上的不公正。"來自邊緣化群體的人們一直在真正努力地將這一問題推到大眾面前。"

2018年,麻省理工學院研究人員Joy Buolamwini發現,世界上使用最廣泛的面部識別工具IBM、微軟和Face++,錯誤識別女性面孔的次數比男性面孔多,很多時候,它們根本無法檢測到深色皮膚的面孔。

這意味著,當面部識別用于安全監控時,婦女和少數族裔可能比白人男子更經常地被識別為威脅。

"這些系統正在被無形地嵌入我們的社會,"Posner說,"這不僅僅放大了我們心中的一些偏見,這些系統可能會改變生活。"

人工智能很難處理沒有整齊劃一地歸入規定類別的情況。

身為跨性別女性的Vivienne Ming博士,親身經歷了AI難以讀懂自己的性別。"當我在美國機場通過全身掃描儀時,我總是會被標記,因為我的臀部和肩部的比例對于一個女性來說是不正常的。"當我被標記時,安檢工作人員會把手伸進我的兩腿之間,這太不公平了。"

更多樣化的勞動力是否會改善這些問題?"當然,在某種程度上,"Ming博士說,"AI只是一個工具,只能做它的指揮者知道的事情。"

而解決方案并不是簡單地在AI領域雇傭更多的女性。"這可能會引起爭議,"她說,"但 如果你認為雇傭更多的女性(在人工智能領域)會神奇地解決這個問題,你就錯了。"

Ming博士認為,我們需要的是更多了解算法如何影響人類的人。其他專家表深表贊同,并正在努力做到這一點。

AI研究者Abeba Birhane認為,人工智能應該優先考慮的是理解而不是預測。

我們不應該只依賴算法預測模式,而應該經常質疑為什么會出現一些固定的模式。例如,為什么刑事風險評估工具顯示黑人和棕色人種更容易被逮捕?會不會是他們的社區過度治安的結果?

谷歌Brain的研究科學家Been Kim正在開發能夠自我解釋的人工智能軟件,增加人類對技術運作的理解。

她最近建立了一個系統,作為 "人類的翻譯",能理解人工智能什么時候沒有按照它應該做的方式工作。例如,如果一個人工智能系統被訓練成在圖像中識別斑馬,你可以使用這個工具來了解人工智能在做出決定時對 "條紋 "的權重。

"不必了解人工智能模型的每一件事,"Kim說,"但只要你能了解到安全使用這個工具的信息,那就是我們的目標。"

隨著自動化越來越普及,那些需要與機器互動的工作,比如建筑和工廠的工作,正在迅速減少。另一方面,像醫療保健和社會工作等大量使用人際關系技能的工作正在快速增長。

約克大學2018年的一項研究發現,在過去的25年里,受過大學教育的男性從事白領工作的概率下降,而受過大學教育的女性從事白領工作的概率上升。轉變的最大原因是什么?醫生、軟件工程師和經濟學家等工作對社交技能的需求增加。

這些工作需要相對高的情商(emotional intelligence),而情商是相當難自動化的。多項研究表明,女性在EI測試中的得分高于男性,包括EI的每一個子量表,比如理解、表達和感知情緒。

這并不是說每個女人都比每個男人有更高的EI,也不是說這些特征是生理性的。一些研究表明,女性更有可能因為受到社會條件的制約,而去培養自己的這些特質。

如果倫理學這個同樣需要高水平EI的領域,繼續對人工智能領域變得越來越重要,這種需求可能會吸引更多的女性進入這個行業。根據美國國家科學基金會的研究,自上世紀90年代初以來,女性在美國所有社會科學家中至少占了一半或更多。

"在PAI,我們和女性研究人員合作很多,專注于人工智能的倫理和透明度。"Xiang說,"在這些研究領域,女性的比例是相當高的"。

Xiang自身的背景磨礪了她的EI技能,她在進入世界級精英大學之前,是在邊遠地區長大的。這些成長經歷影響著她后來對于算法公平性的研究。 一個人工作做得好或拖欠貸款的可能性有多大?不能僅靠歷史數據來確定。

Xiang認為,領域專業性,即某一領域的專業知識,對人工智能行業也變得越來越重要。她遇到的很多同事都是STEM專業的,大學畢業后從事與STEM不直接相關的工作,后來又轉型做人工智能。

Xiang在從事人工智能工作之前曾從事統計、經濟、法律等工作,她在這些領域有了自己的專長,現在將這些專長運用到了研究中。

Thomas和丈夫一起運營fast.ai,她希望讓人工智能掌握在不同領域非常廣泛和多樣化的人群手中。"我們相信相關領域的專家是最熟悉自己問題的人,"Thomas說,"我們教這些不同領域的專家使用深度學習,而不是找一個對其他領域感興趣的深度學習領域的博士。"

Thomas的幾位fast.ai學生正在其專業領域使用人工智能來改善他們領域內的研究。人類長壽研究所機器學習主任、fast.ai校友Alena Harley正在利用AI算法為轉移的癌癥識別源頭。在最近的試驗中,Harley將錯誤率降低了超過30%。

當你問Siri什么是女權主義價值觀時,她會回答:"我在網上找到了這個。"并根據受歡迎程度調出搜索結果。很多時候,出現率最高的一篇文章是職業指導顧問寫的,標題是 "什么是女權主義,為什么那么多女人和男人討厭它?"

女權主義聊天機器人F'xa的答案略有不同。她會說, 女權主義價值觀對不同的人來說,可能意味著不同的東西,這取決于他們的背景和他們所面臨的挑戰。

原標題:Code Switch

作者:Molly Fosco

原文鏈接:

https://trix-magazine.com/global-affairs/code-switch/

https://www.toutiao.com/i6840586371678077447

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。