您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

Kafka Connect如何實現同步RDS binlog數據,很多新手對此不是很清楚,為了幫助大家解決這個難題,下面小編將為大家詳細講解,有這方面需求的人可以來學習下,希望你能有所收獲。

下面介紹如何在E-MapReduce上使用Kafka Connect實現同步RDS binlog數據

1. 背景

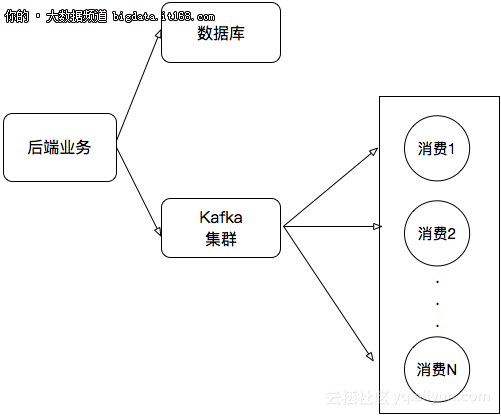

在我們的業務開發中,往往會碰到下面這個場景:

業務更新數據寫到數據庫中

業務更新數據需要實時傳遞給下游依賴處理

所以傳統的處理架構可能會這樣:

本文將演示如何在E-MapReduce上實現將RDS binlog實時同步到Kafka集群中。

2. 環境準備

實驗中使用VPC網絡環境,以下實例創建時默認都是在VPC環境下。

2.1 準備一個測試RDS數據庫

創建一個RDS實例,版本選擇5.7。這里不贅述如何創建RDS,詳細流程請參考RDS文檔。創建完如圖:

注意:RDS實例和E-MapReduce Kafka集群最好在同一個VPC中,否則需要打通兩個VPC之間的網絡。

3. Kafka Connect

3.1 Connector

Kafka Connect是一個用于Kafka和其他數據系統之間進行數據傳輸的工具,它可以實現基于Kafka的數據管道,打通上下游數據源。我們需要做的就是在Kafka Connect服務上運行一個Connector,這個Connector是具體實現如何從/向數據源中讀/寫數據。Confluent提供了很多Connector實現,你可以在這里下載。不過今天我們使用Debezium提供的一個MySQL Connector插件,下載地址。

下載這個插件,并將解壓出來的jar包全部拷貝到kafka lib目錄下。注意:需要將這些jar包拷貝到Kafka集群所有機器上。

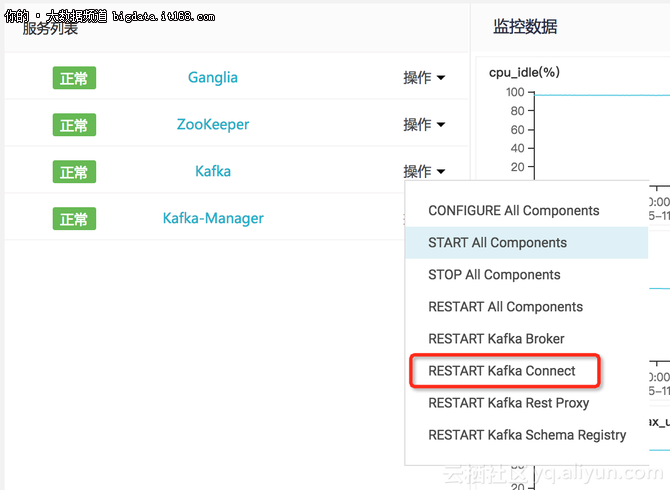

在Kafka集群的服務列表中重啟Kafka Connect組件。

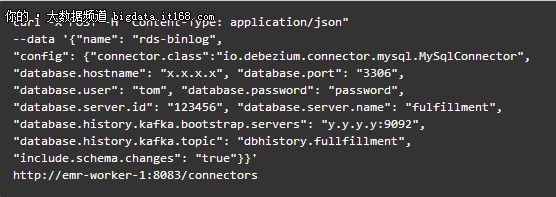

登錄到Kafka集群,配置并創建一個connector,命令如下:

3.3 注意事項

server_id是多少?:你可以在RDS執行"SELECT @@server_id;"查到。

創建connector時可能會出現連接失敗,請確保RDS的白名單已經授權了Kafka集群機器訪問。

4 測試

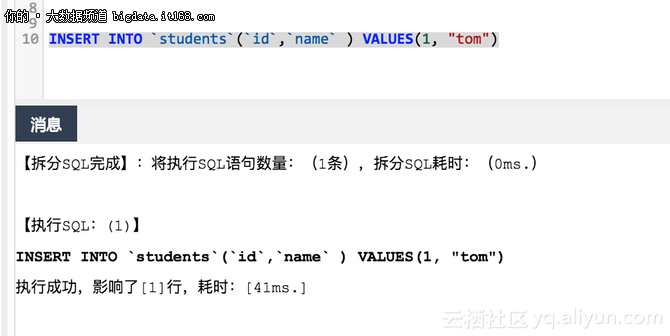

4.1 創建一張表

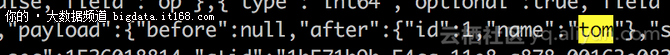

插入幾條數據

結果如圖所示:

看完上述內容是否對您有幫助呢?如果還想對相關知識有進一步的了解或閱讀更多相關文章,請關注億速云行業資訊頻道,感謝您對億速云的支持。

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。