您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

小編給大家分享一下Python3爬蟲中代理的使用方法,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

相對免費代理來說,付費代理的穩定性相對更高一點,本節介紹一下爬蟲付費代理的相關使用過程。

1. 付費代理分類

在這里將付費代理分為兩類:

提供接口獲取海量代理,按天或者按量付費,如訊代理

搭建了代理隧道,直接設置固定域名代理,如阿布云

本節講解一下這兩種代理的使用方法,分別以兩家代表性的代理網站為例進行講解。

2. 訊代理

訊代理個人使用過代理有效率還是蠻高的,此處非廣告,其官網為:http://www.xdaili.cn/。

有多種類別的代理可供選購,摘抄其官網的各類別代理介紹如下:

優質代理: 適合對代理IP需求量非常大,但能接受代理有效時長較短(10~30分鐘),小部分不穩定的客戶

獨享動態: 適合對代理IP穩定性要求非常高,且可以自主控制的客戶,支持地區篩選。

獨享秒切: 適合對代理IP穩定性要求非常高,且可以自主控制的客戶,快速獲取IP,地區隨機分配

動態混撥: 適合對代理IP需求量大,代理IP使用時效短(3分鐘),切換快的客戶

優質定制: 如果優質代理的套餐不能滿足您的需求,請使用定制服務

一般選擇第一類別優質代理即可,代理量比較大,但是代理的穩定性沒那么高,有一些代理也是不可用的,所以這種代理的使用方式就需要借助于上一節所說的代理池,我們自己再做一次篩選,確保代理可用。

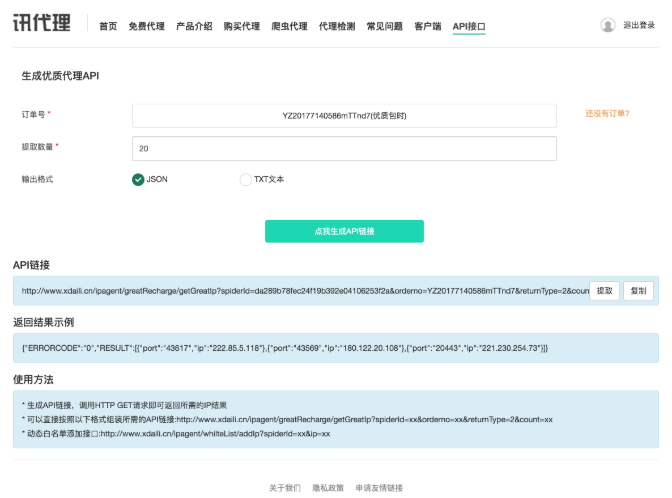

可以購買一天的試一下效果,購買之后會提供一個 API 來提取代理,如圖 9-6 所示:

圖 9-6 提取頁面

比如在這里我的提取 API 為:http://www.xdaili.cn/ipagent/greatRecharge/getGreatIp?spiderId=da289b78fec24f19b392e04106253f2a&orderno=YZ20177140586mTTnd7&returnType=2&count=20,可能已過期,在此僅做演示。

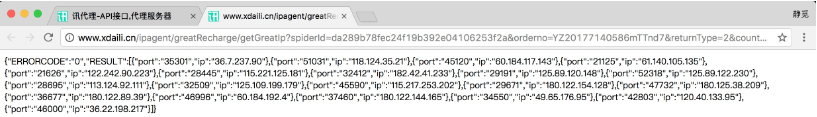

在這里指定了提取數量為 20,提取格式為 Json,直接訪問鏈接即可提取代理,結果如圖 9-7 所示:

圖 9-7 提取結果

接下來我們要做的就是解析這個 Json,然后將其放入我們的代理池中。

當然如果信賴訊代理的話也可以不做代理池篩選,直接使用,不過我個人還是推薦再使用代理池篩選一遍,提高可用幾率。

根據上一節代理池的寫法,我們只需要在 Crawler 中再加入一個 crawl 開頭的方法即可。

方法實現如下:

def crawl_xdaili(self):

"""

獲取訊代理

:return: 代理

"""

url = 'http://www.xdaili.cn/ipagent/greatRecharge/getGreatIp?spiderId=da289b78fec24f19b392e04106253f2a

&orderno=YZ20177140586mTTnd7&returnType=2&count=20'

html = get_page(url)

if html:

result = json.loads(html)

proxies = result.get('RESULT')

for proxy in proxies:

yield proxy.get('ip') + ':' + proxy.get('port')這樣我們就在代理池中接入了訊代理,獲取訊代理的結果之后,解析 Json,返回代理即可。

這樣代理池運行之后就會抓取和檢測該接口返回的代理了,如果可用,那么就會被設為 100,通過代理池接口即可獲取到。

以上以訊代理為例說明了此種批量提取代理的使用方法。

3. 阿布云代理

阿布云代理提供了代理隧道,代理速度快而且非常穩定,此處依然非廣告,其官網為:https://www.abuyun.com/,如圖 9-8 所示:

圖 9-8 阿布云官網

阿布云的代理主要分為兩種,專業版和動態版,另外還有定制版,摘抄官網的介紹如下:

專業版,多個請求鎖定一個代理 IP,海量 IP 資源池需求,近 300 個區域全覆蓋,代理 IP 可連續使用1分鐘,適用于請求 IP 連續型業務

動態版,每個請求一個隨機代理 IP,海量 IP 資源池需求,近 300 個區域全覆蓋,適用于爬蟲類業務

定制版,靈活按照需求定制,定制 IP 區域,定制 IP 使用時長,定制 IP 每秒請求數

關于專業版和動態版的更多介紹可以查看官網:https://www.abuyun.com/http-proxy/dyn-intro.html。

對于爬蟲來說,推薦使用動態版,購買之后可以在后臺看到代理隧道的用戶名和密碼,如圖 9-9 所示:

圖 9-9 阿布云代理后臺

可以發現整個代理的連接域名為 proxy.abuyun.com,端口為 9020,均是固定的,但是使用之后每次的 IP 都會更改,這其實就是利用了代理隧道實現。

其官網原理介紹如下:

云代理通過代理隧道的形式提供高匿名代理服務,支持 HTTP/HTTPS 協議。

云代理在云端維護一個全局 IP 池供代理隧道使用,池中的 IP 會不間斷更新,以保證同一時刻 IP 池中有幾十到幾百個可用代理IP。

需要注意的是代理IP池中有部分 IP 可能會在當天重復出現多次。

動態版HTTP代理隧道會為每個請求從 IP 池中挑選一個隨機代理 IP。

無須切換代理 IP,每一個請求一個隨機代理IP。

HTTP代理隧道有并發請求限制,默認每秒只允許 5 個請求。如果需要更多請求數,請額外購買。

注意默認套餐的并發請求是 5 個,如果需要更多需要另外購買。

使用的教程在官網也有,鏈接為:https://www.abuyun.com/http-proxy/dyn-manual-python.html,提供了 Requests、Urllib、Scrapy 的接入方式。

以 Requests 為例,接入示例如下:

import requests url = 'http://httpbin.org/get' # 代理服務器 proxy_host = 'proxy.abuyun.com' proxy_port = '9020' # 代理隧道驗證信息 proxy_user = 'H01234567890123D' proxy_pass = '0123456789012345' proxy_meta = 'http://%(user)s:%(pass)s@%(host)s:%(port)s' % { 'host': proxy_host, 'port': proxy_port, 'user': proxy_user, 'pass': proxy_pass, } proxies = { 'http': proxy_meta, 'https': proxy_meta, } response = requests.get(url, proxies=proxies) print(response.status_code) print(response.text)

在這里其實就是使用了代理認證,在前面我們也提到過類似的設置方法,運行結果如下:

200

{

"args": {},

"headers": {

"Accept": "*/*",

"Accept-Encoding": "gzip, deflate",

"Connection": "close",

"Host": "httpbin.org",

"User-Agent": "python-requests/2.18.1"

},

"origin": "60.207.237.111",

"url": "http://httpbin.org/get"

}輸出結果的 origin 即為代理IP的實際地址,可以多次運行測試,可以發現每次請求 origin 都會在變化,這就是動態版代理的效果。

這種效果其實跟我們之前的代理池的隨機代理效果類似,都是隨機取出了一個當前可用代理。

但是此服務相比于維護代理池來說,使用更加方便,配置簡單,省時省力,在價格可以接受的情況下,個人推薦此種代理。

以上是Python3爬蟲中代理的使用方法的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。