您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

小編給大家分享一下Python3爬蟲利器Scrapy的安裝方法,相信大部分人都還不怎么了解,因此分享這篇文章給大家參考一下,希望大家閱讀完這篇文章后大有收獲,下面讓我們一起去了解一下吧!

Scrapy是一個十分強大的爬蟲框架,依賴的庫比較多,至少需要依賴的庫有Twisted 14.0、lxml 3.4和pyOpenSSL 0.14。在不同的平臺環境下,它所依賴的庫也各不相同,所以在安裝之前,最好確保把一些基本庫安裝好。本節就來介紹Scrapy在不同平臺的安裝方法。

1. 相關鏈接

官方網站:https://scrapy.org

官方文檔:https://docs.scrapy.org

PyPI:https://pypi.python.org/pypi/Scrapy

GitHub:https://github.com/scrapy/scrapy

中文文檔:http://scrapy-chs.readthedocs.io

2. Anaconda安裝

這是一種比較簡單的安裝Scrapy的方法(尤其是對于Windows來說),如果你的Python是使用Anaconda安裝的,或者還沒有安裝Python的話,可以使用此方法安裝,這種方法簡單、省力。當然,如果你的Python不是通過Anaconda安裝的,可以繼續看后面的內容。

關于Anaconda的安裝方式,可以查看1.1節,在此不再贅述。

如果已經安裝好了Anaconda,那么可以通過conda命令安裝Scrapy,具體如下:

conda install Scrapy

3. Windows下的安裝

如果你的Python不是使用Anaconda安裝的,可以參考如下方式來一步步安裝Scrapy。

安裝lxml

lxml的安裝過程請參見1.3.1節,在此不再贅述,此庫非常重要,請一定要安裝成功。

安裝pyOpenSSL

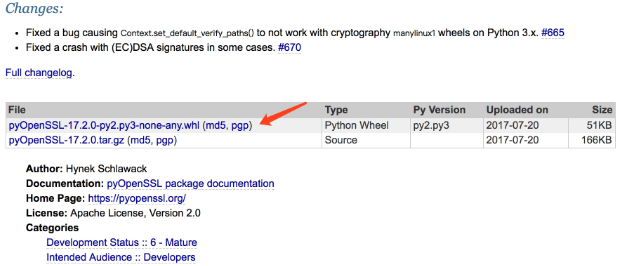

在官方網站下載wheel文件(詳見https://pypi.python.org/pypi/pyOpenSSL#downloads)即可,如圖1-76所示。

圖1-76 下載頁面

下載后利用pip安裝即可:

pip3 install pyOpenSSL-17.2.0-py2.py3-none-any.whl

安裝Twisted

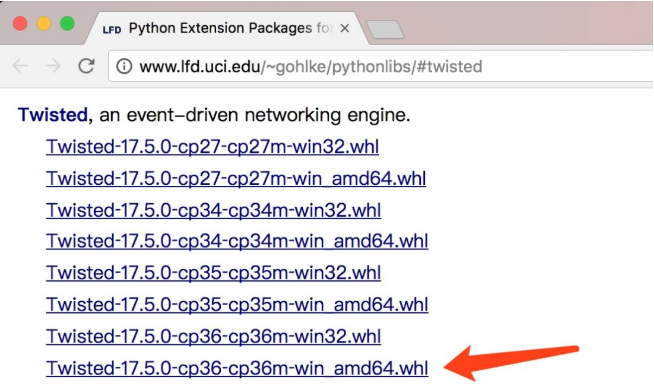

到http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted下載wheel文件,利用pip安裝即可。

比如,對于Python 3.6版本、Windows 64位系統,則當前最新版本為Twisted?17.5.0?cp36?cp36m?win_amd64.whl,直接下載即可,如圖1-77所示。

圖1-77 下載頁面

然后通過pip安裝:

pip3 install Twisted?17.5.0?cp36?cp36m?win_amd64.whl

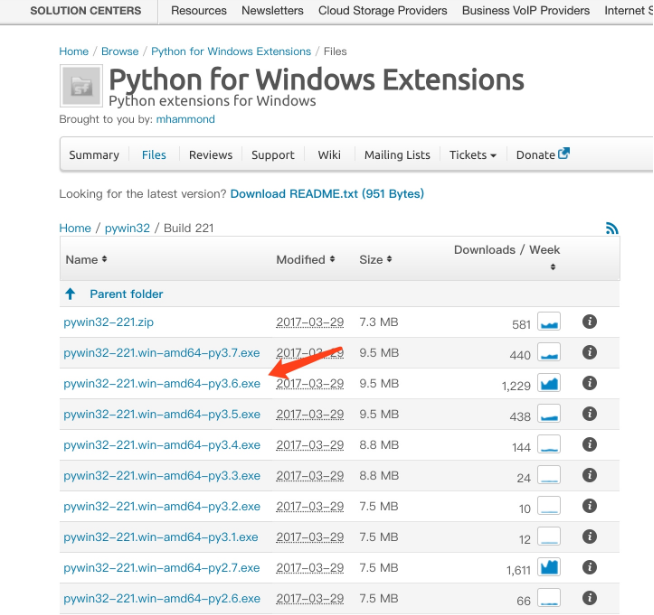

安裝PyWin32

從官方網站下載對應版本的安裝包即可,鏈接為:https://sourceforge.net/projects/pywin32/files/pywin32/Build%20221/,如圖1-78所示。

圖1-78 下載列表

比如對于Python 3.6版本,可以選擇下載pywin32-221.win-amd64-py3.6.exe,下載完畢之后雙擊安裝即可。

注意,這里使用的是Build 221版本,隨著時間推移,版本肯定會繼續更新,最新的版本可以查看https://sourceforge.net/projects/pywin32/files/pywin32/,到時查找最新的版本安裝即可。

安裝Scrapy

安裝好了以上的依賴庫后,安裝Scrapy就非常簡單了,這里依然使用pip,命令如下:

pip3 install Scrapy

等待命令結束,如果沒有報錯,就證明Scrapy已經安裝好了。

4. Linux下的安裝

在Linux下的安裝方式依然分為兩類平臺來介紹。

CentOS和Red Hat

在CentOS和Red Hat下,首先確保一些依賴庫已經安裝,運行如下命令:

sudo yum groupinstall -y development tools sudo yum install -y epel-release libxslt-devel libxml2-devel openssl-devel

最后利用pip安裝Scrapy即可:

pip3 install Scrapy

Ubuntu、Debian和Deepin

在Ubuntu、Debian和Deepin平臺下,首先確保一些依賴庫已經安裝,運行如下命令:

sudo apt-get install build-essential python3-dev libssl-dev libffi-dev libxml2 libxml2-dev libxslt1-dev zlib1g-dev

然后利用pip安裝Scrapy即可:

pip3 install Scrapy

運行完畢后,就完成Scrapy的安裝了。

5. Mac下的安裝

在Mac下,首先也是進行依賴庫的安裝。

在Mac上構建Scrapy的依賴庫需要C編譯器以及開發頭文件,它一般由Xcode提供,具體命令如下:

xcode-select --install

隨后利用pip安裝Scrapy即可:

pip3 install Scrapy

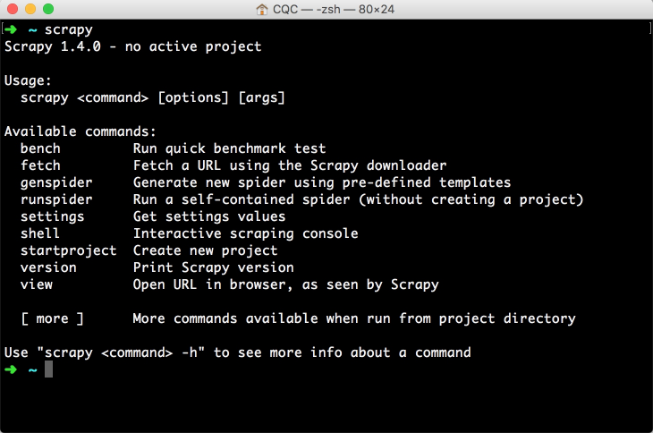

6. 驗證安裝

安裝之后,在命令行下輸入scrapy,如果出現類似如圖1-79所示的結果,就證明Scrapy安裝成功了。

圖1-79 驗證安裝

7. 常見錯誤

在安裝過程中,常見的錯誤匯總如下。

pkg_resources.VersionConflict: (six 1.5.2 (/usr/lib/python3/dist-packages), Requirement.parse('six>=1.6.0'))

這是six包版本過低出現的錯誤。six包是一個提供兼容Python 2和Python 3的庫,這時升級six包即可:

sudo pip3 install -U six

c/_cffi_backend.c:15:17: fatal error: ffi.h: No such file or directory

這是在Linux下常出現的錯誤,缺少libffi庫造成的。什么是libffi?FFI的全名是Foreign Function Interface,通常指的是允許以一種語言編寫的代碼調用另一種語言的代碼。而libffi庫只提供了最底層的、與架構相關的、完整的FFI。此時安裝相應的庫即可。

在Ubuntu和Debian下,直接執行如下命令即可:

sudo apt-get install build-essential libssl-dev libffi-dev python3-dev

在CentOS和Red Hat下,直接執行如下命令即可:

sudo yum install gcc libffi-devel python-devel openssl-devel

Command "python setup.py egg_info" failed with error code 1 in /tmp/pip-build/cryptography/

這是缺少加密的相關組件,此時利用pip安裝即可:

pip3 install cryptography

ImportError: No module named 'packaging'

這是因為缺少packaging包出現的錯誤,這個包提供了Python包的核心功能,此時利用pip安裝即可。

ImportError: No module named '_cffi_backend'

這個錯誤表示缺少cffi包,直接使用pip安裝即可:

pip3 install cffi

ImportError: No module named 'pyparsing'

這個錯誤表示缺少pyparsing包,直接使用pip安裝即可:

pip3 install pyparsing appdirs

以上是Python3爬蟲利器Scrapy的安裝方法的所有內容,感謝各位的閱讀!相信大家都有了一定的了解,希望分享的內容對大家有所幫助,如果還想學習更多知識,歡迎關注億速云行業資訊頻道!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。