溫馨提示×

您好,登錄后才能下訂單哦!

點擊 登錄注冊 即表示同意《億速云用戶服務條款》

您好,登錄后才能下訂單哦!

小編給大家分享一下Python爬取表格的步驟,希望大家閱讀完這篇文章后大所收獲,下面讓我們一起去探討方法吧!

Python爬取表格的步驟:

1、檢查url地址,用raise_for_status()檢查url地址;

2、爬取資源,用BeautifulSoup()爬取數據,并且用find_all('tr')抓取其中的表格;

3、保存資源,用write()將表格保存到指定目錄。

from bs4 import BeautifulSoup

import requests

import csv

import bs4

#檢查url地址

def check_link(url):

try:

r = requests.get(url)

r.raise_for_status()

r.encoding = r.apparent_encoding

return r.text

except:

print('無法鏈接服務器!!!')

#爬取資源

def get_contents(ulist,rurl):

soup = BeautifulSoup(rurl,'lxml')

trs = soup.find_all('tr')

for tr in trs:

ui = []

for td in tr:

ui.append(td.string)

ulist.append(ui)

#保存資源

def save_contents(urlist):

with open("D:/2016年中國企業500強排行榜.csv",'w') as f:

writer = csv.writer(f)

writer.writerow(['2016年中國企業500強排行榜'])

for i in range(len(urlist)):

writer.writerow([urlist[i][1],urlist[i][3],urlist[i][5]])

def main():

urli = []

url = "http://www.maigoo.com/news/463071.html"

rs = check_link(url)

get_contents(urli,rs)

save_contents(urli)

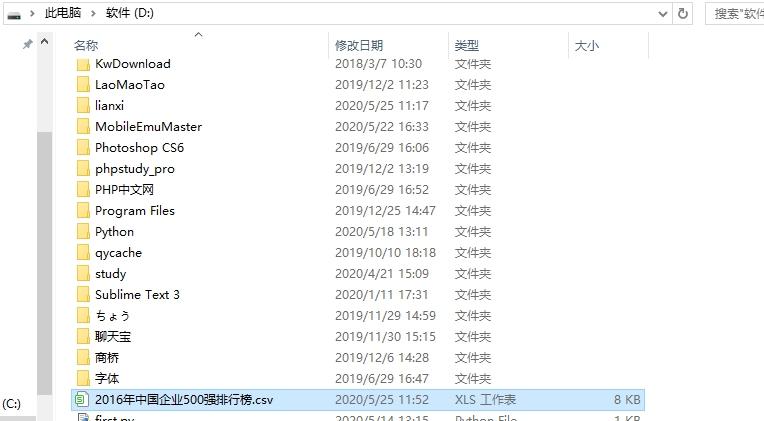

main()運行結果:

看完了這篇文章,相信你對Python爬取表格的步驟有了一定的了解,想了解更多相關知識,歡迎關注億速云行業資訊頻道,感謝各位的閱讀!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。