您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

本篇內容介紹了“分布式Ceph存儲集群集的詳細步驟”的有關知識,在實際案例的操作過程中,不少人都會遇到這樣的困境,接下來就讓小編帶領大家學習一下如何處理這些情況吧!希望大家仔細閱讀,能夠學有所成!

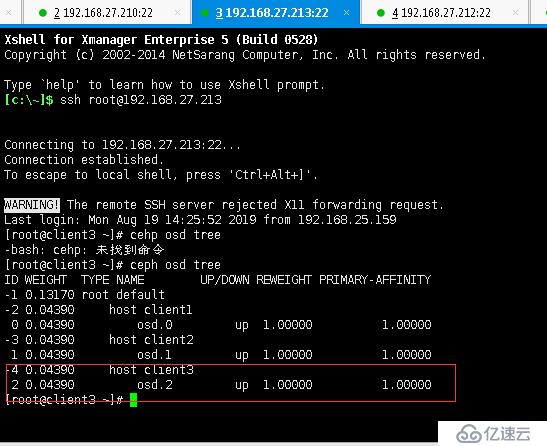

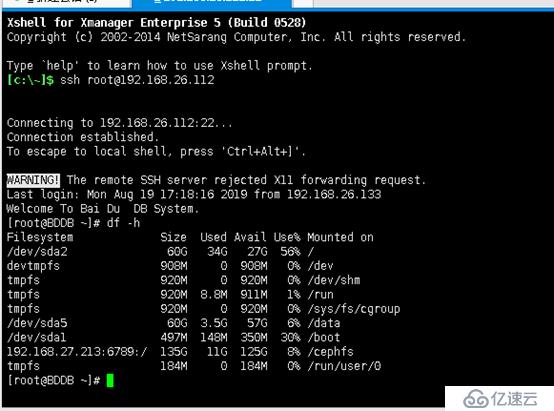

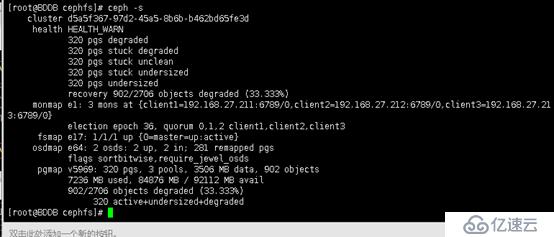

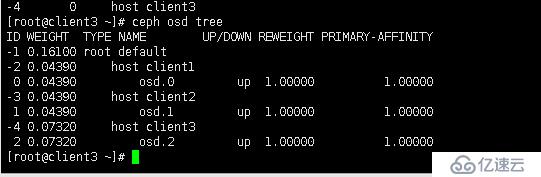

先上幾張圖展示下目前Ceph存儲的大體情況,模擬更換服務器CLIENT3上數據硬盤,ceph存儲設備已經有存放數據,觀察更換過程及恢復變化。

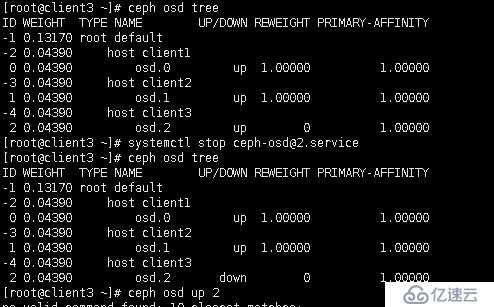

[root@client3 ~]# systemctl stop ceph-osd@2.service

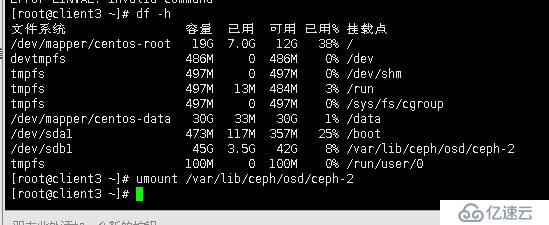

[root@client3 ~]# umount /var/lib/ceph/osd/ceph-2

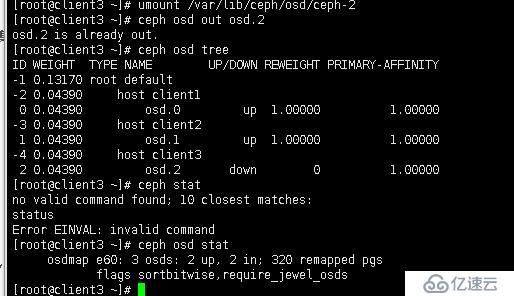

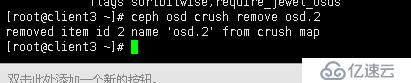

[root@client3 ~]# ceph osd out osd.2

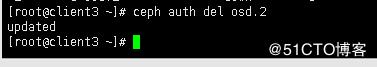

[root@client3 ~]# ceph auth del osd.2

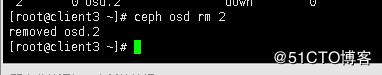

[root@client3 ~]# ceph osd rm 2

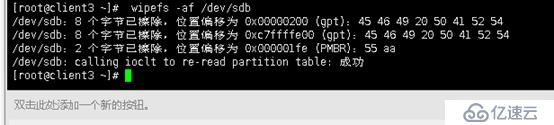

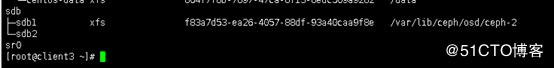

清空磁盤信息:

[root@client3 ~]# wipefs -af /dev/sdb

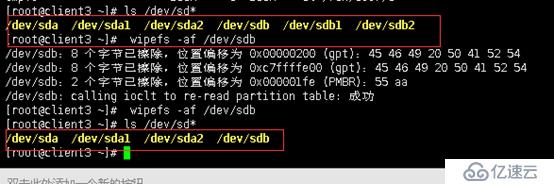

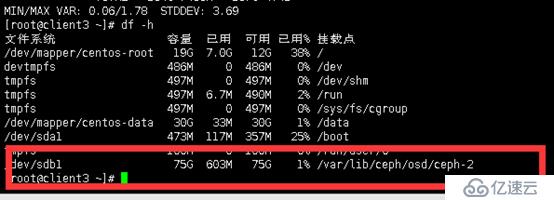

磁盤變化:(刪除舊磁盤,更換新盤,虛擬機中刪除后原50G硬盤,重新添加一個80G硬盤。

此時集群狀態

原硬盤50G更換后為80G

[root@master ~]# cd /data/idc-cluster/

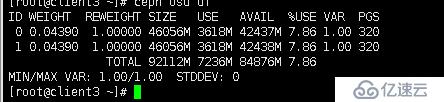

[root@master idc-cluster]# ceph-deploy osd prepare client3:/dev/sdb

存儲空間也變大了(原來為135G,更改硬盤后存儲空間為165G)。

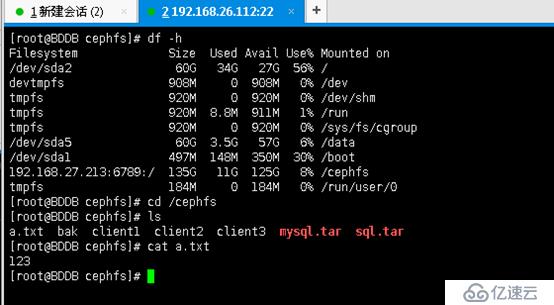

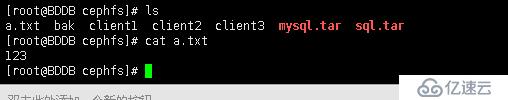

數據依然存在,無變化。

CEPH集群恢復中:

[root@BDDB cephfs]# ceph health

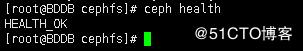

恢復完成:[root@BDDB cephfs]# ceph health

“分布式Ceph存儲集群集的詳細步驟”的內容就介紹到這里了,感謝大家的閱讀。如果想了解更多行業相關的知識可以關注億速云網站,小編將為大家輸出更多高質量的實用文章!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。