您好,登錄后才能下訂單哦!

您好,登錄后才能下訂單哦!

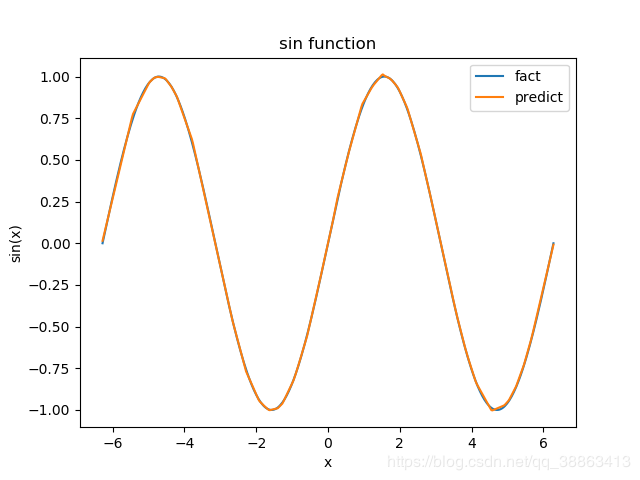

我們知道深度神經網絡的本質是輸入端數據和輸出端數據的一種高維非線性擬合,如何更好的理解它,下面嘗試擬合一個正弦函數,本文可以通過簡單設置節點數,實現任意隱藏層數的擬合。

基于pytorch的深度神經網絡實戰,無論任務多么復雜,都可以將其拆分成必要的幾個模塊來進行理解。

1)構建數據集,包括輸入,對應的標簽y

2) 構建神經網絡模型,一般基于nn.Module繼承一個net類,必須的是__init__函數和forward函數。__init__構造函數包括創建該類是必須的參數,比如輸入節點數,隱藏層節點數,輸出節點數。forward函數則定義了整個網絡的前向傳播過程,類似于一個Sequential。

3)實例化上步創建的類。

4)定義損失函數(判別準則),比如均方誤差,交叉熵等

5)定義優化器(optim:SGD,adam,adadelta等),設置學習率

6)開始訓練。開始訓練是一個從0到設定的epoch的循環,循環期間,根據loss,不斷迭代和更新網絡權重參數。

無論多么復雜的網絡,基于pytorch的深度神經網絡都包括6個模塊,訓練階段包括5個步驟,本文只通過擬合一個正弦函數來說明加深理解。

廢話少說,直接上代碼:

from torch.utils.data import DataLoader

from torch.utils.data import TensorDataset

import torch.nn as nn

import numpy as np

import torch

# 準備數據

x=np.linspace(-2*np.pi,2*np.pi,400)

y=np.sin(x)

# 將數據做成數據集的模樣

X=np.expand_dims(x,axis=1)

Y=y.reshape(400,-1)

# 使用批訓練方式

dataset=TensorDataset(torch.tensor(X,dtype=torch.float),torch.tensor(Y,dtype=torch.float))

dataloader=DataLoader(dataset,batch_size=100,shuffle=True)

# 神經網絡主要結構,這里就是一個簡單的線性結構

class Net(nn.Module):

def __init__(self):

super(Net, self).__init__()

self.net=nn.Sequential(

nn.Linear(in_features=1,out_features=10),nn.ReLU(),

nn.Linear(10,100),nn.ReLU(),

nn.Linear(100,10),nn.ReLU(),

nn.Linear(10,1)

)

def forward(self, input:torch.FloatTensor):

return self.net(input)

net=Net()

# 定義優化器和損失函數

optim=torch.optim.Adam(Net.parameters(net),lr=0.001)

Loss=nn.MSELoss()

# 下面開始訓練:

# 一共訓練 1000次

for epoch in range(1000):

loss=None

for batch_x,batch_y in dataloader:

y_predict=net(batch_x)

loss=Loss(y_predict,batch_y)

optim.zero_grad()

loss.backward()

optim.step()

# 每100次 的時候打印一次日志

if (epoch+1)%100==0:

print("step: {0} , loss: {1}".format(epoch+1,loss.item()))

# 使用訓練好的模型進行預測

predict=net(torch.tensor(X,dtype=torch.float))

# 繪圖展示預測的和真實數據之間的差異

import matplotlib.pyplot as plt

plt.plot(x,y,label="fact")

plt.plot(x,predict.detach().numpy(),label="predict")

plt.title("sin function")

plt.xlabel("x")

plt.ylabel("sin(x)")

plt.legend()

plt.savefig(fname="result.png",figsize=[10,10])

plt.show()

輸出結果:

step: 100 , loss: 0.06755948066711426

step: 200 , loss: 0.003788222325965762

step: 300 , loss: 0.0004728269996121526

step: 400 , loss: 0.0001810075482353568

step: 500 , loss: 0.0001108720971387811

step: 600 , loss: 6.29749265499413e-05

step: 700 , loss: 3.707894938997924e-05

step: 800 , loss: 0.0001250380591955036

step: 900 , loss: 3.0654005968244746e-05

step: 1000 , loss: 4.349641676526517e-05

輸出圖像:

到此這篇關于使用 pytorch 創建神經網絡擬合sin函數的實現的文章就介紹到這了,更多相關pytorch 創建擬合sin函數內容請搜索億速云以前的文章或繼續瀏覽下面的相關文章希望大家以后多多支持億速云!

免責聲明:本站發布的內容(圖片、視頻和文字)以原創、轉載和分享為主,文章觀點不代表本網站立場,如果涉及侵權請聯系站長郵箱:is@yisu.com進行舉報,并提供相關證據,一經查實,將立刻刪除涉嫌侵權內容。